| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 오블완

- aws #modernization #eks #k8s

- 타입 #type

- Exception

- k8s

- Trino

- trino #hive #sync

- pull

- Glossary #Python

- Python #PEP

- pep 740 #소프트웨어 공급망

- til #loguru #str #format

- crossfit_geeks #크로스핏 #crossfit #당산크로스핏 #크로스핏긱스 #running #역도 #오운완 #크로스핏터 #Django가 고장날때까지

- 티스토리챌린지

- 카프카

- merge

- 쿠버네티스

- pyenv

- fetch

- Python3 #PEP

- nodeport

- Push

- Git

- Today

- Total

Django가 고장날때까지

네트워크 스터디 9주차 - 1 본문

9주차 스터디 내용은 기존의 내용들의 조합들이었다. 다른 네트워크 cni 와 달리 aws vpc cni 가 가지는 특성에 대해 살펴보고, 쿠버네티스와 aws의 이기종간의 어떻게 협력하여 리소스를 통제하고, 서비스를 안정적으로 운영하는지 살펴봤다. 강의를 2번 봣는데, 다행히 나름 9주간 열심히 한거 같아서 더 자신감이 붙는다.

물론 ㅜㅜ 도전과제는 1주차에만 조금 하고, 못했지만 ㅜ 앞으로 복습하면서 도전과제도 꼭 해봐야겠다.

감사합니다. 종호님.

꼭 봐야하는 쿠버네티스 관련 글

https://aws.amazon.com/blogs/containers/spark-on-amazon-eks-networking-part-1/

Spark on Amazon EKS networking – Part 1 | Amazon Web Services

This post was co-authored by James Fogel, Staff Software Engineer on the Cloud Architecture Team at Pinterest Part 1: Design process for Amazon EKS networking at scale Introduction Pinterest is a platform that helps inspire people to live a life they love.

aws.amazon.com

Exposing Kubernetes Applications, Part 1: Service and Ingress Resources | Amazon Web Services

Introduction The Exposing Kubernetes Applications series focuses on ways to expose applications running in a Kubernetes cluster for external access. In this Part 1 of the series, we explore Service and Ingress resource types that define two ways to control

aws.amazon.com

https://medium.com/google-cloud/understanding-kubernetes-networking-pods-7117dd28727

Understanding kubernetes networking: pods

This post is going to attempt to demystify the several layers of networking operating in a kubernetes cluster. Kubernetes is a powerful…

medium.com

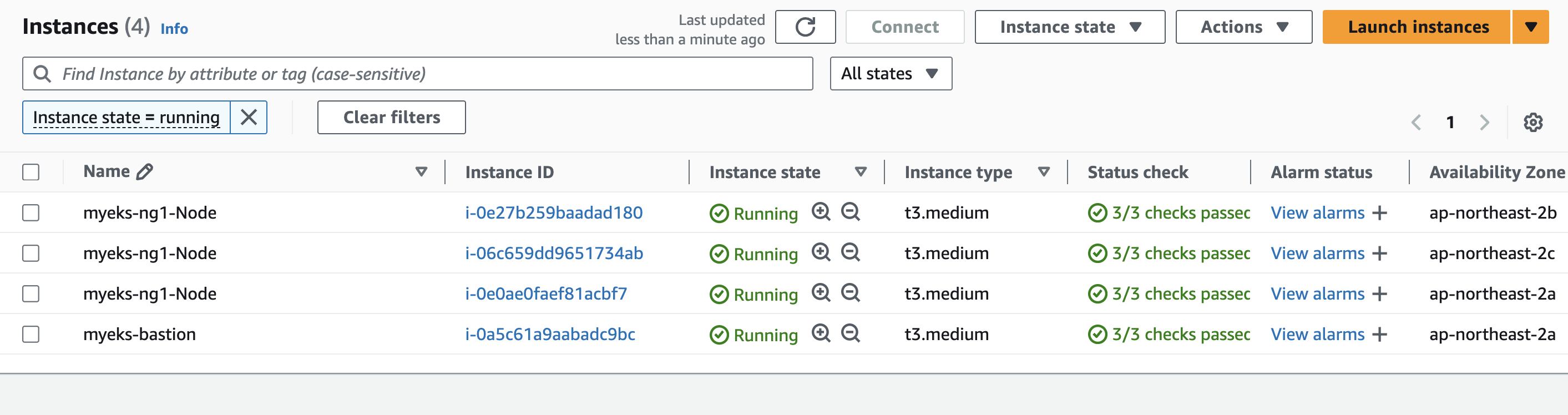

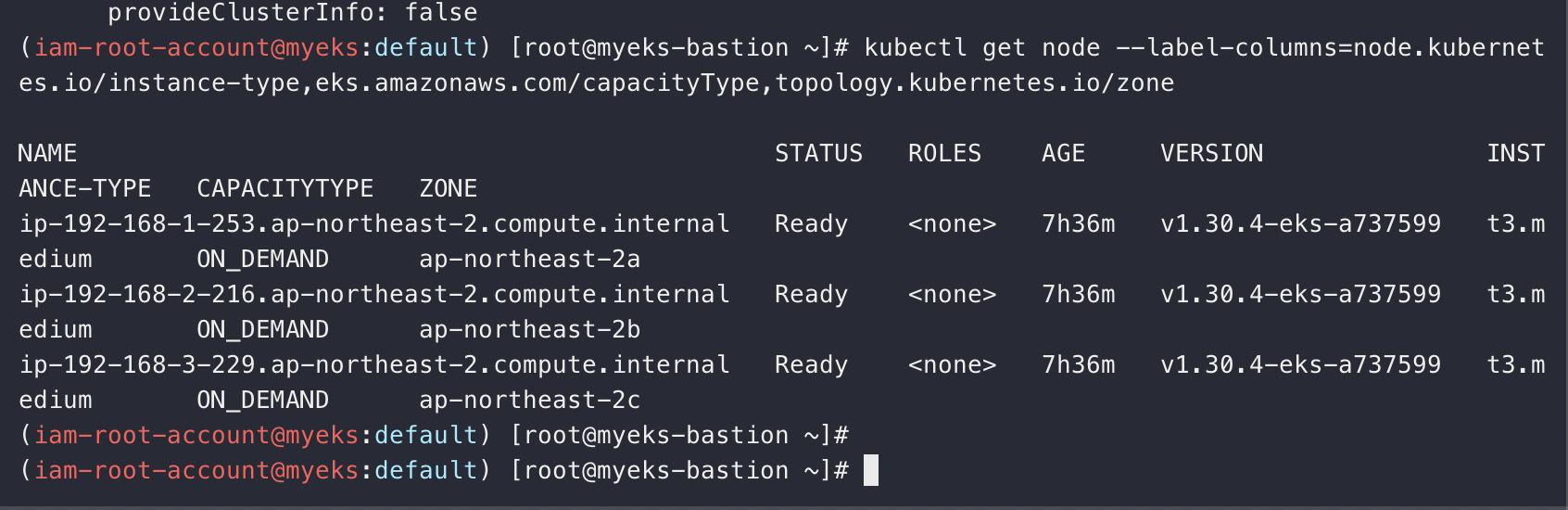

0. 실습환경 구성

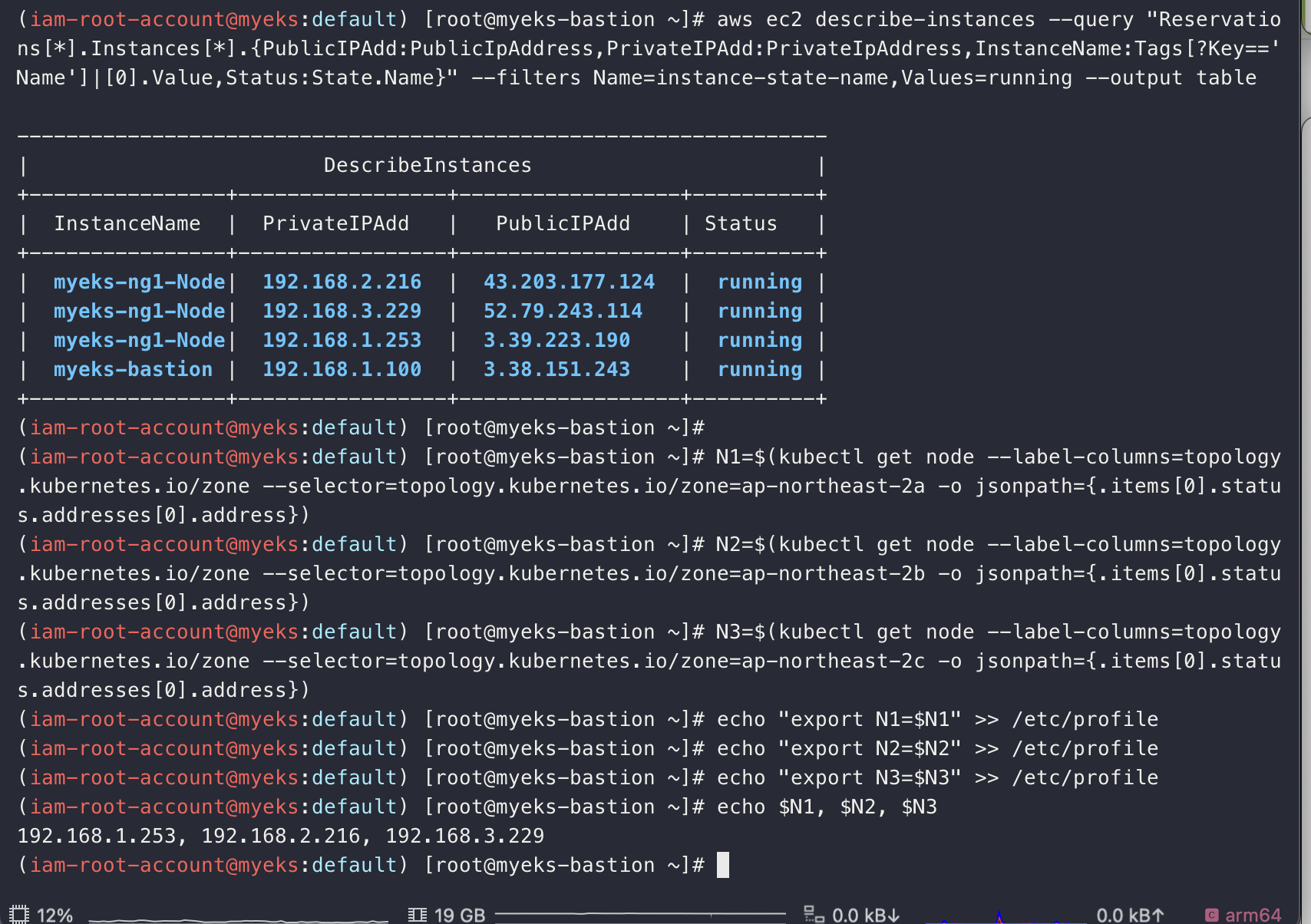

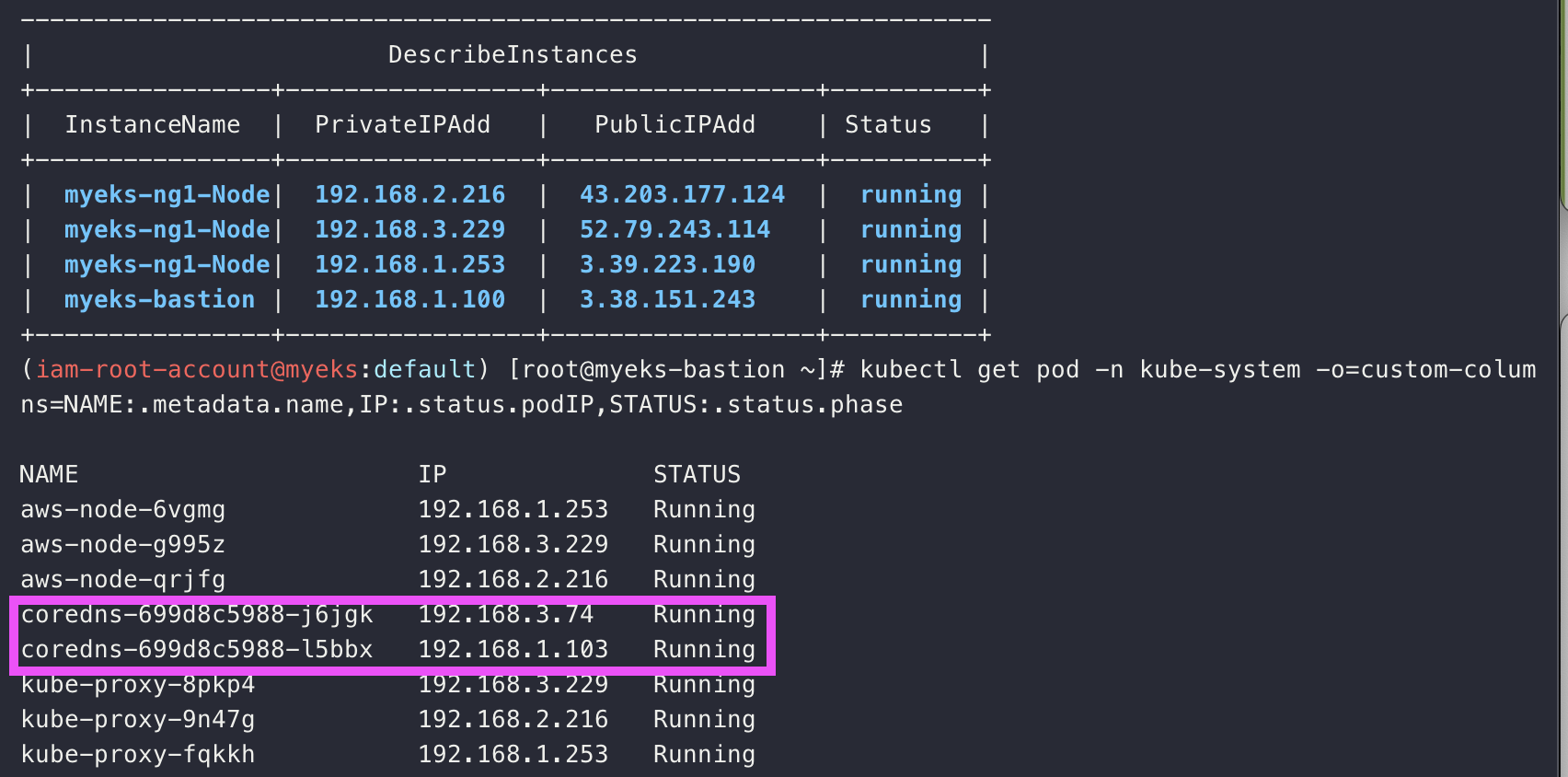

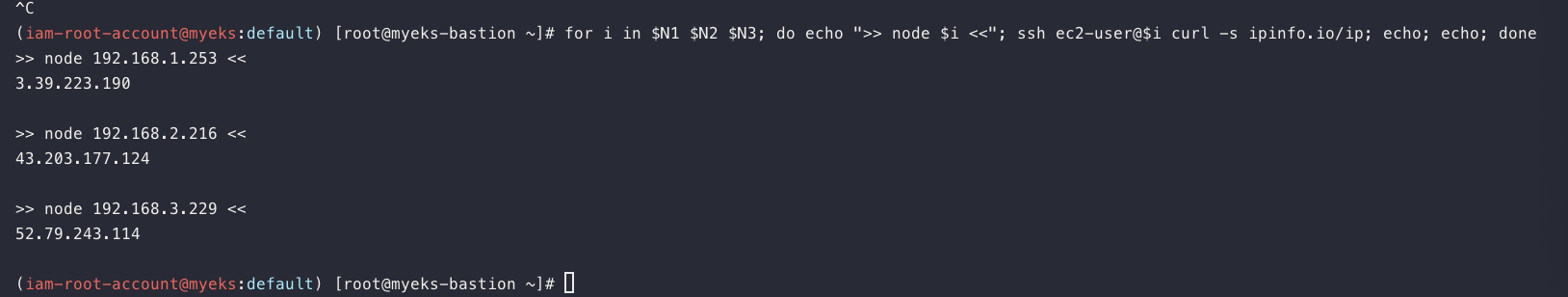

# 노드 IP 확인 및 PrivateIP 변수 지정

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

N1=$(kubectl get node --label-columns=topology.kubernetes.io/zone --selector=topology.kubernetes.io/zone=ap-northeast-2a -o jsonpath={.items[0].status.addresses[0].address})

N2=$(kubectl get node --label-columns=topology.kubernetes.io/zone --selector=topology.kubernetes.io/zone=ap-northeast-2b -o jsonpath={.items[0].status.addresses[0].address})

N3=$(kubectl get node --label-columns=topology.kubernetes.io/zone --selector=topology.kubernetes.io/zone=ap-northeast-2c -o jsonpath={.items[0].status.addresses[0].address})

echo "export N1=$N1" >> /etc/profile

echo "export N2=$N2" >> /etc/profile

echo "export N3=$N3" >> /etc/profile

echo $N1, $N2, $N3

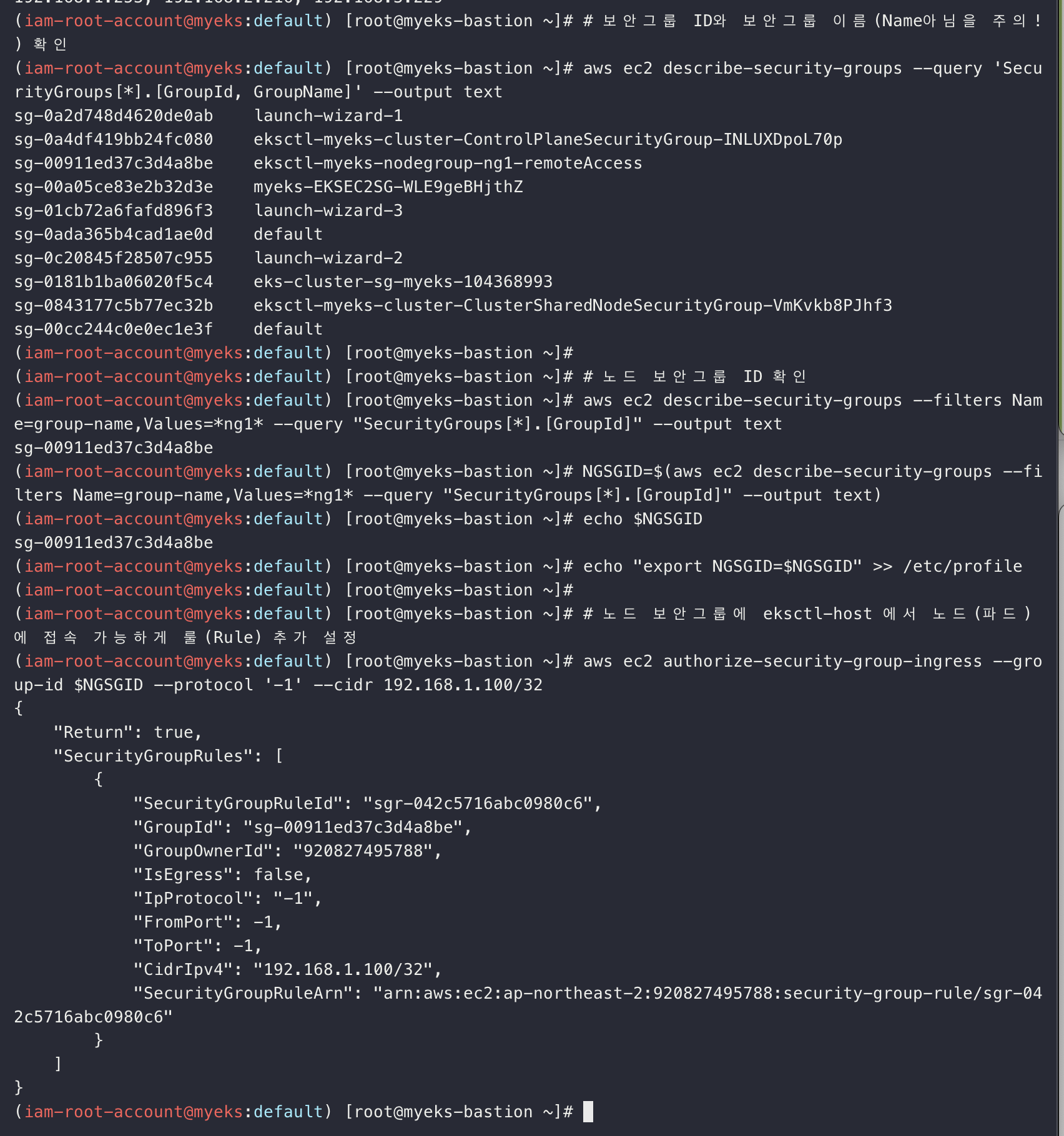

# 보안그룹 ID와 보안그룹 이름(Name아님을 주의!) 확인

aws ec2 describe-security-groups --query 'SecurityGroups[*].[GroupId, GroupName]' --output text

# 노드 보안그룹 ID 확인

aws ec2 describe-security-groups --filters Name=group-name,Values=*ng1* --query "SecurityGroups[*].[GroupId]" --output text

NGSGID=$(aws ec2 describe-security-groups --filters Name=group-name,Values=*ng1* --query "SecurityGroups[*].[GroupId]" --output text)

echo $NGSGID

echo "export NGSGID=$NGSGID" >> /etc/profile

# 노드 보안그룹에 eksctl-host 에서 노드(파드)에 접속 가능하게 룰(Rule) 추가 설정

aws ec2 authorize-security-group-ingress --group-id $NGSGID --protocol '-1' --cidr 192.168.1.100/32

기본적으로 bastion 은 eks에 속한 노드는 아니니까 접근할수 있도록 허용해줘야함

========================================================================================

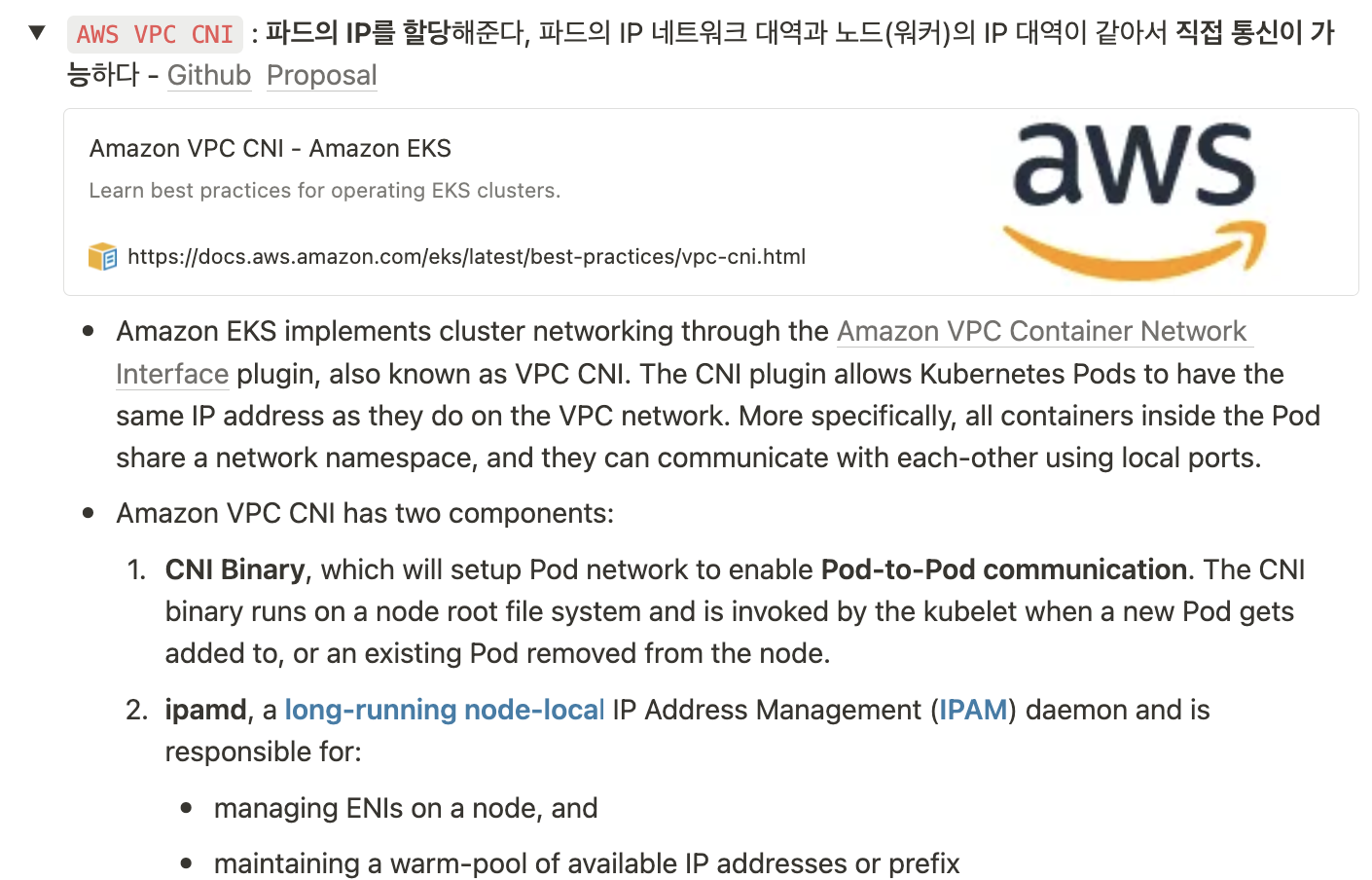

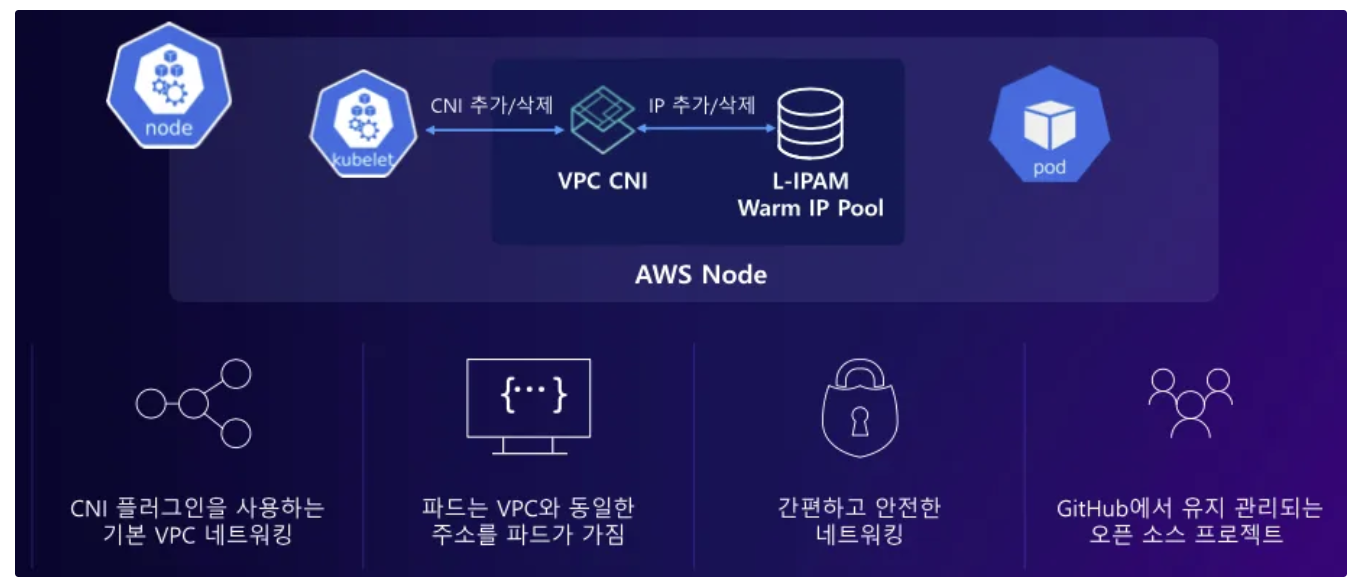

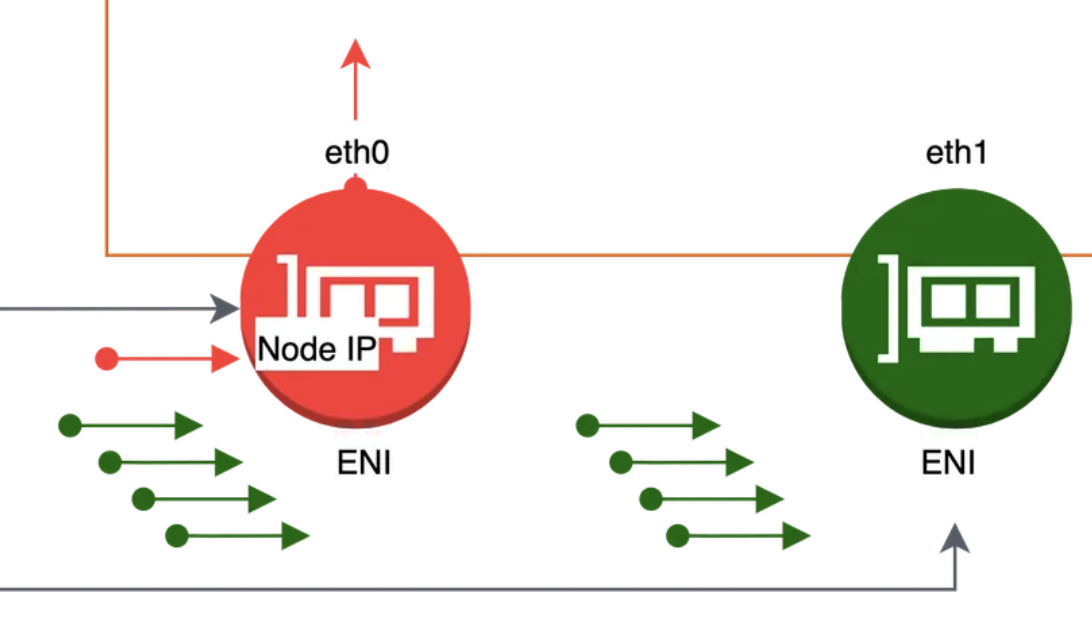

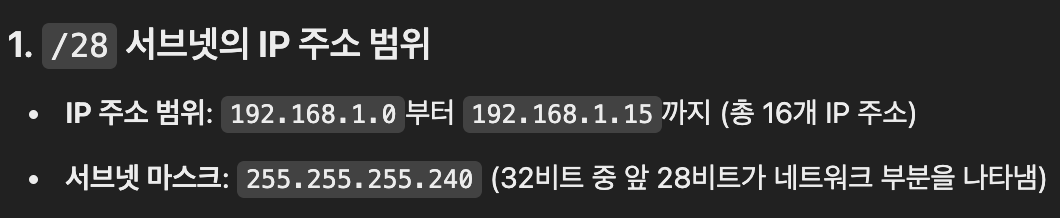

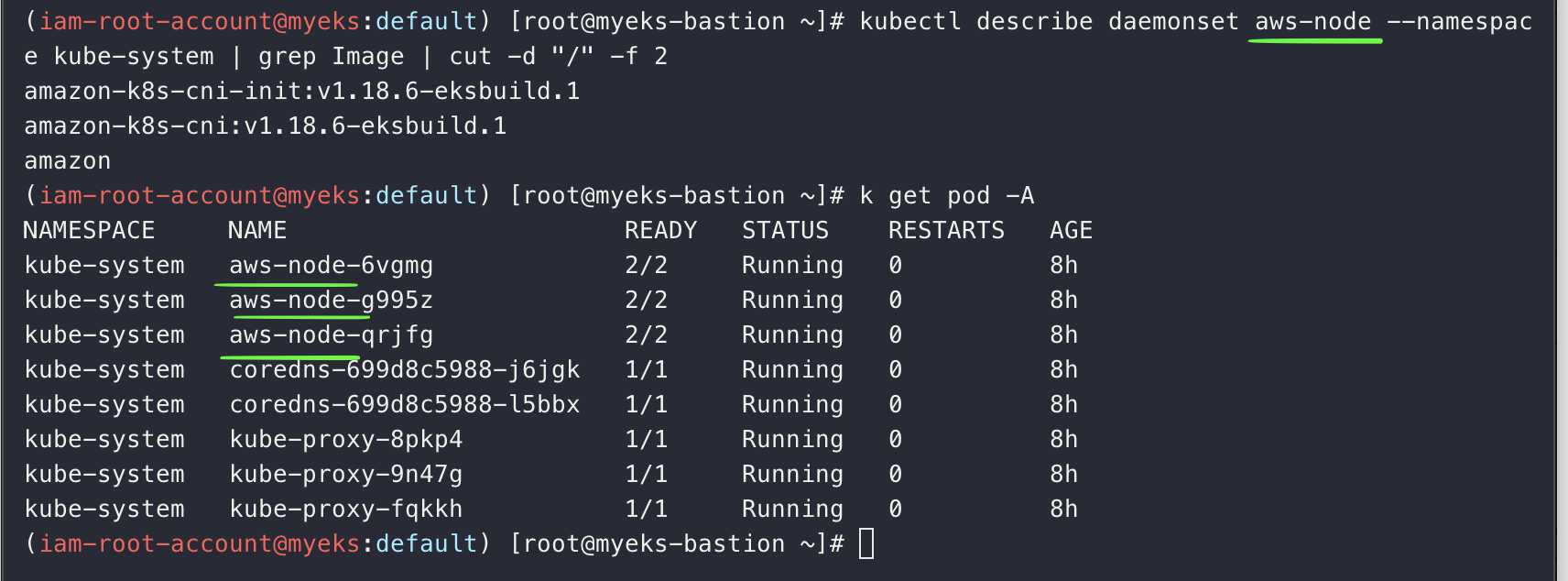

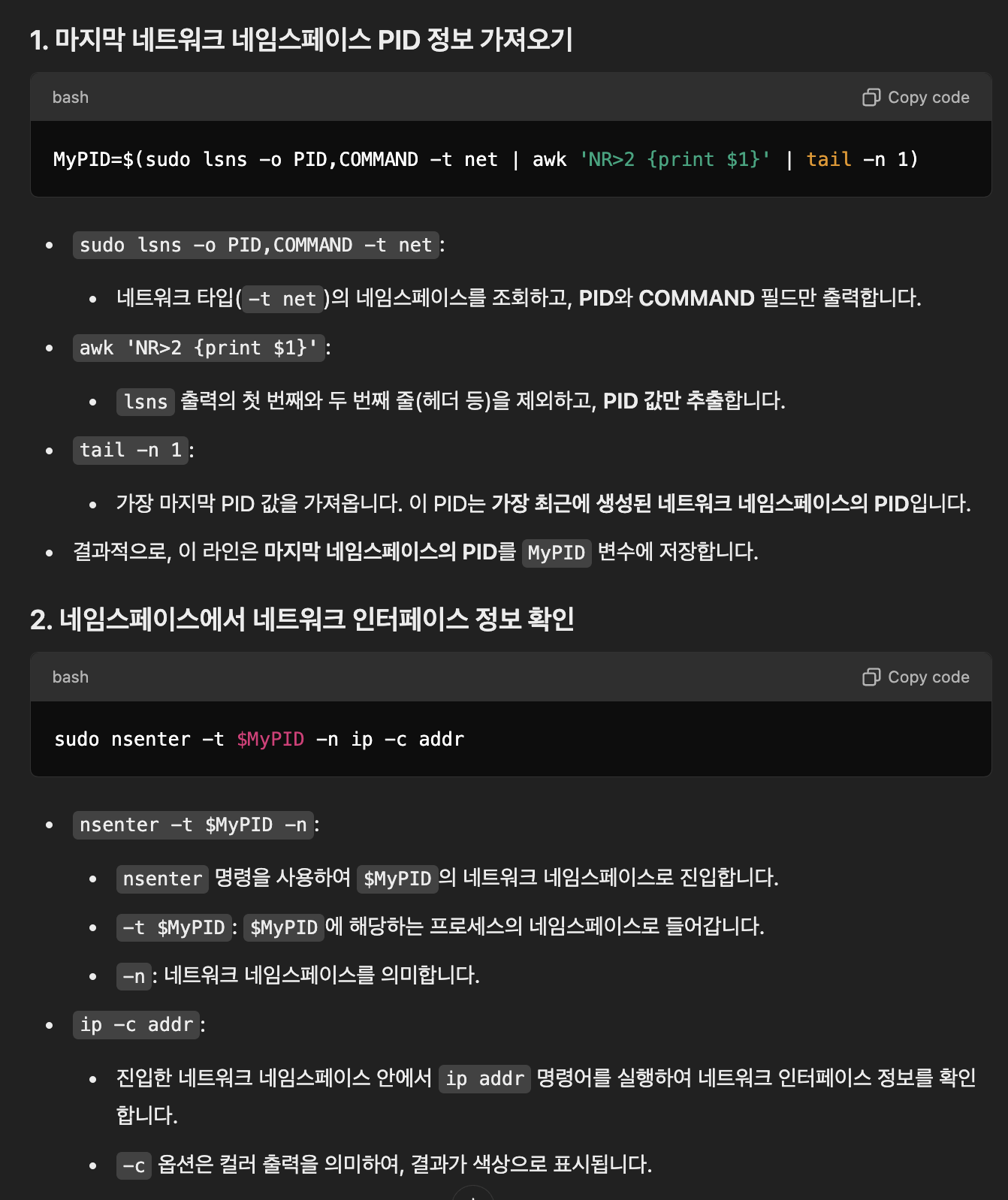

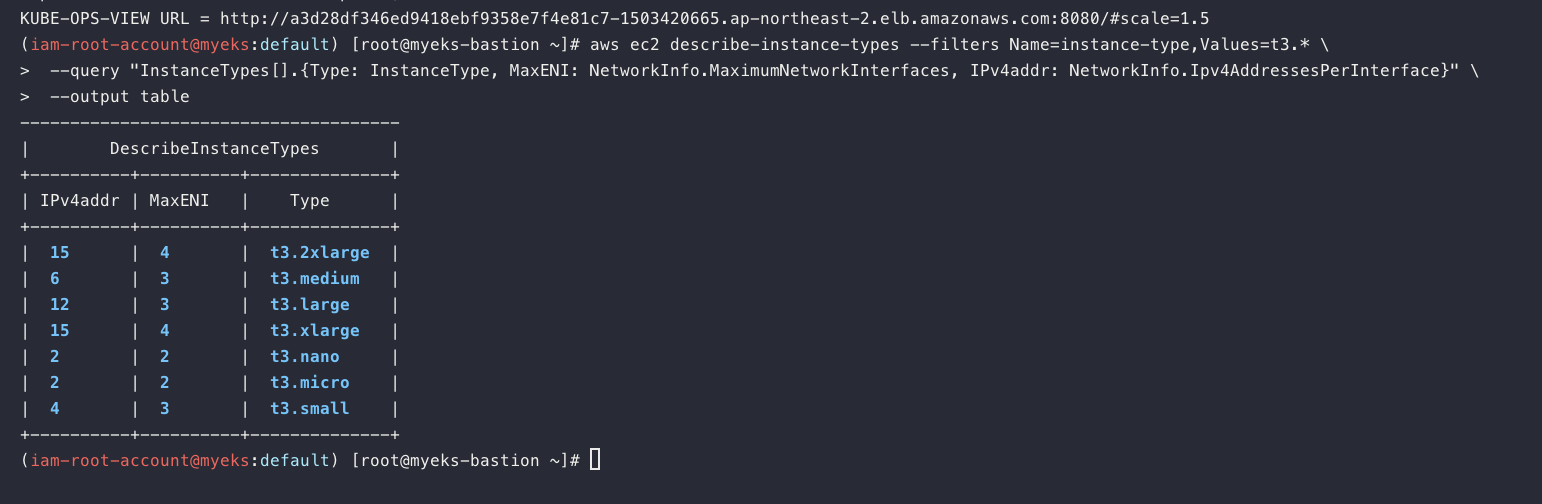

1. AWS VPC CNI

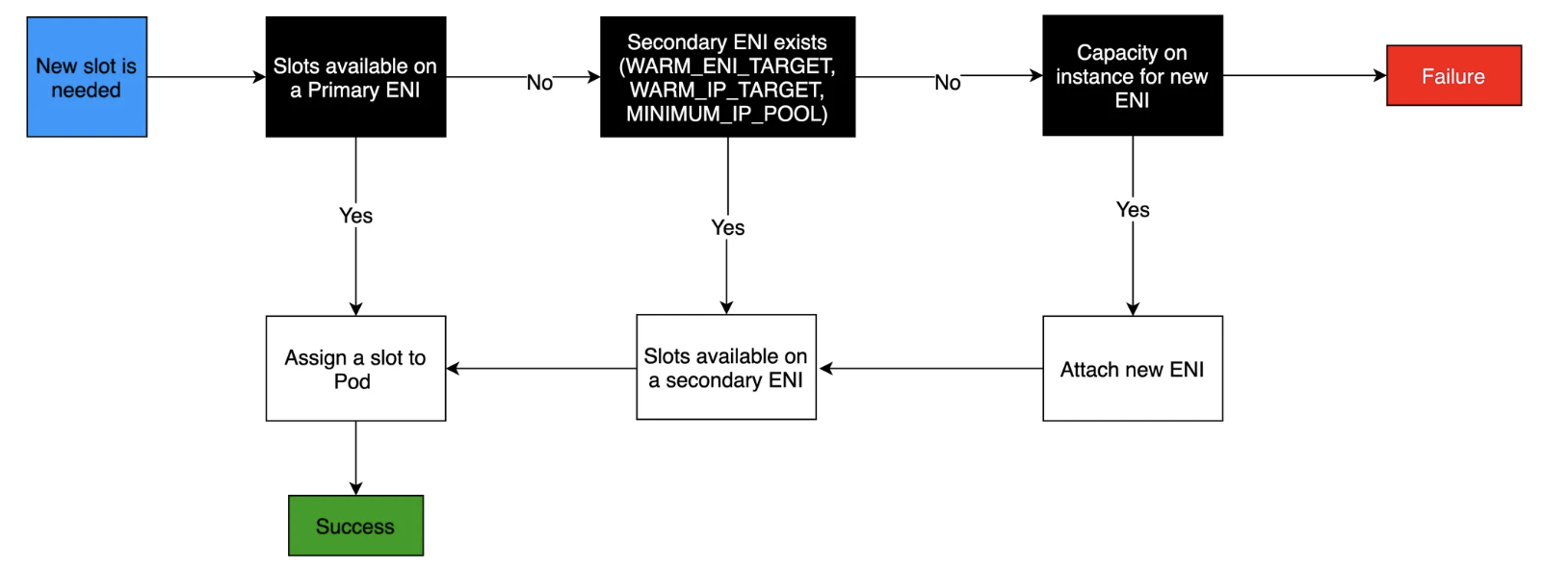

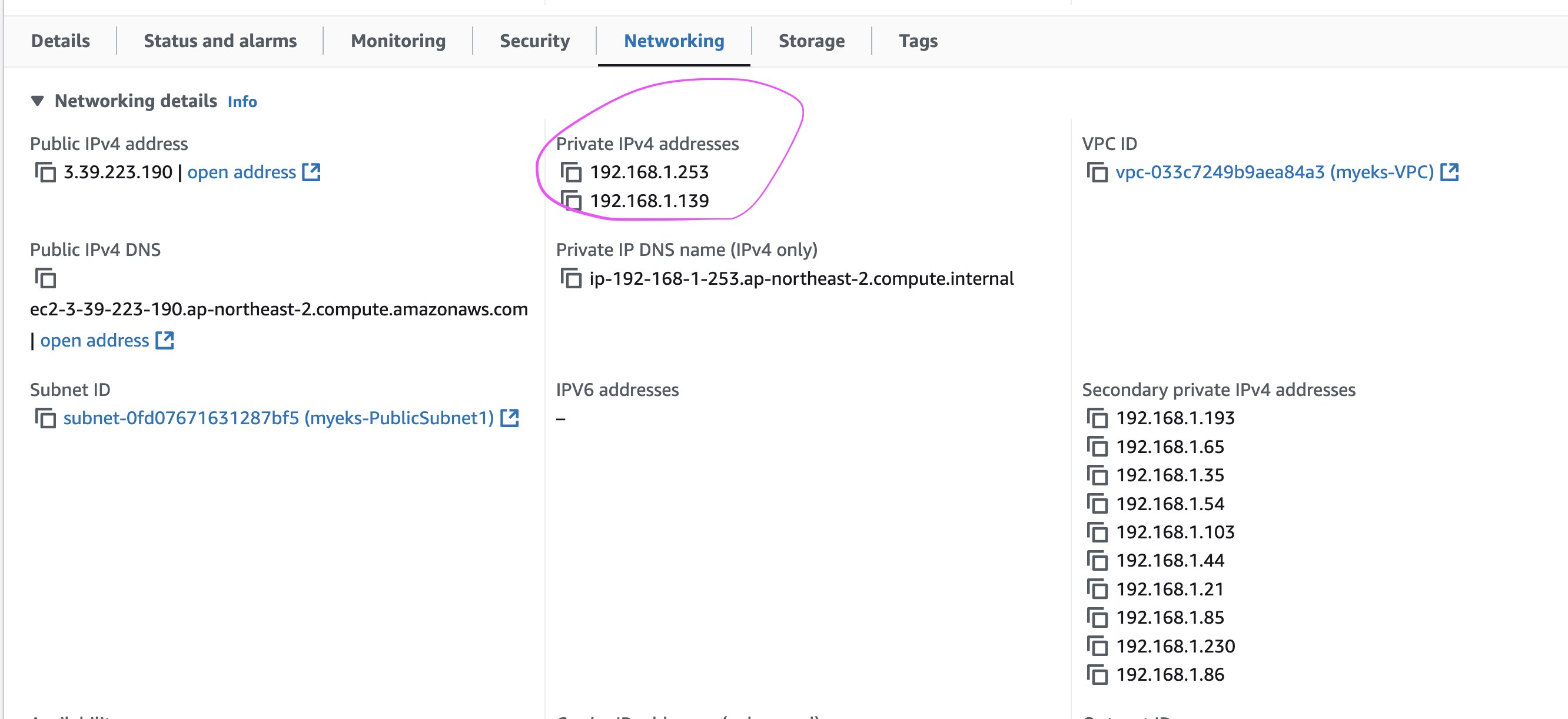

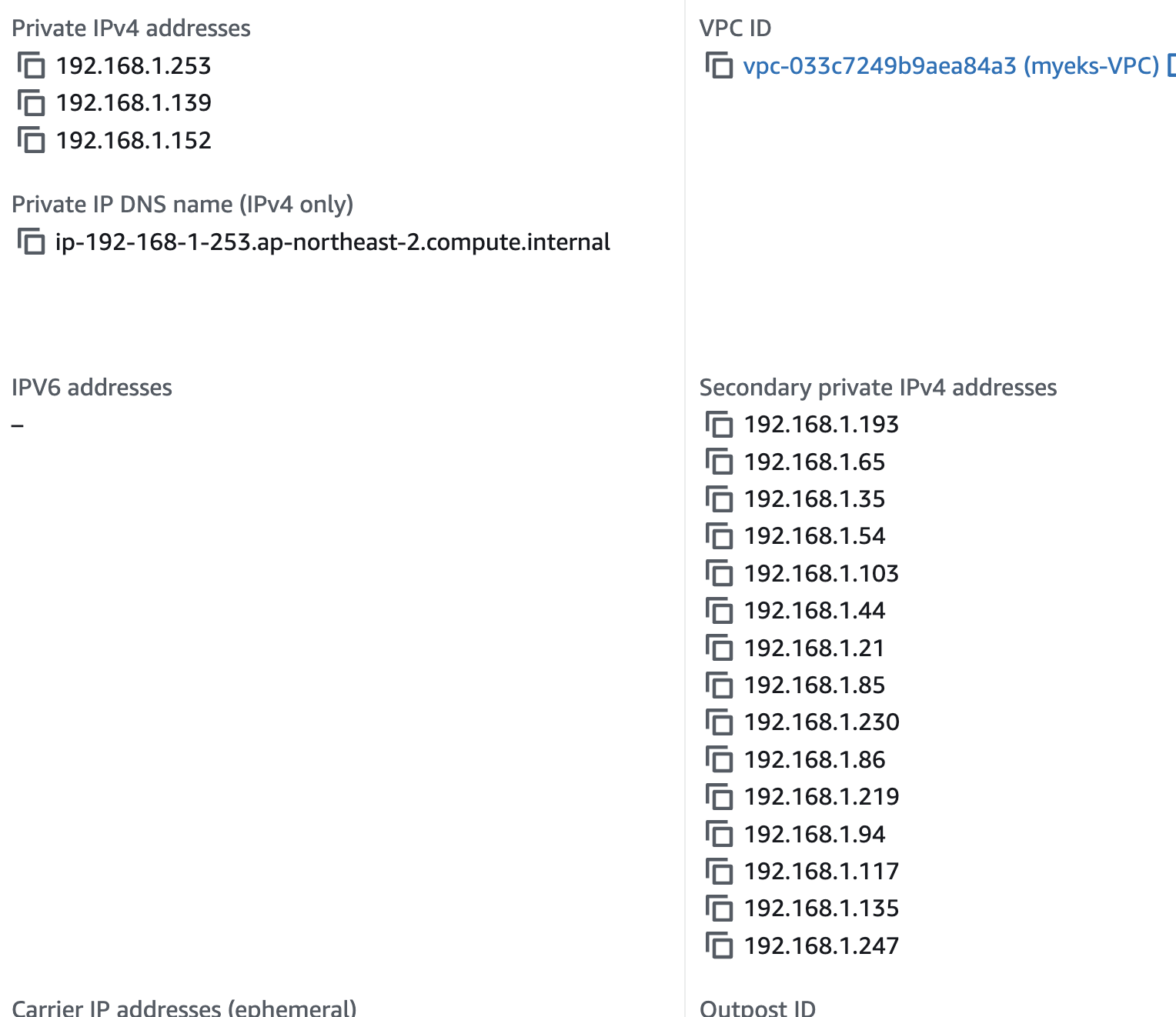

The CNI plugin manages Elastic Network Interfaces (ENI) on the node. When a node is provisioned, the CNI plugin automatically allocates a pool of slots (IPs or Prefix’s) from the node’s subnet to the primary ENI. This pool is known as the warm pool, and its size is determined by the node’s instance type.

일종의 캐싱 같이 pod 뜰때 빠르게 ip 할당하기 위해

The CNI also pre-allocates "warm" ENIs and slots for faster Pod startup.

위의 로직을 살펴보면 되듯이, ip 부족하면 여분의 생성했던거 사용하는 방식, 그것마저도 없으면 eth1로 또 만들어서 제공

중요한 특성

처음에 CIDR 계산 잘못하면 나중에 되돌리 수 없기 때문에 주의 해야함

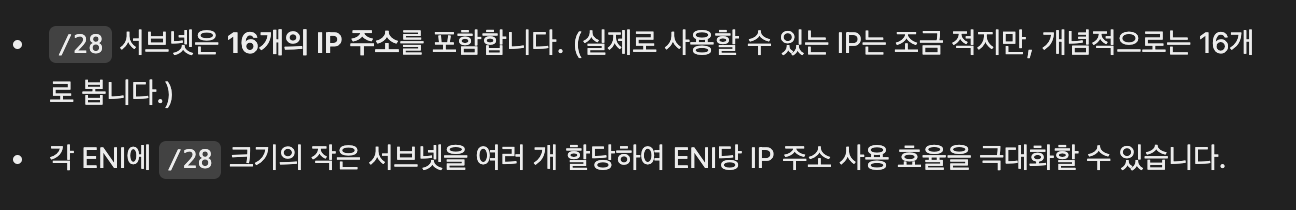

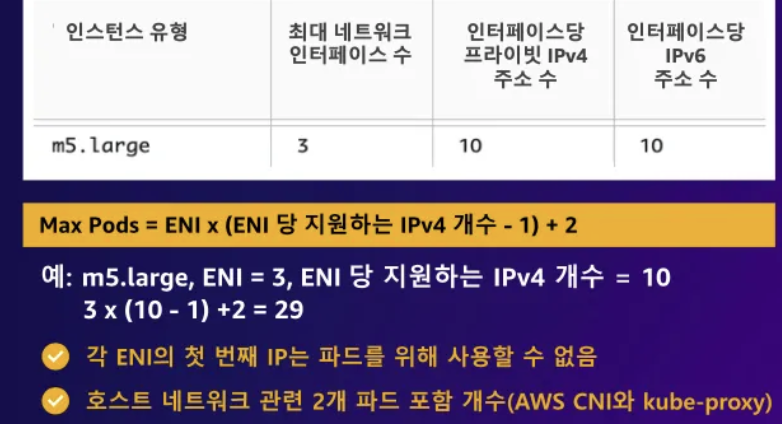

그래서 이공식에 따르면

3 * (5 -1) + 2 = 16

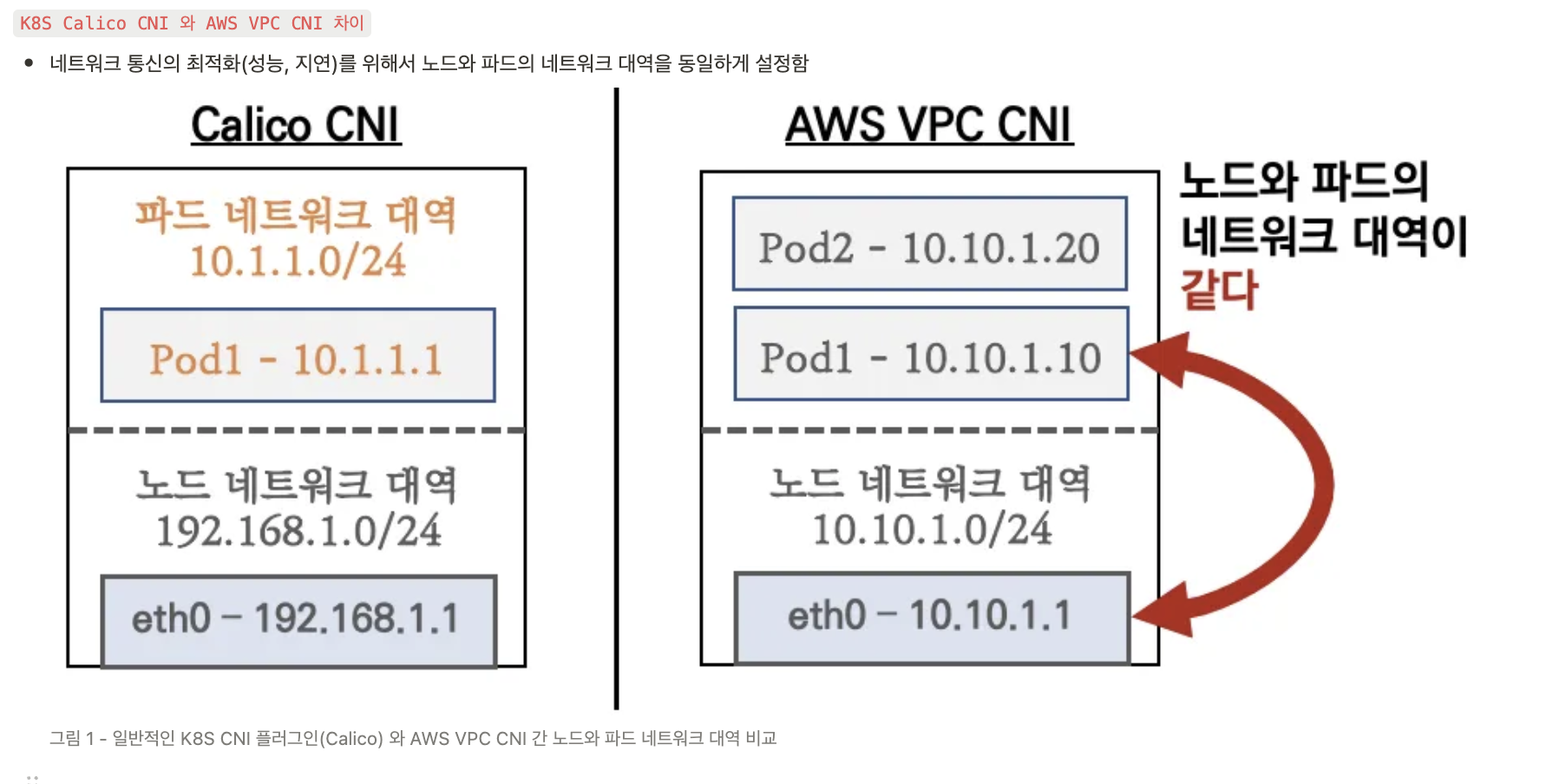

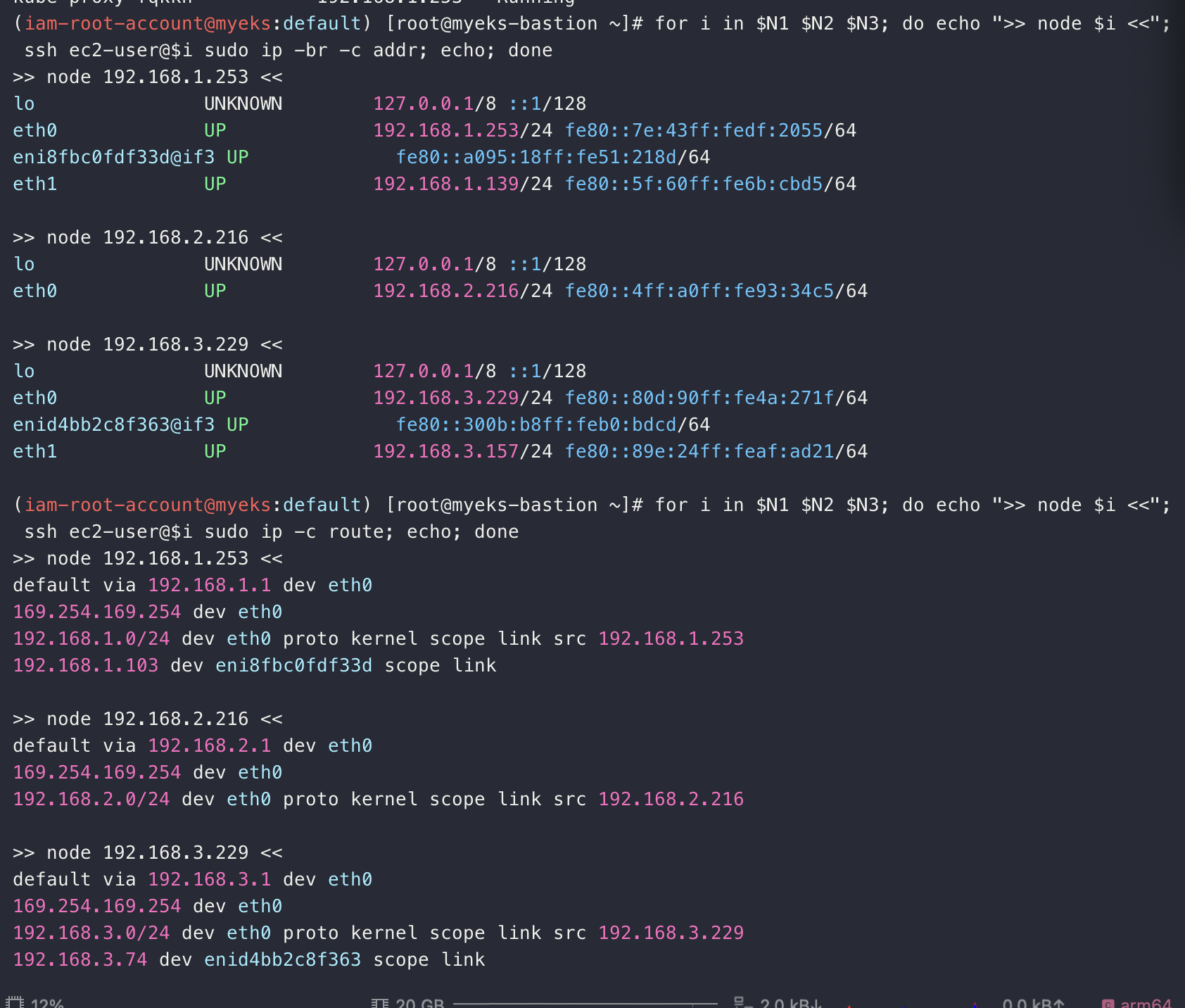

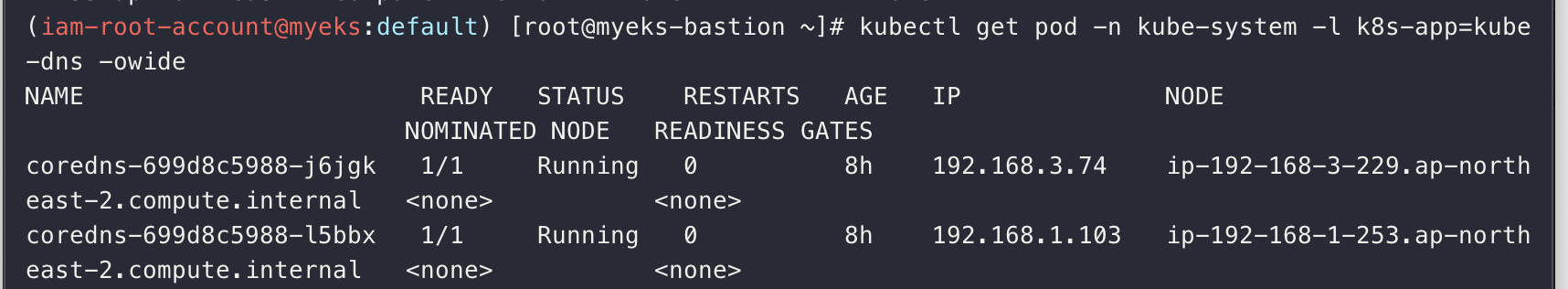

corde dns는 별도의 네트워크 네임스페이스를 사용, 대역은 같음 aws vpc cni가 가지는 특성

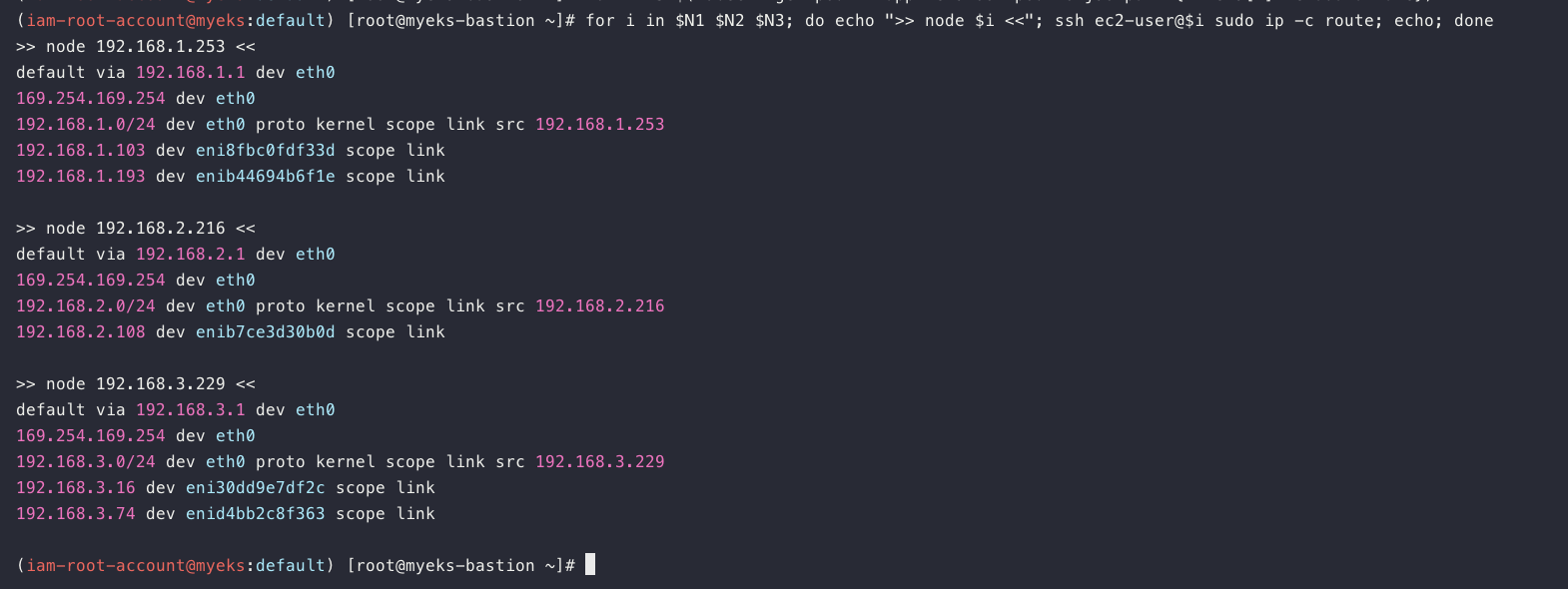

호스트 네트워크 네임스페이스를 공유하기 때문에 그대로 노드의 ip와 pod 의 ip가 같음 (IP:.status.podIP)

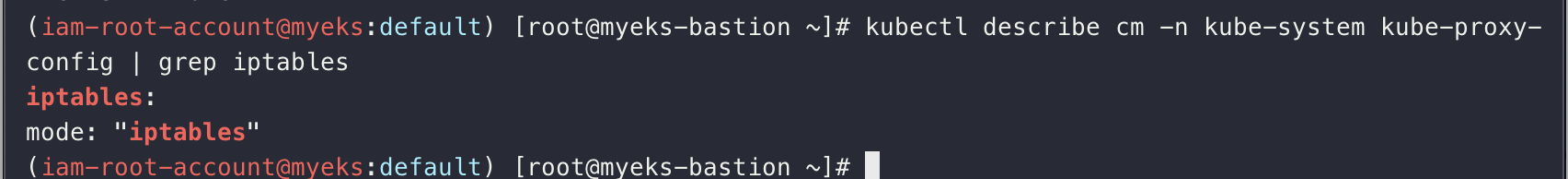

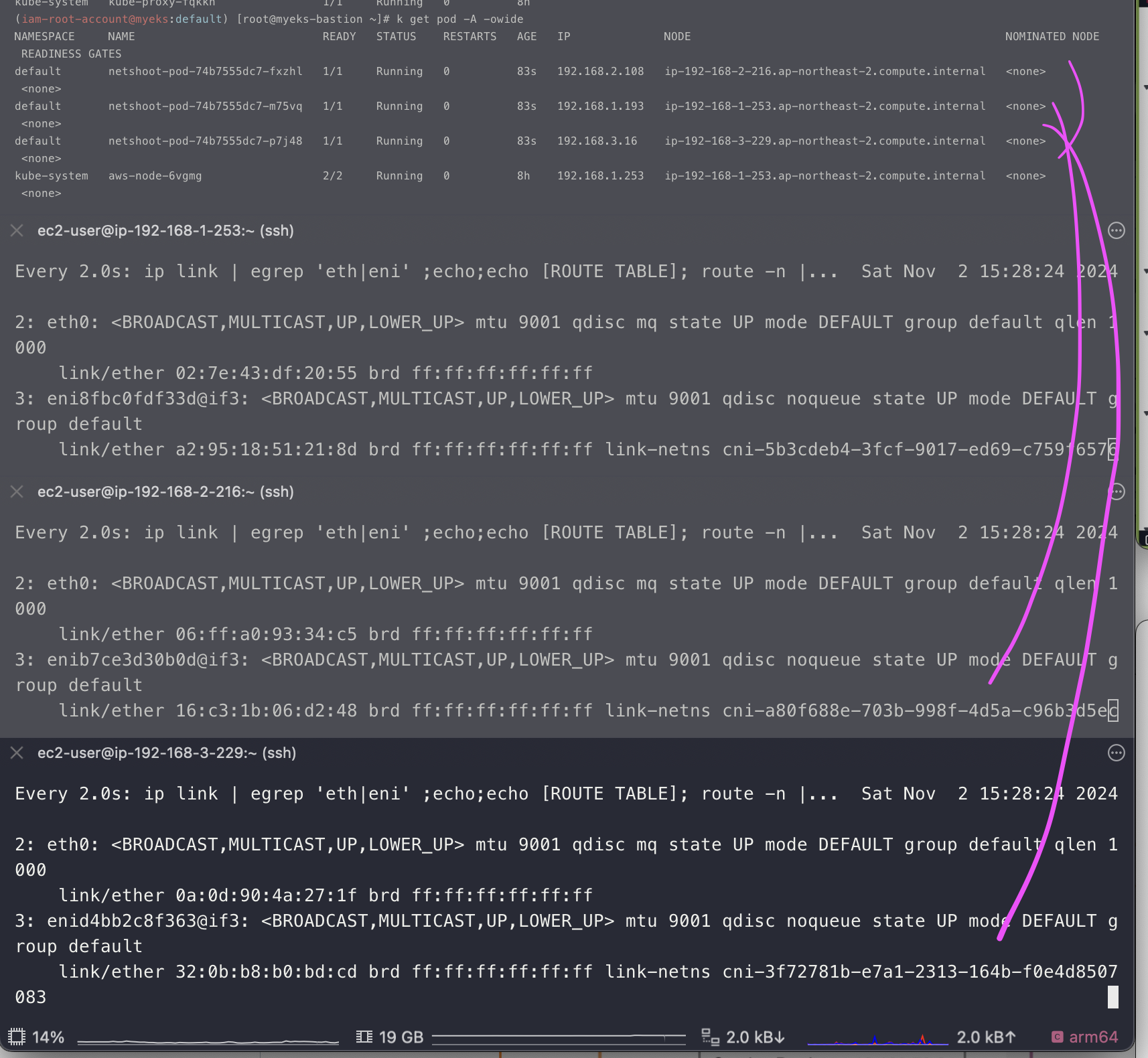

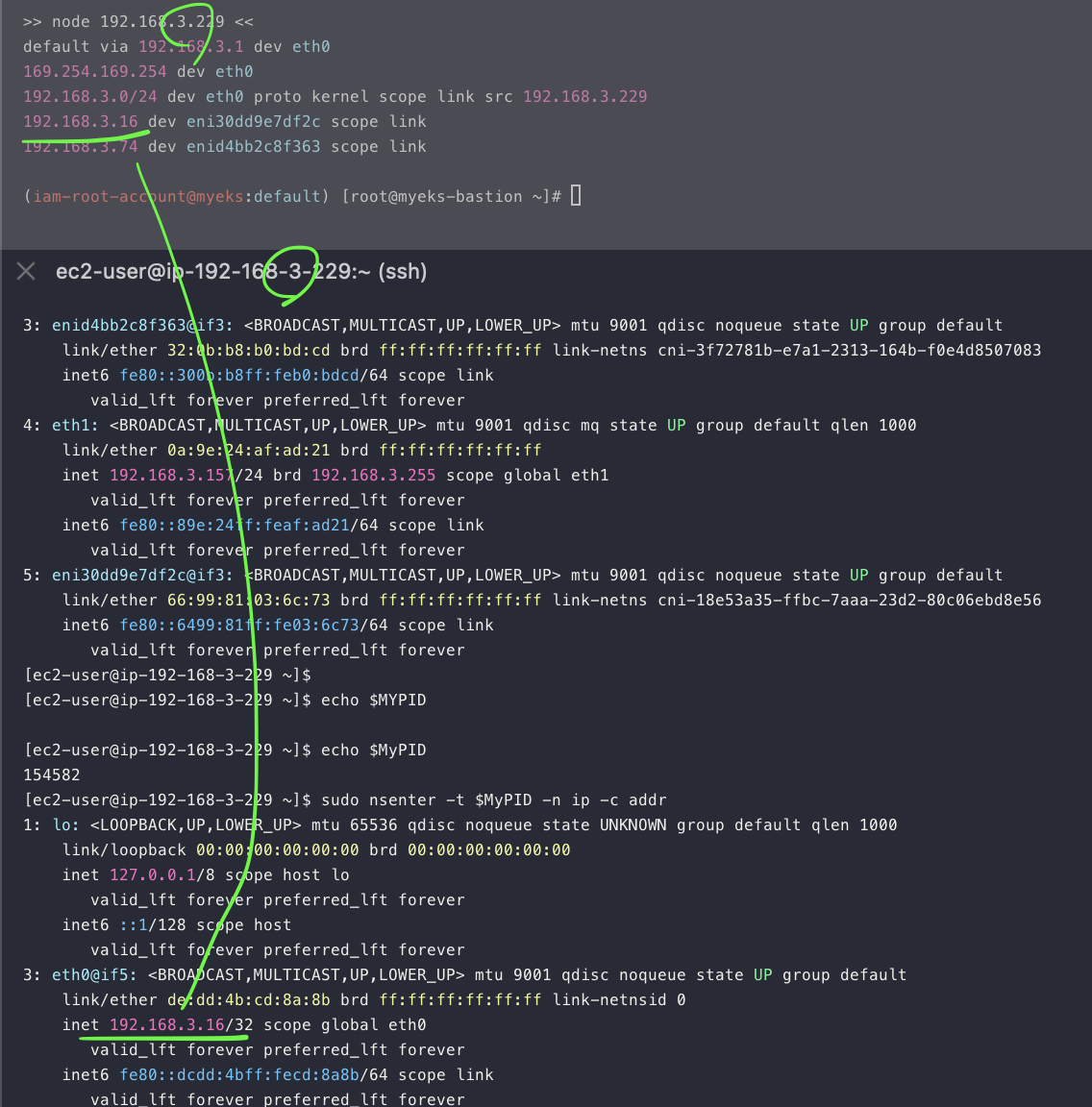

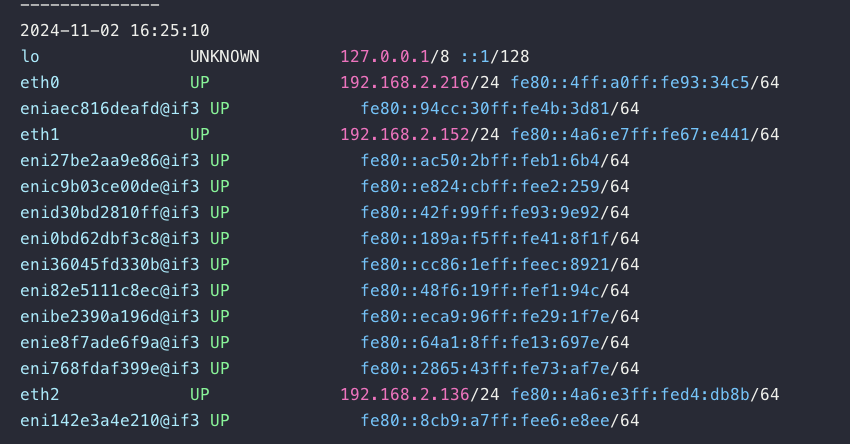

네트워크 정보 살펴봄

네트워크 네임스페이스가 2개

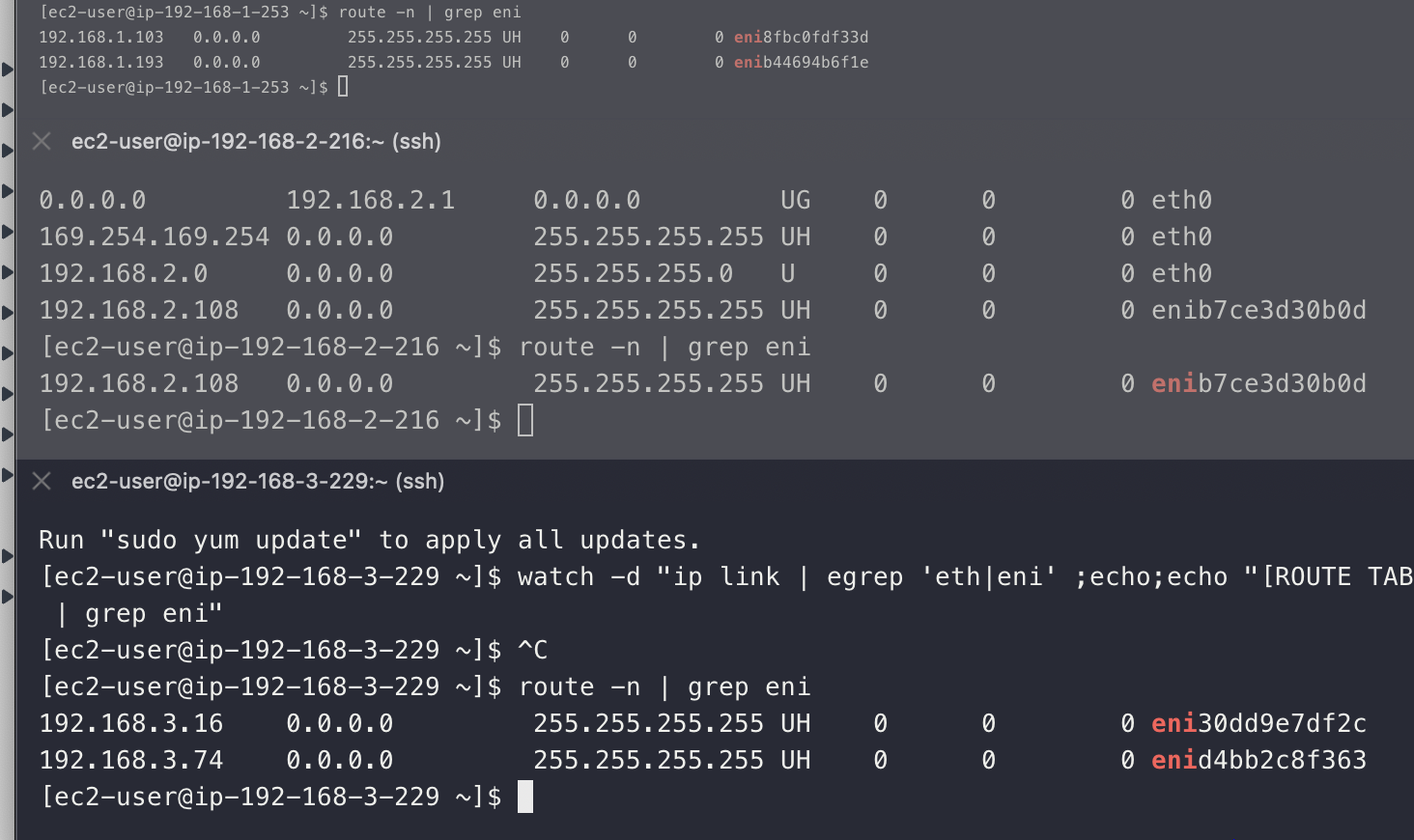

이유는 모르겠으나, 종호님 처럼 Route table 정보가 안나옴;; 하지만 route -n 으로 확인함

====================================================================================

cf) https://sigridjin.medium.com/eks-2%EC%A3%BC%EC%B0%A8-eks-networking-8153edcf62d1 해당글 참고(설명진짜 잘되어 있음) - 검색하다가 발견

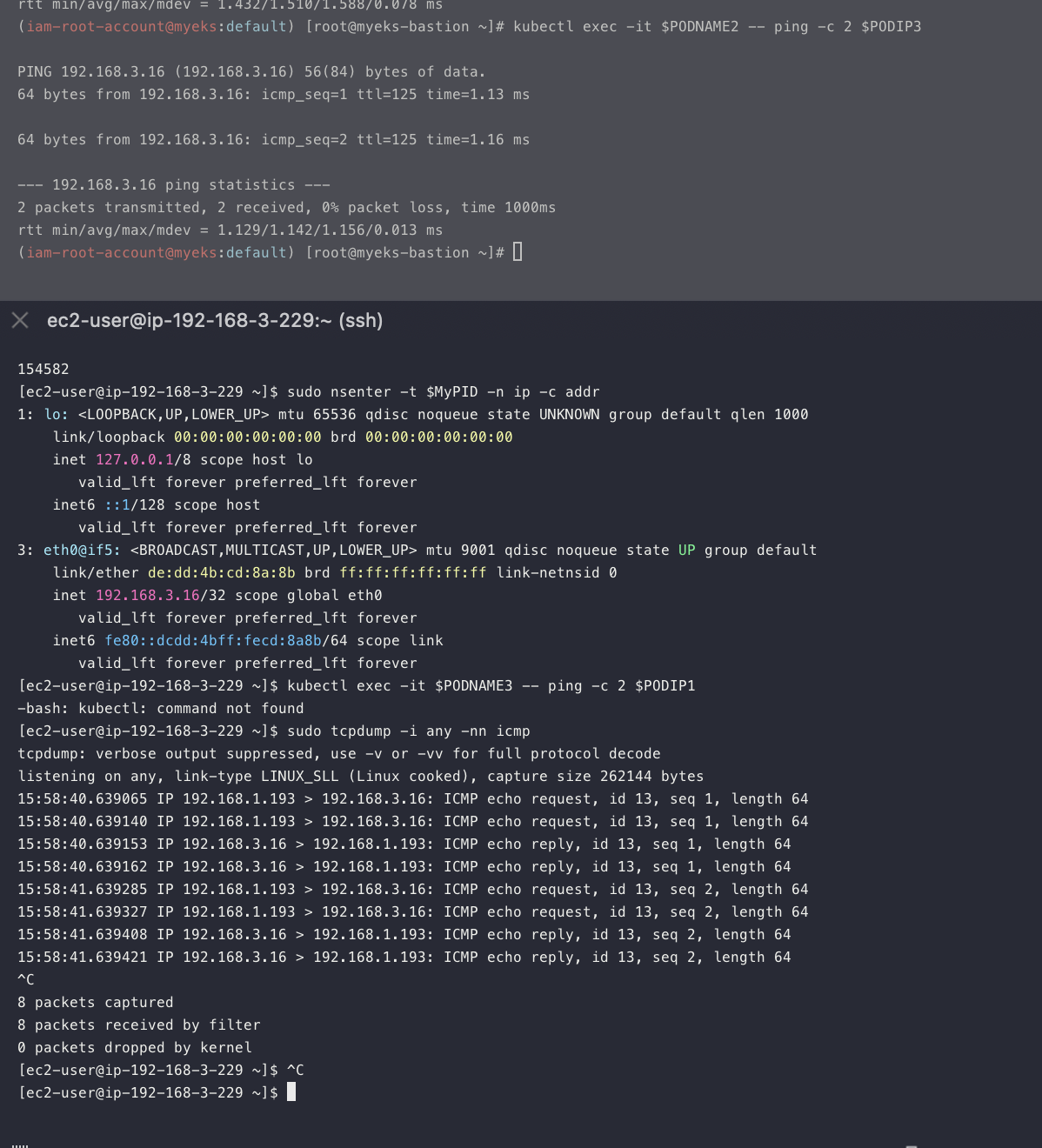

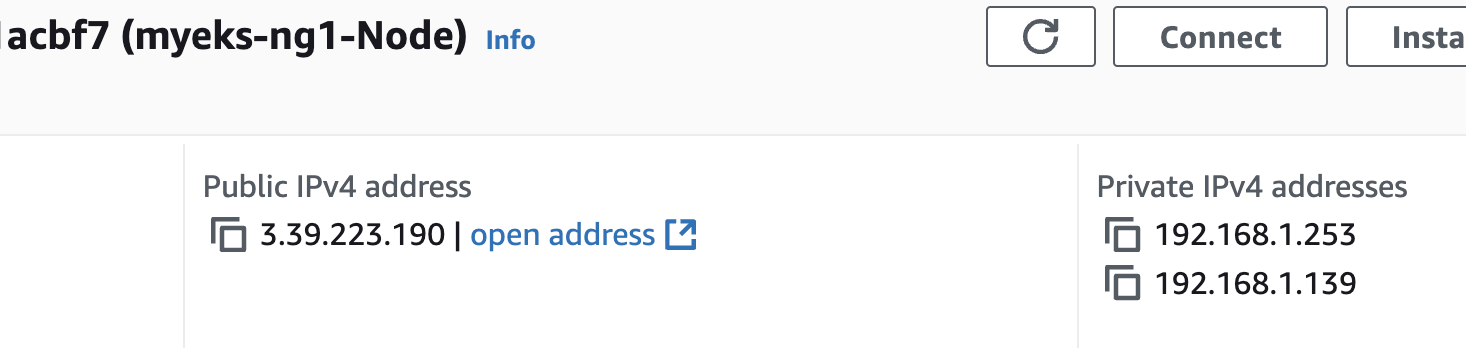

2. 노드 간 파드 통신

그대로 pod ip가 곧 서버의 물리적 ip와 동일해서 그대로 나감 이게 다른 네트워크 cni 와의 차이점

===============================================

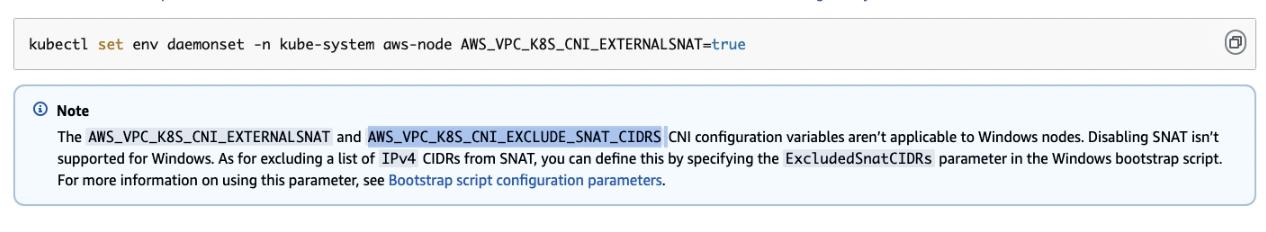

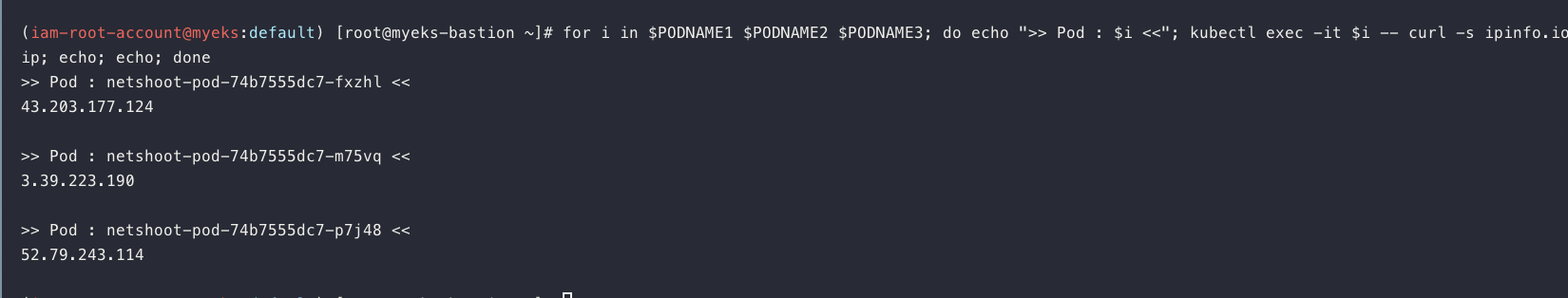

4. 파드에서 외부 통신

기본적으로 SNAT 해서 나가는데

이런설정을 통해서 바로 나가게도 할수는 있음

# 작업용 EC2 : pod-1 Shell 에서 외부 접속 확인 - 공인IP는 어떤 주소인지도 확인

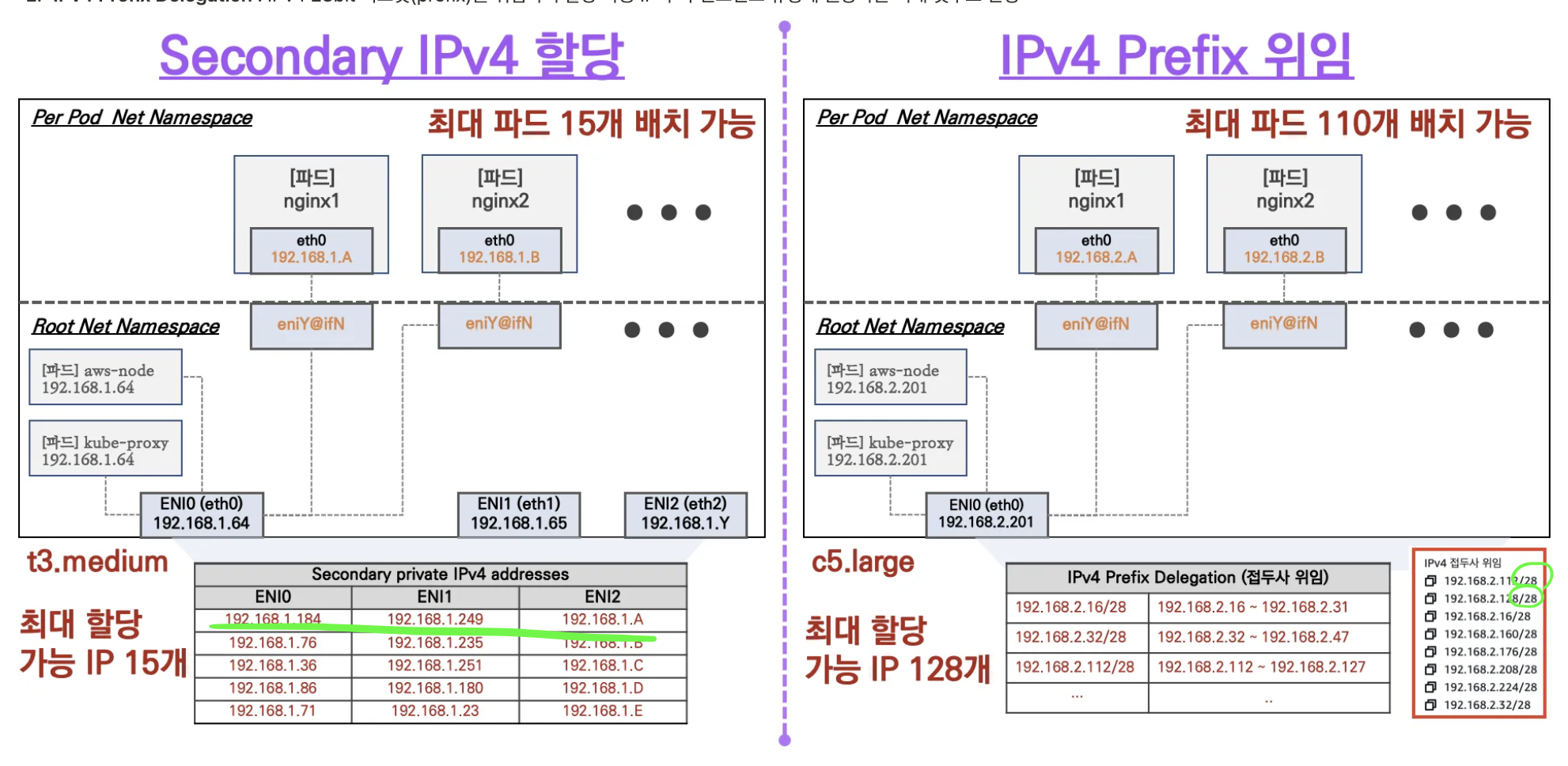

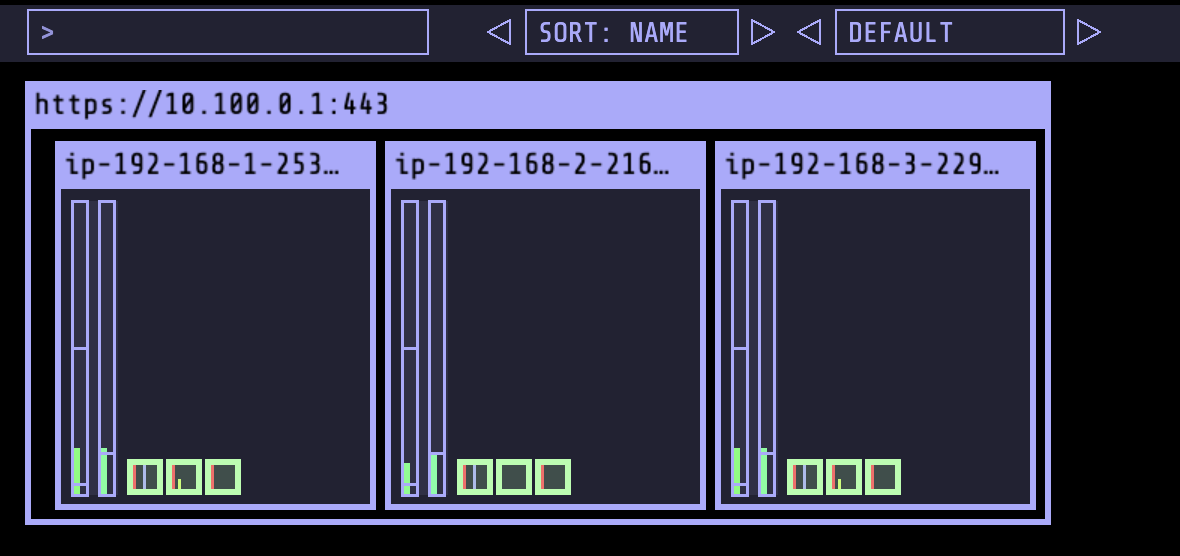

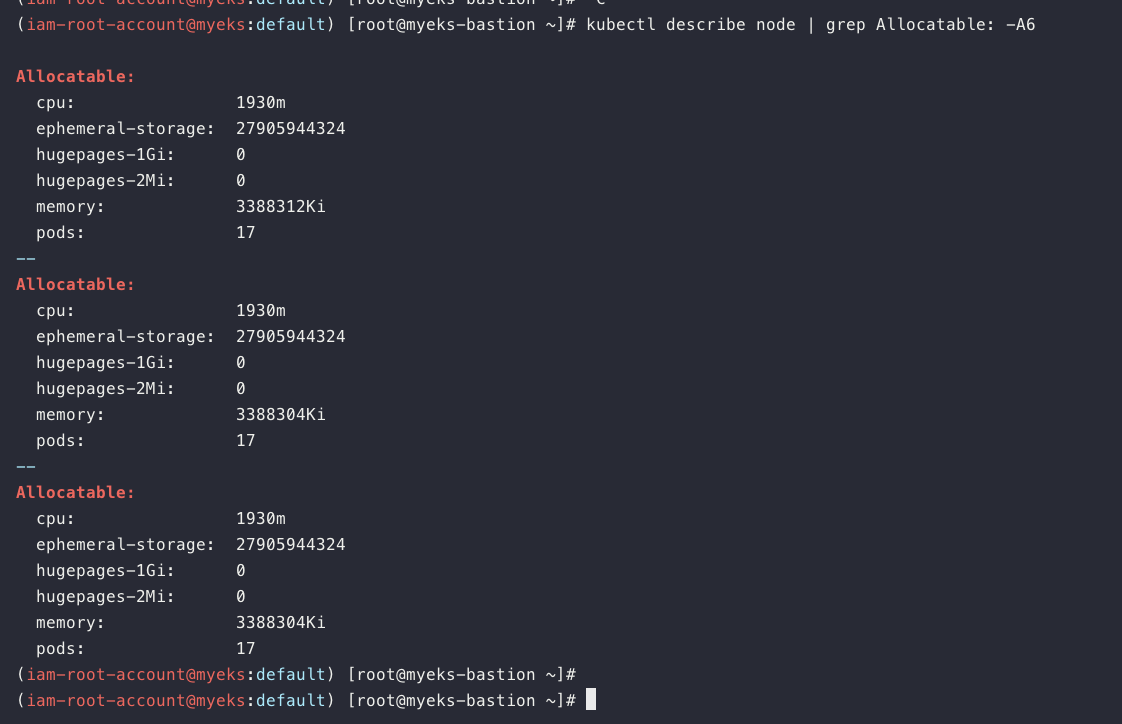

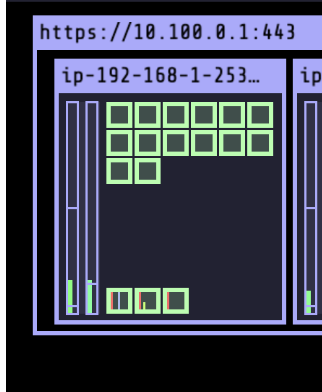

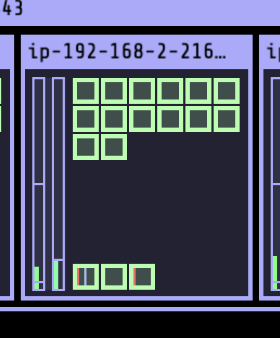

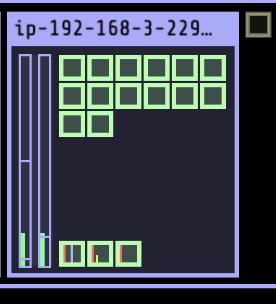

5. 노드에 파드 생성 갯수 제한

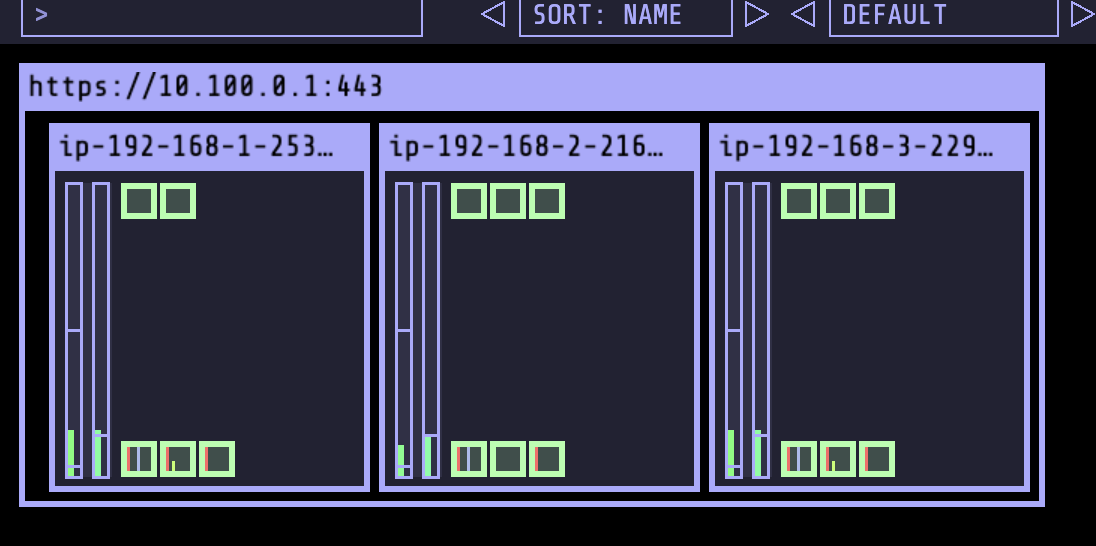

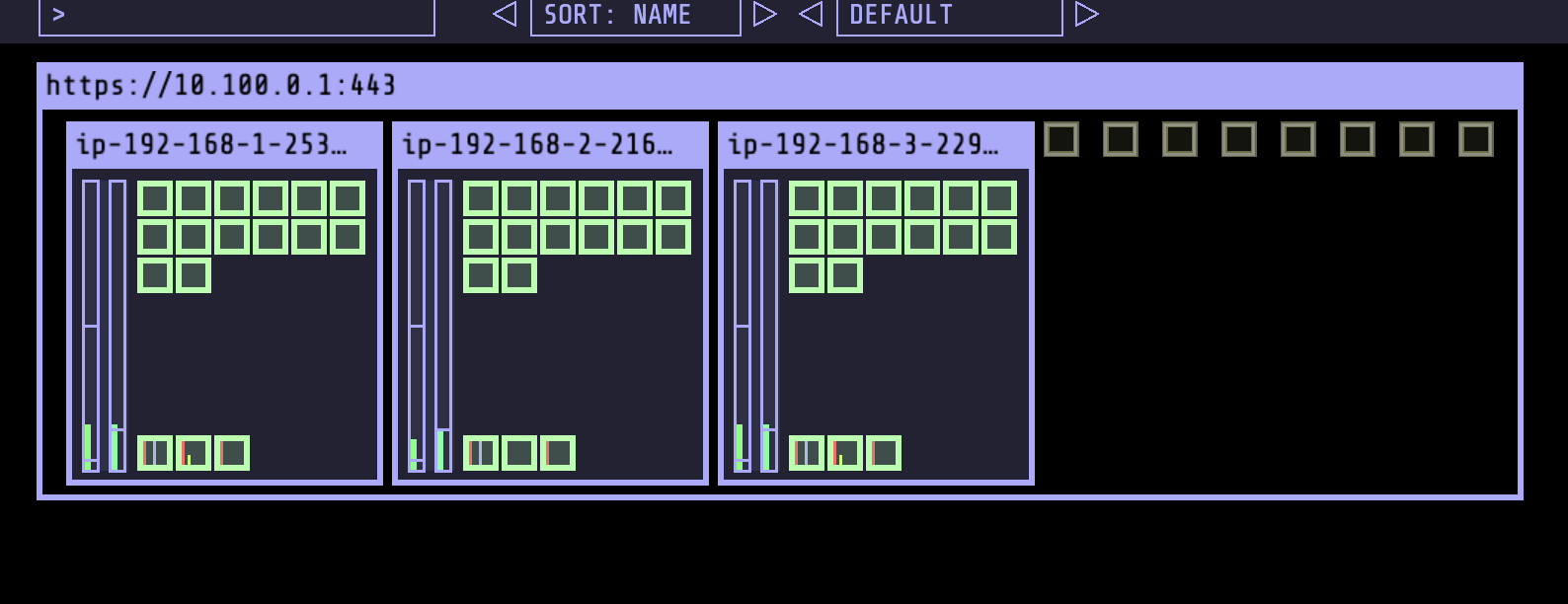

ops-view 설치

노드에 할당가능한 pod 수 확인

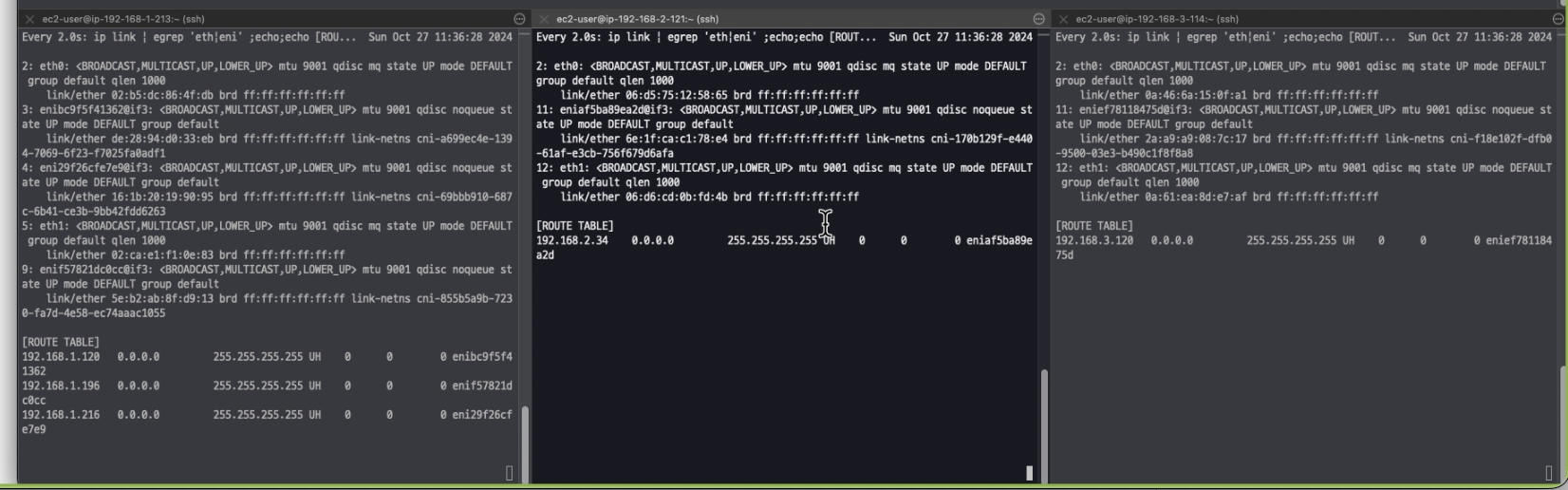

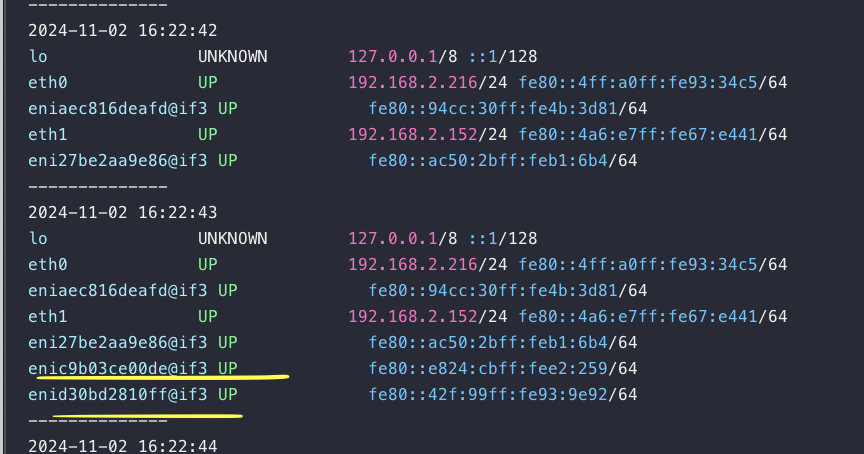

# 파드 증가 테스트 >> 파드 정상 생성 확인, 워커 노드에서 eth, eni 갯수 확인

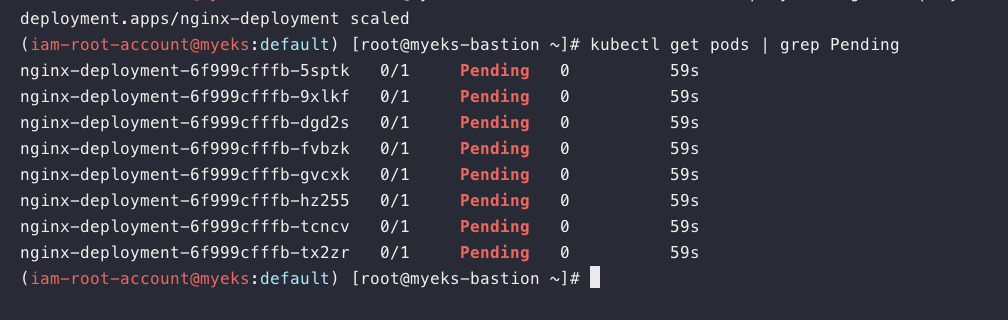

kubectl scale deployment nginx-deployment --replicas=8

노드 2번에서 네트워크 인터페이스 증가를 확인함

pod를 30개까지 늘려봄, 노드 2 의 변화 확인

50개까지 pod 늘리면 pending 된 애들 발견됨

그래서 pending Pod가 나옴

'Docker 및 k8s' 카테고리의 다른 글

| 네트워크 스터디 8주차-2 (2) | 2024.10.27 |

|---|---|

| 네트워크 스터디 7주차-1 (0) | 2024.10.18 |

| 네트워크 스터디 6주차 (0) | 2024.10.12 |

| 24년 10월 8일 AWS Operation Modernization Day(오프라인) - 역삼 센터필드 (0) | 2024.10.09 |

| 네트워크 스터디 5주차 (2) | 2024.10.06 |