| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Git

- Push

- Python #PEP

- pull

- nodeport

- Glossary #Python

- aws #modernization #eks #k8s

- pyenv

- 타입 #type

- Trino

- k8s

- merge

- Python3 #PEP

- crossfit_geeks #크로스핏 #crossfit #당산크로스핏 #크로스핏긱스 #running #역도 #오운완 #크로스핏터 #Django가 고장날때까지

- til #loguru #str #format

- 티스토리챌린지

- fetch

- 카프카

- 오블완

- trino #hive #sync

- 쿠버네티스

- Exception

- Today

- Total

Django가 고장날때까지

네트워크 스터디 8주차-2 본문

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: netpod

labels:

app: netpod

spec:

nodeName: k8s-s

containers:

- name: netshoot-pod

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

---

apiVersion: v1

kind: Pod

metadata:

name: webpod1

labels:

app: webpod

spec:

nodeName: k8s-w1

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

---

apiVersion: v1

kind: Pod

metadata:

name: webpod2

labels:

app: webpod

spec:

nodeName: k8s-w2

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

EOF

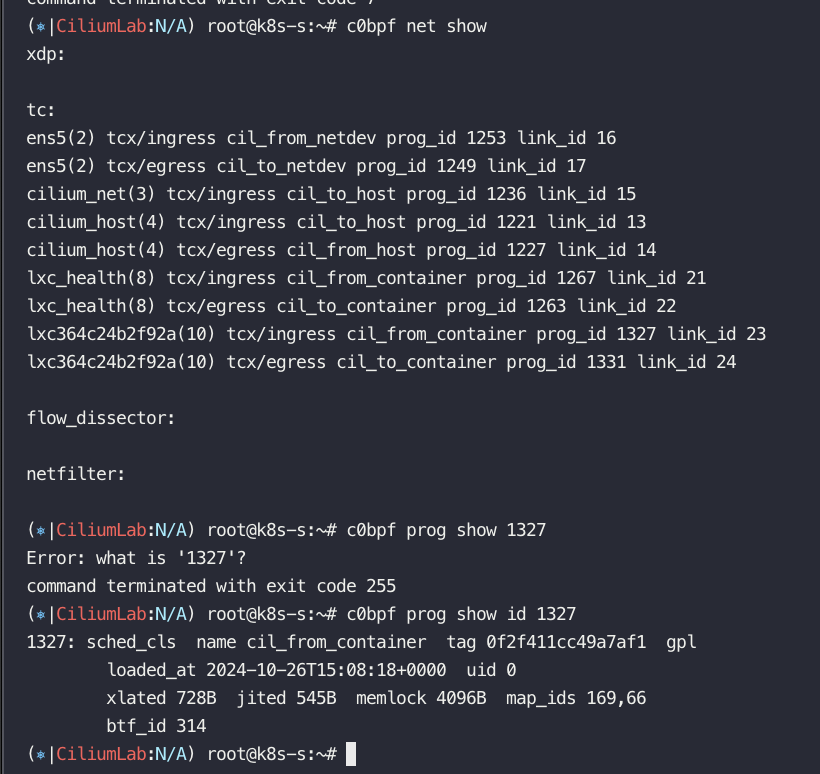

# 파드와 veth pair 에 IP가 없다! proxy_arp 도 없다! 하지만 GW MAC 요청 시 lxc(veth)의 MAC 으로 응답이 온다! >> eBPF Magic!

# Cilium hijacks ARP table of POD1, forces the next hop to be the peer end (host side) of the veth pair.

ip -c addr show dev $LXC

# 테스트 파드들 IP

NETPODIP=$(kubectl get pods netpod -o jsonpath='{.status.podIP}')

WEBPOD1IP=$(kubectl get pods webpod1 -o jsonpath='{.status.podIP}')

WEBPOD2IP=$(kubectl get pods webpod2 -o jsonpath='{.status.podIP}')

# 단축키(alias) 지정

alias p0="kubectl exec -it netpod -- "

alias p1="kubectl exec -it webpod1 -- "

alias p2="kubectl exec -it webpod2 -- "

# netpod 네트워크 정보 확인

p0 ip -c -4 addr

p0 route -n

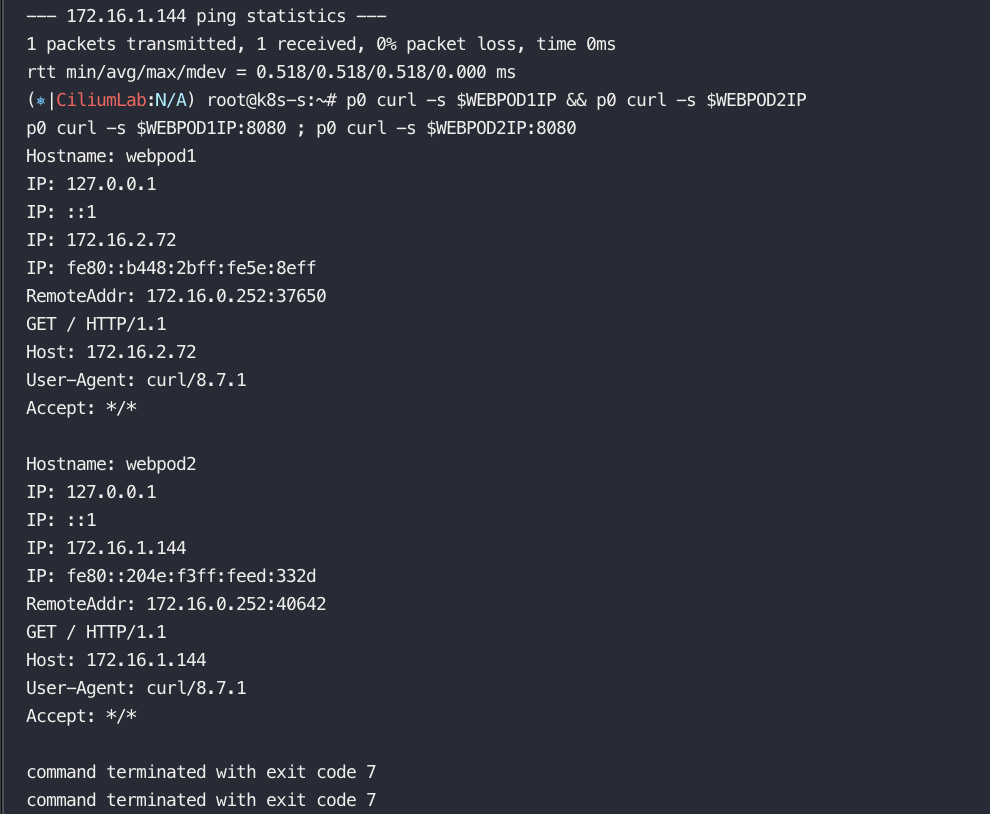

p0 ping -c 1 $WEBPOD1IP && p0 ping -c 1 $WEBPOD2IP

p0 curl -s $WEBPOD1IP && p0 curl -s $WEBPOD2IP

p0 curl -s $WEBPOD1IP:8080 ; p0 curl -s $WEBPOD2IP:8080

p0 ping -c 1 8.8.8.8 && p0 curl -s wttr.in/seoul

p0 ip -c neigh

=================================================================================

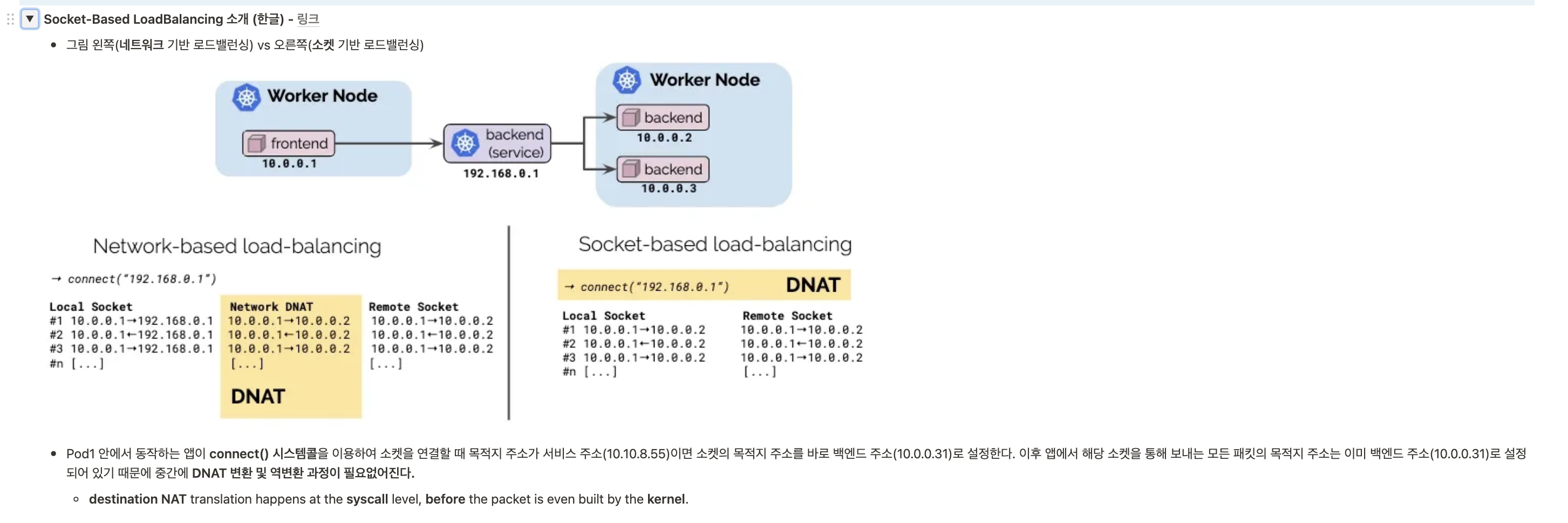

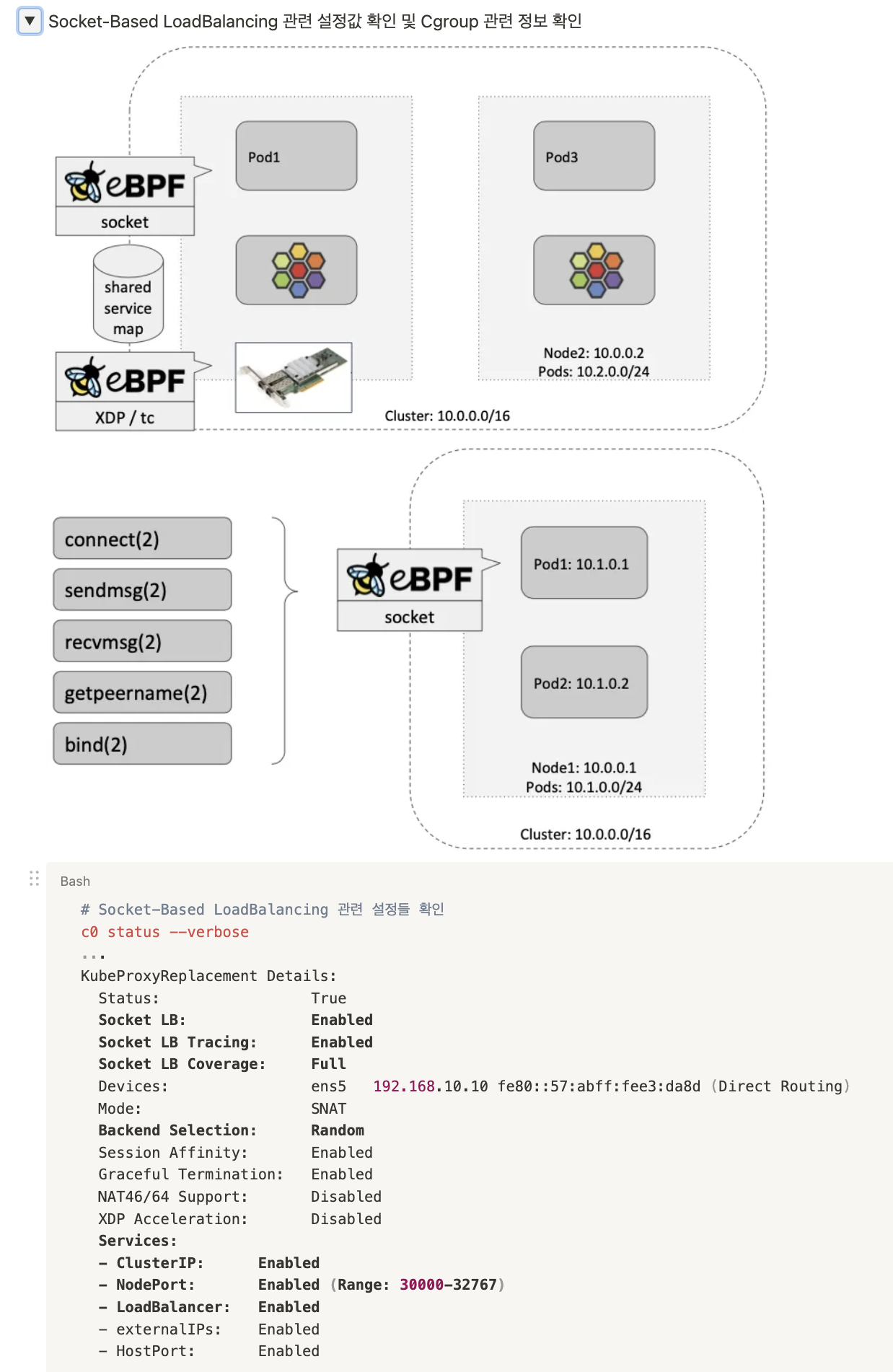

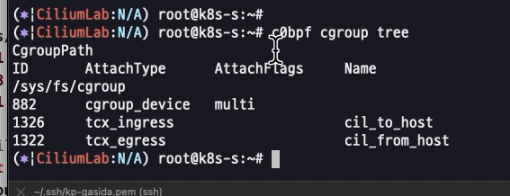

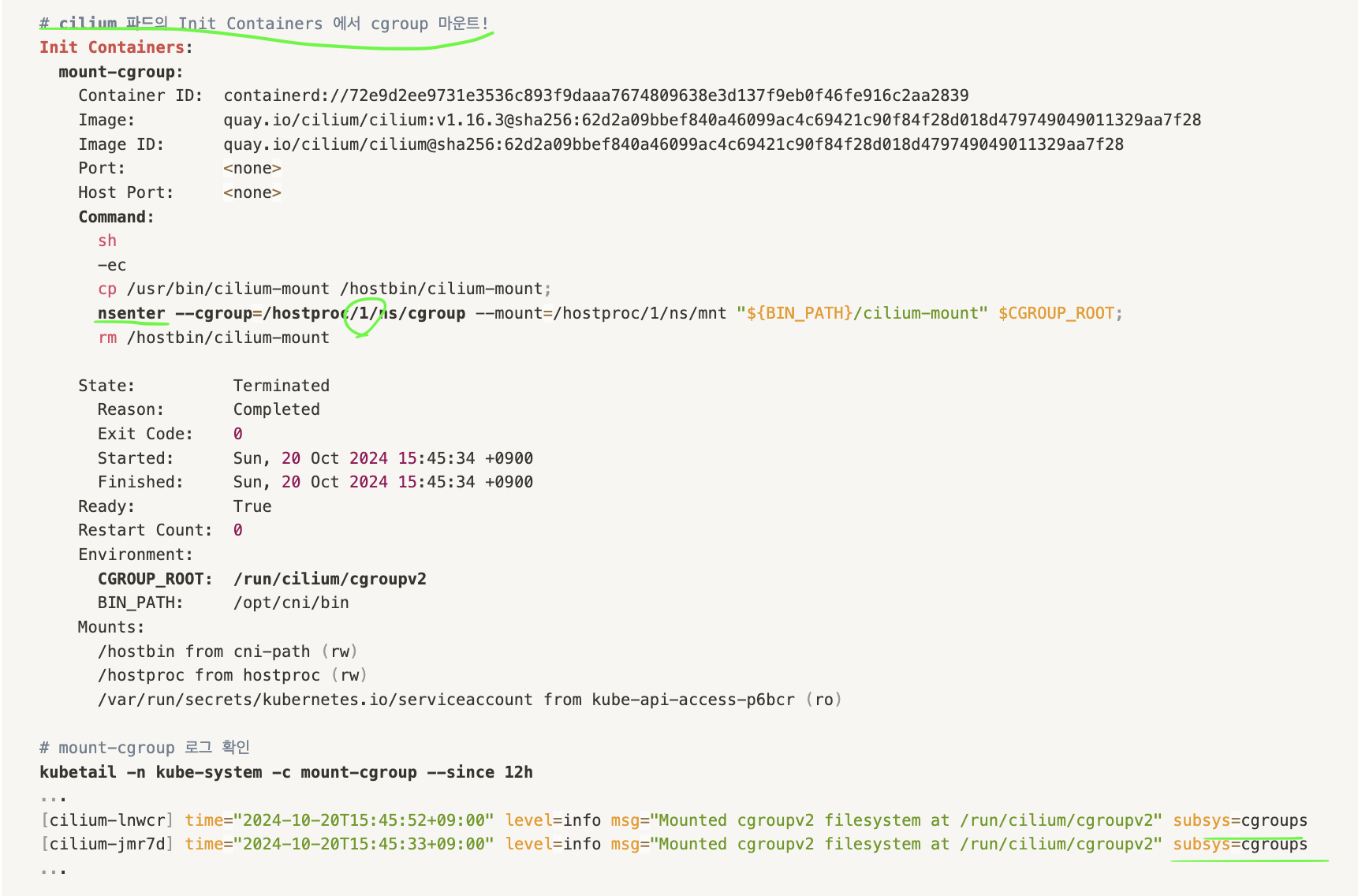

소켓 레벨 !!!!

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Service

metadata:

name: svc

spec:

ports:

- name: svc-webport

port: 80

targetPort: 80

selector:

app: webpod

type: ClusterIP

EOF

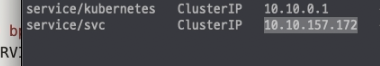

# 서비스 생성 확인

kubectl get svc,ep svc

# 노드에 iptables 더이상 KUBE-SVC rule 이 생성되지 않는다!

iptables-save | grep KUBE-SVC

iptables-save | grep CILIUM

# 서비스IP를 변수에 지정

SVCIP=$(kubectl get svc svc -o jsonpath='{.spec.clusterIP}')

# Pod1 에서 Service(ClusterIP) 접속 트래픽 발생

kubectl exec netpod -- curl -s $SVCIP

kubectl exec netpod -- curl -s $SVCIP | grep Hostname

# 지속적으로 접속 트래픽 발생

SVCIP=$(kubectl get svc svc -o jsonpath='{.spec.clusterIP}')

while true; do kubectl exec netpod -- curl -s $SVCIP | grep Hostname;echo "-----";sleep 1;done

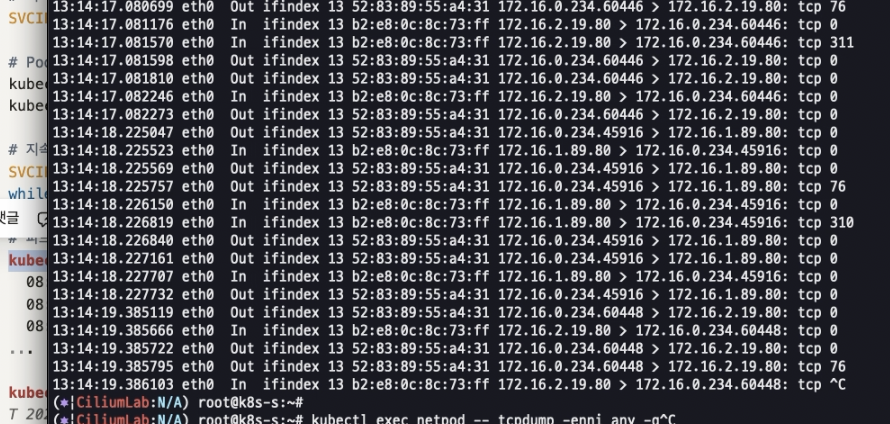

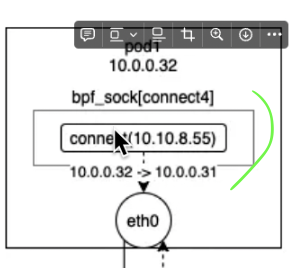

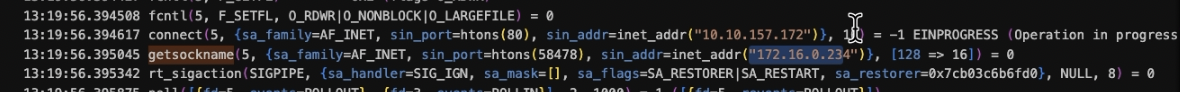

# 파드에서 SVC(ClusterIP) 접속 시 tcpdump 로 확인 >> 파드 내부 캡쳐인데, SVC(10.108.12.195)는 보이지 않고, DNAT 된 web-pod 의 IP가 확인! Magic!

kubectl exec netpod -- tcpdump -enni any -q

08:54:55.454271 eth0 Out ifindex 14 92:1a:b9:94:94:37 172.16.0.162.44718 > 172.16.1.234.80: tcp 0

08:54:55.454798 eth0 In ifindex 14 8a:0c:cc:a9:21:1a 172.16.1.234.80 > 172.16.0.162.44718: tcp 0

08:54:55.455030 eth0 Out ifindex 14 92:1a:b9:94:94:37 172.16.0.162.44718 > 172.16.1.234.80: tcp 77

...

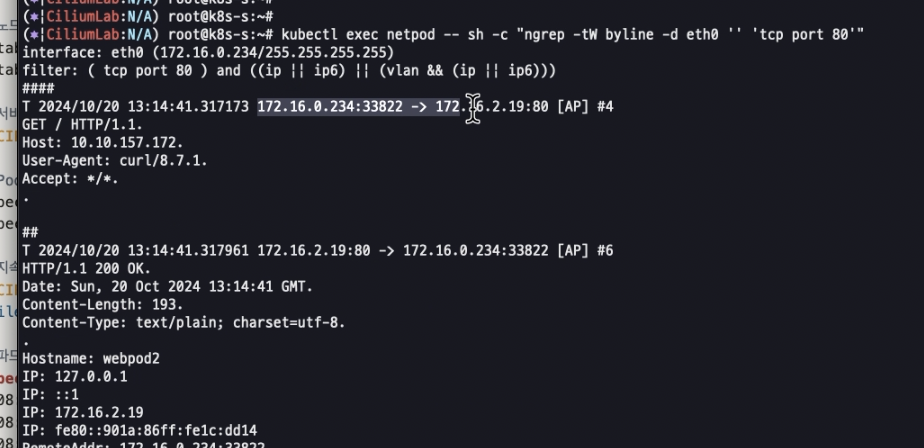

kubectl exec netpod -- sh -c "ngrep -tW byline -d eth0 '' 'tcp port 80'"

T 2024/10/20 08:07:36.663329 172.16.0.132:59964 -> 172.16.1.53:80 [AP] #34

GET / HTTP/1.1.

Host: 10.10.124.15.

User-Agent: curl/8.7.1.

Accept: */*.

# 서비스 정보 확인

c0 service list

ID Frontend Service Type Backend

16 10.108.12.195:80 ClusterIP 1 => 172.16.2.157:80

2 => 172.16.1.234:80

c0 bpf lb list

SERVICE ADDRESS BACKEND ADDRESS

10.108.12.195:80 0.0.0.0:0 (16) [ClusterIP, non-routable]

172.16.1.234:80 (16)

172.16.2.157:80 (16)

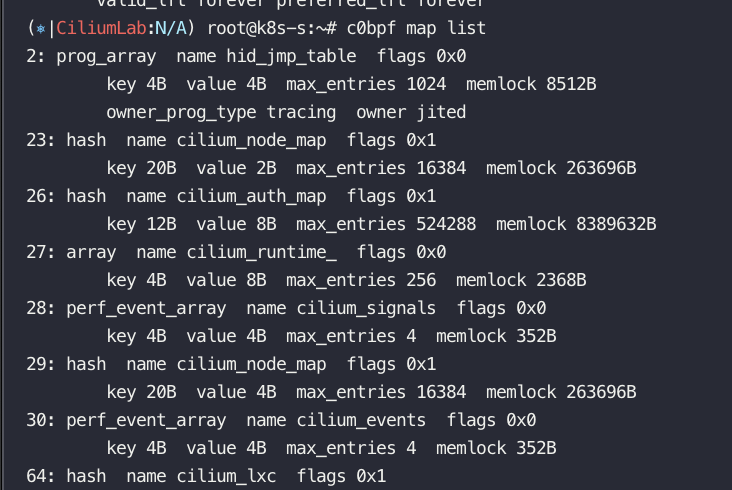

# BPF maps

c0 map list --verbose

c0 map list --verbose | grep lb

c0 map get cilium_lb4_services_v2

c0 map get cilium_lb4_backends_v3

c0 map get cilium_lb4_reverse_nat

c0 map get cilium_lb4_reverse_sk

c0 map get cilium_lxc

c0 map get cilium_ipcache

따라하다 ㅜ 네트워크가 끊겨서 ㅜㅜ 설정이 다 날아가서ㅜ 영상 캡쳐로 대체

pod 내에서 tcpdump 떠도 -> clusterip 노출 안됨

이미 pod의 ip로 바뀌어있음

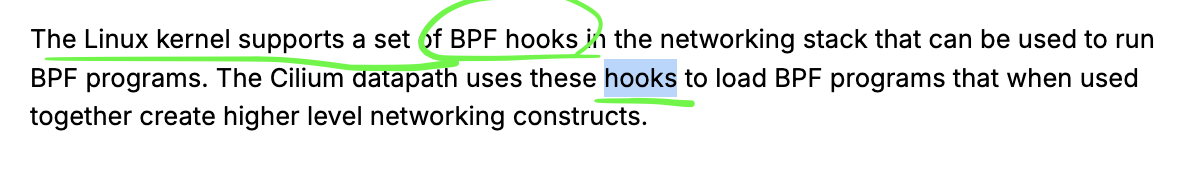

kube-proxy 없이 socket 기반 로드밸런싱(ebpf)

이미 여기서 바뀜

hook을 통해서 바로 바꿔버림 하지만,

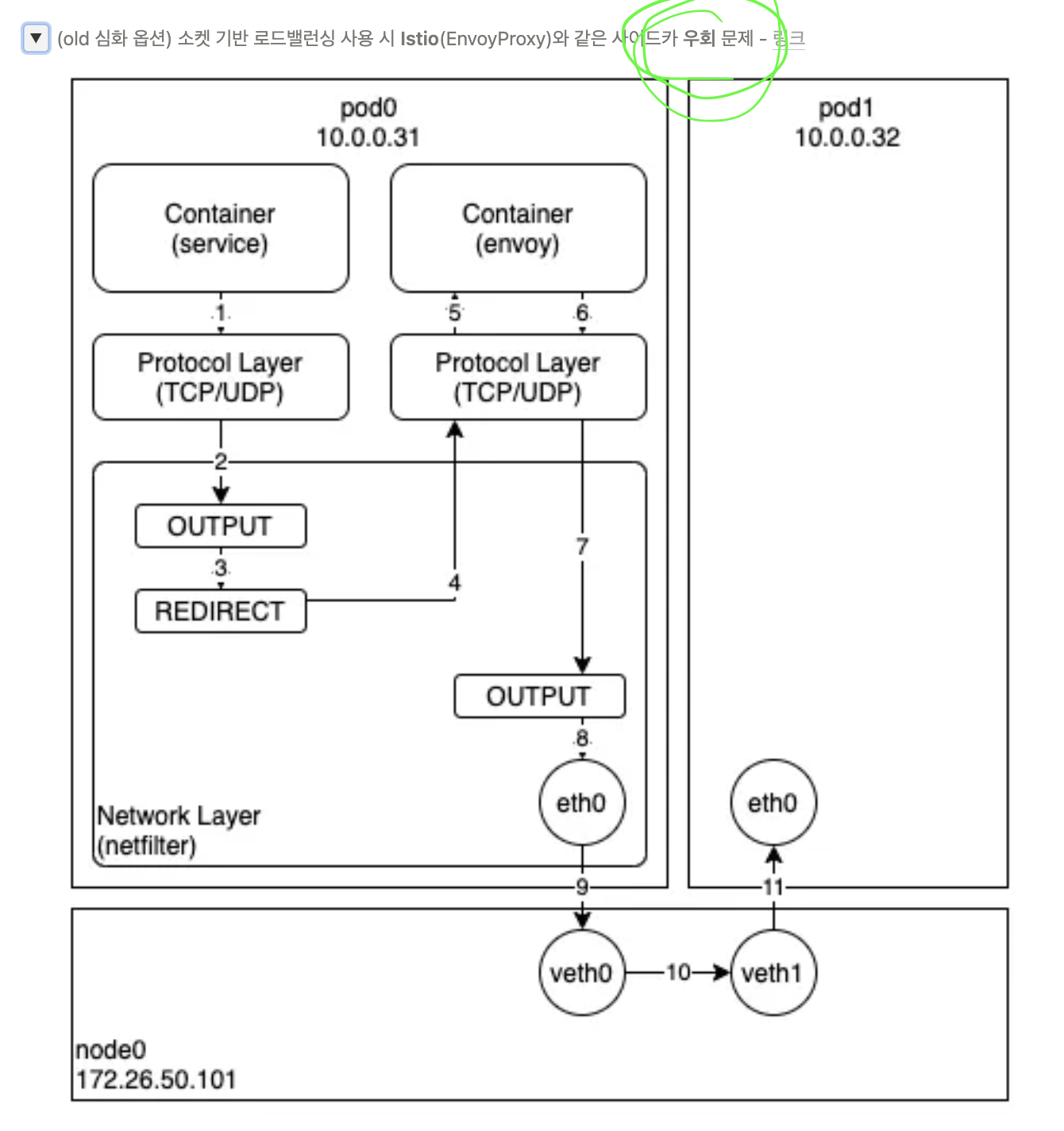

아까 위에서도 언급했지만

소켓 기반의 로드밸런싱을 쓰면 -> istio envoy proxy를 우회 해버리는 경우가 있어서

helm upgrade cilium cilium/cilium --version $VERSION --namespace kube-system --reuse-values --set hostServices.hostNamespaceOnly=true

소켓 기반 로드밸런싱을 못하게 막아버리는 옵션이 잇음. 그래서 cilium의 이러한 옵션들이 많음

ebpf가 속도자체가 빠르고, 신기술이긴 하지만, 같이 사용하는 기술들이 ebpf의 이러한 모든 특성을 고려하지 않았기 때문에 신기술이 나오면 파생, 같이 쓰는 기술들이 유기적으로 발전해야한다.

======================================================================================

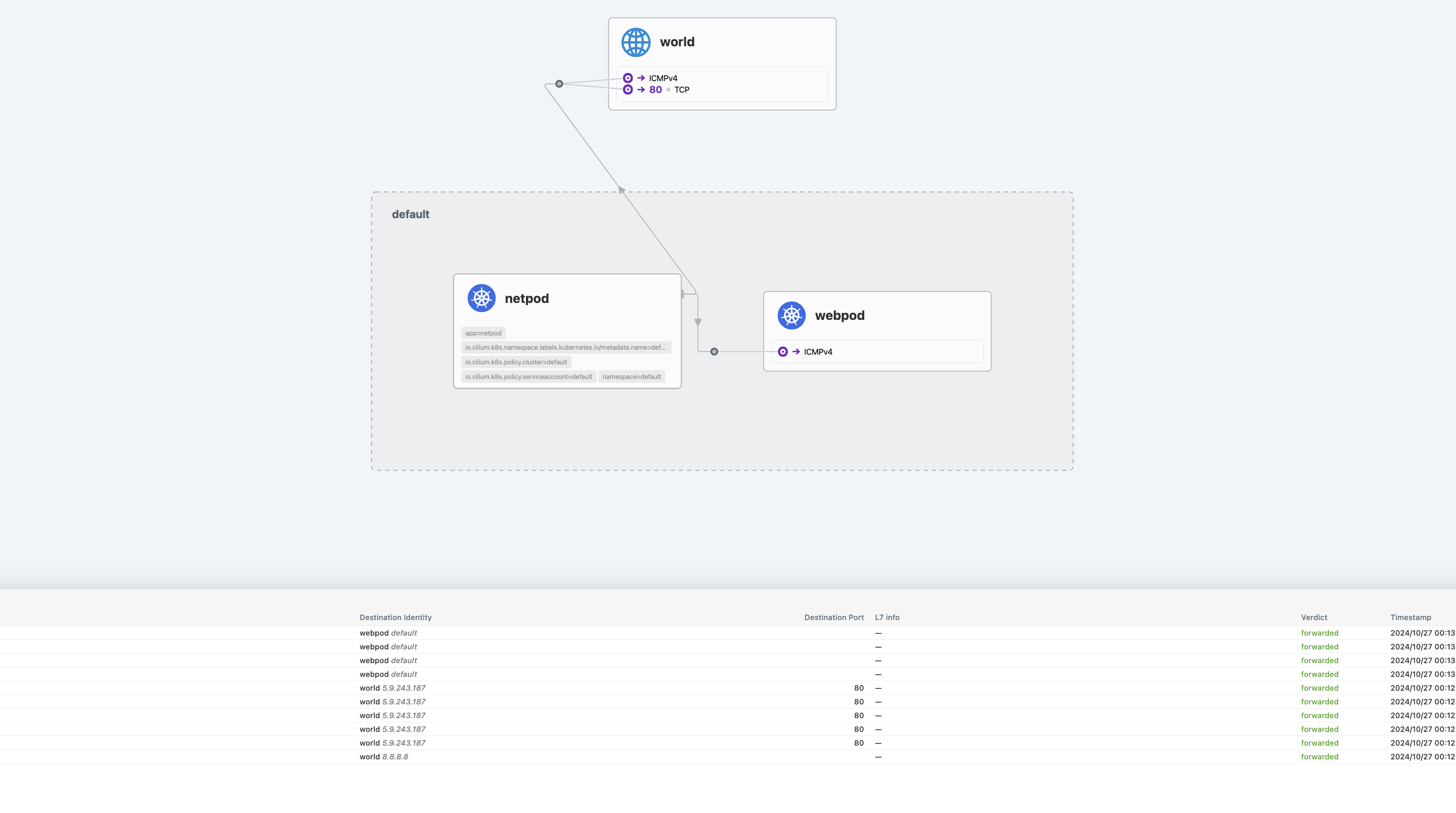

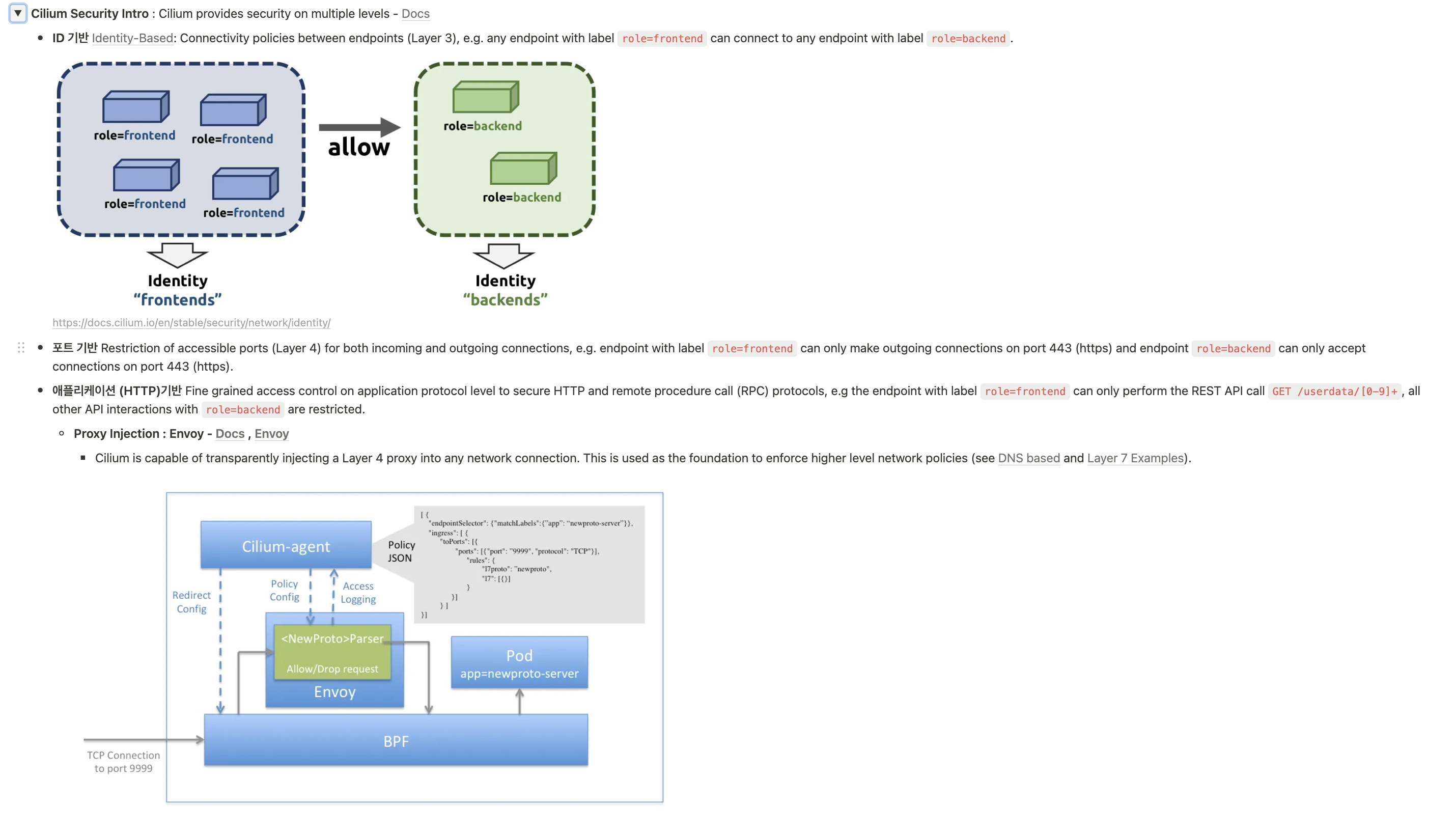

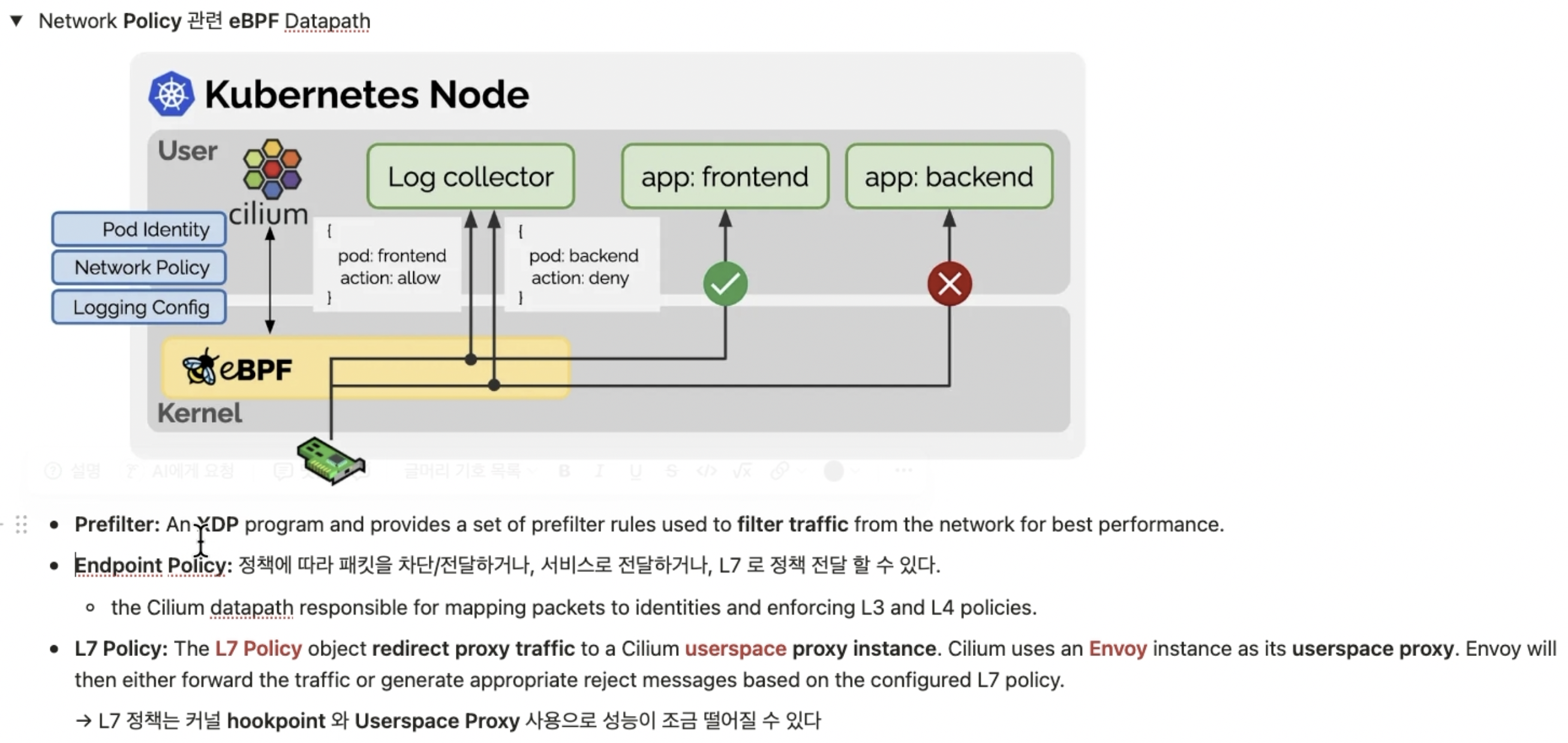

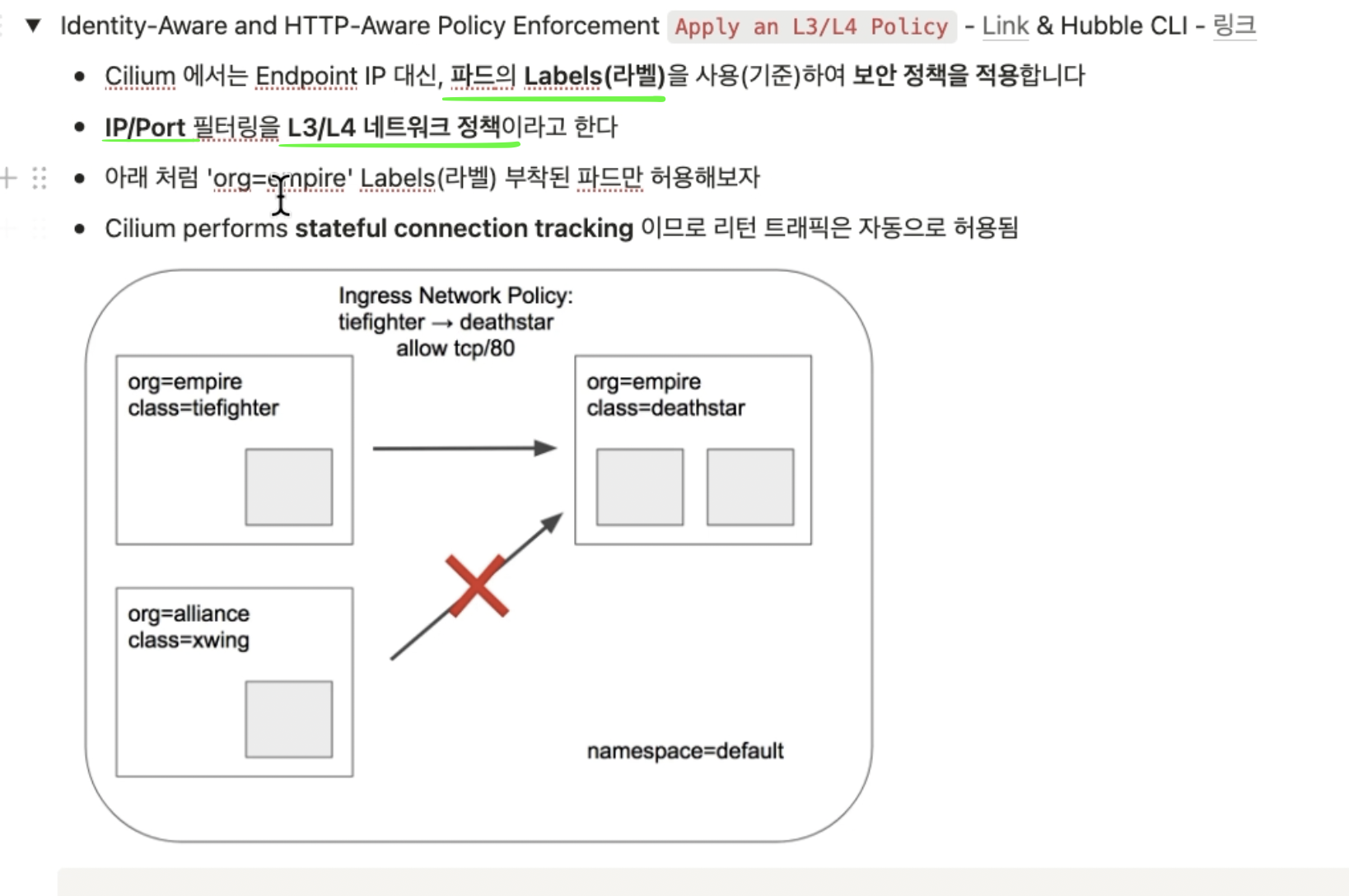

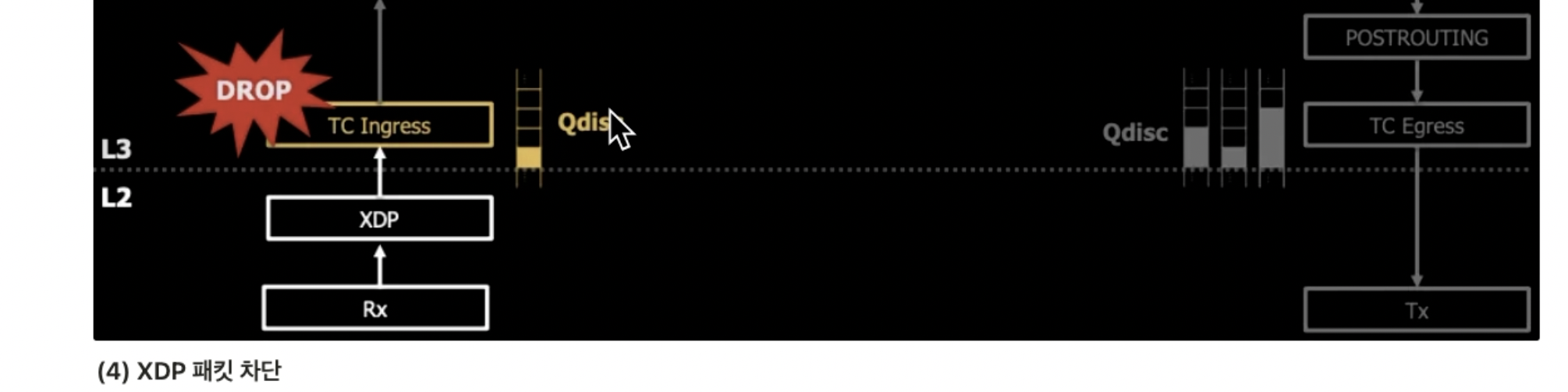

네트워크 policy

크게 3가지 레벨의 보안을 제공함

1) ID 기반

2) 포트기반

3) 애플리케이션 기반(http)

1) 번 내용 보충

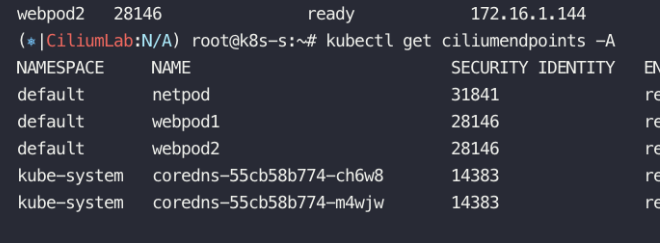

endpoints 조회 했을때 등장한 SEcurity identity

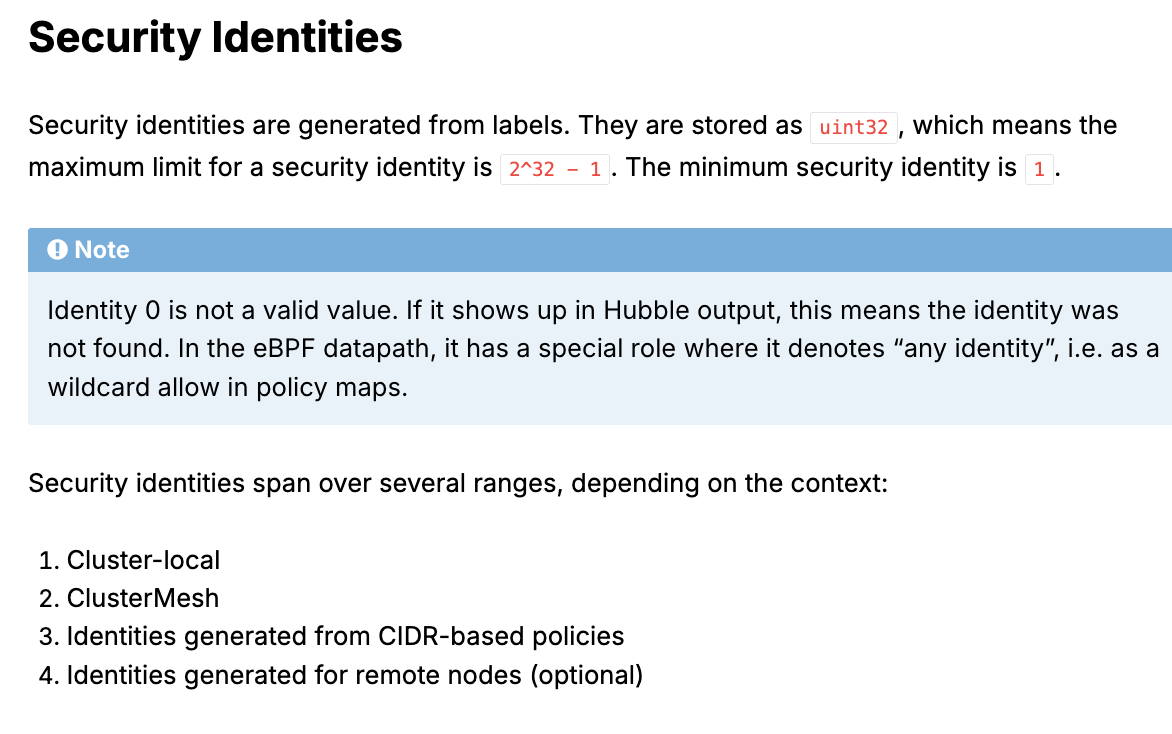

Security Identities는 label을 통해서 만들어짐

eBPF 데이터 경로에서는 Identity 0이 특별한 역할을 가짐. 일반적으로 0이라는 아이덴티티 값은 **'유효한 아이덴티티가 없다'**는 의미로 사용되지만, eBPF 환경에서는 정책 맵에서 일종의 와일드카드 역할을 하여 모든 아이덴티티를 허용하는 의미로 해석됨. 즉, 특정 아이덴티티로 제한하지 않고 모든 아이덴티티를 포함시키는 기능을 수행함.

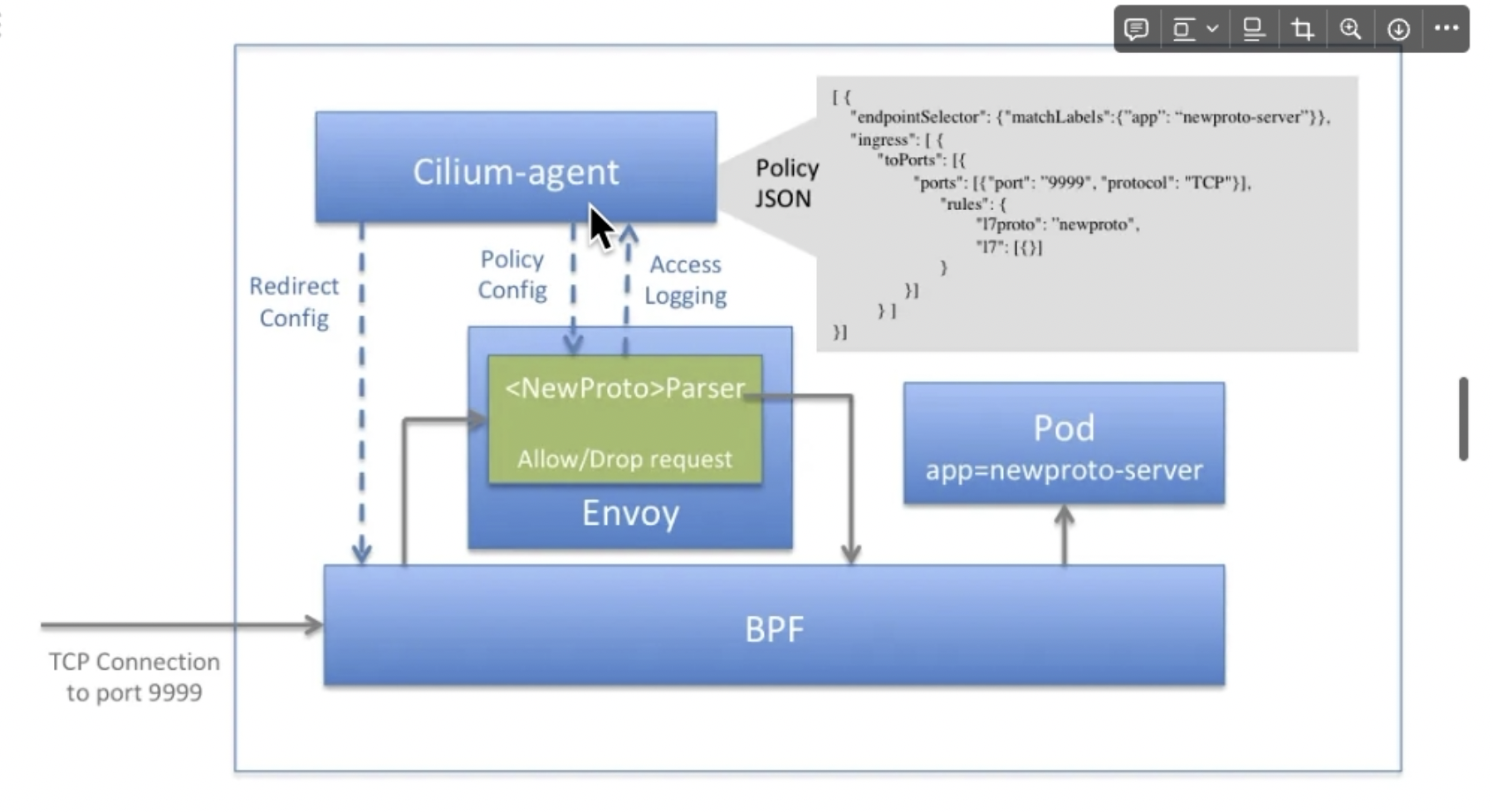

3) 애플리케이션 기반(http) 에 해당되는 내용

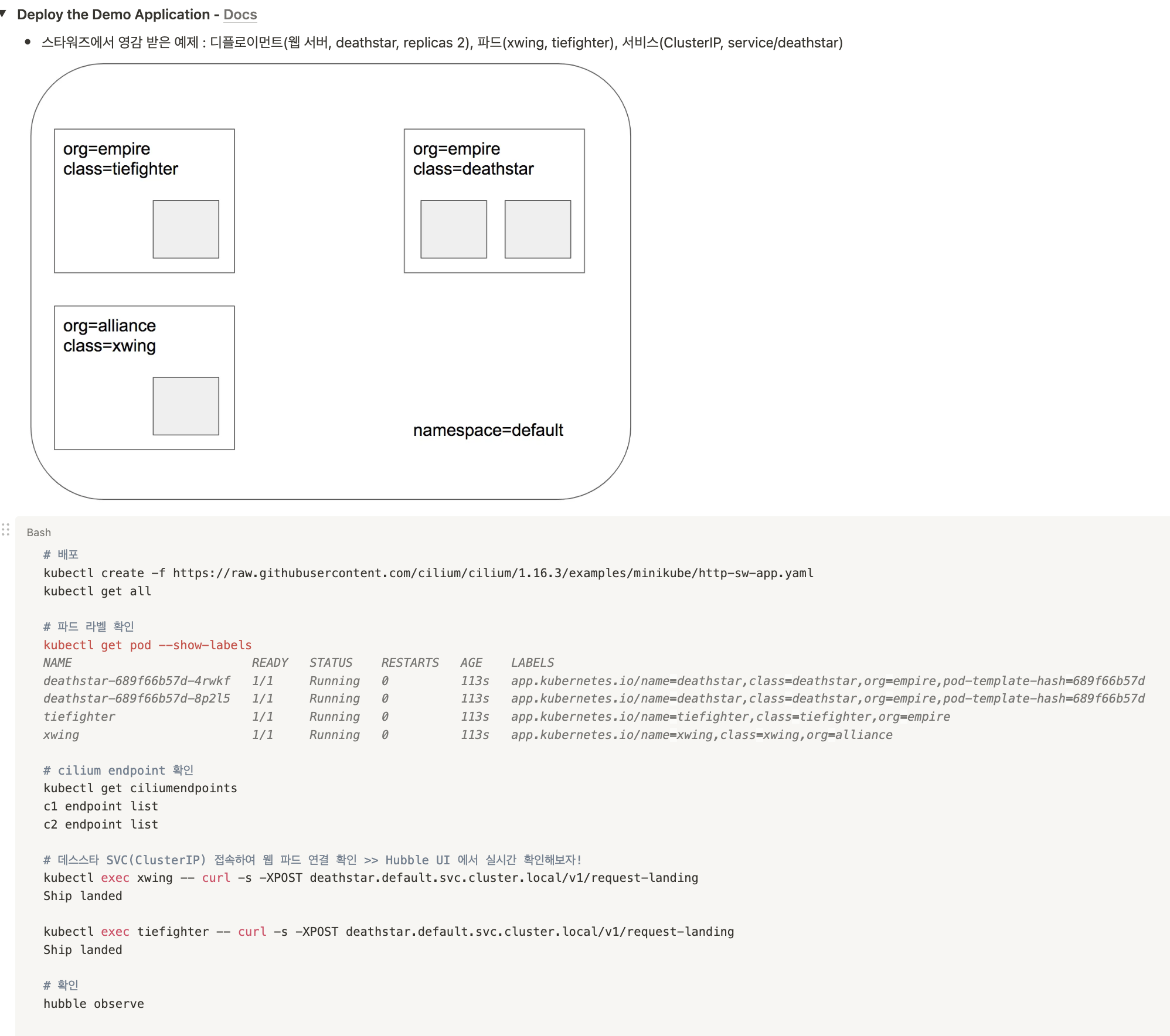

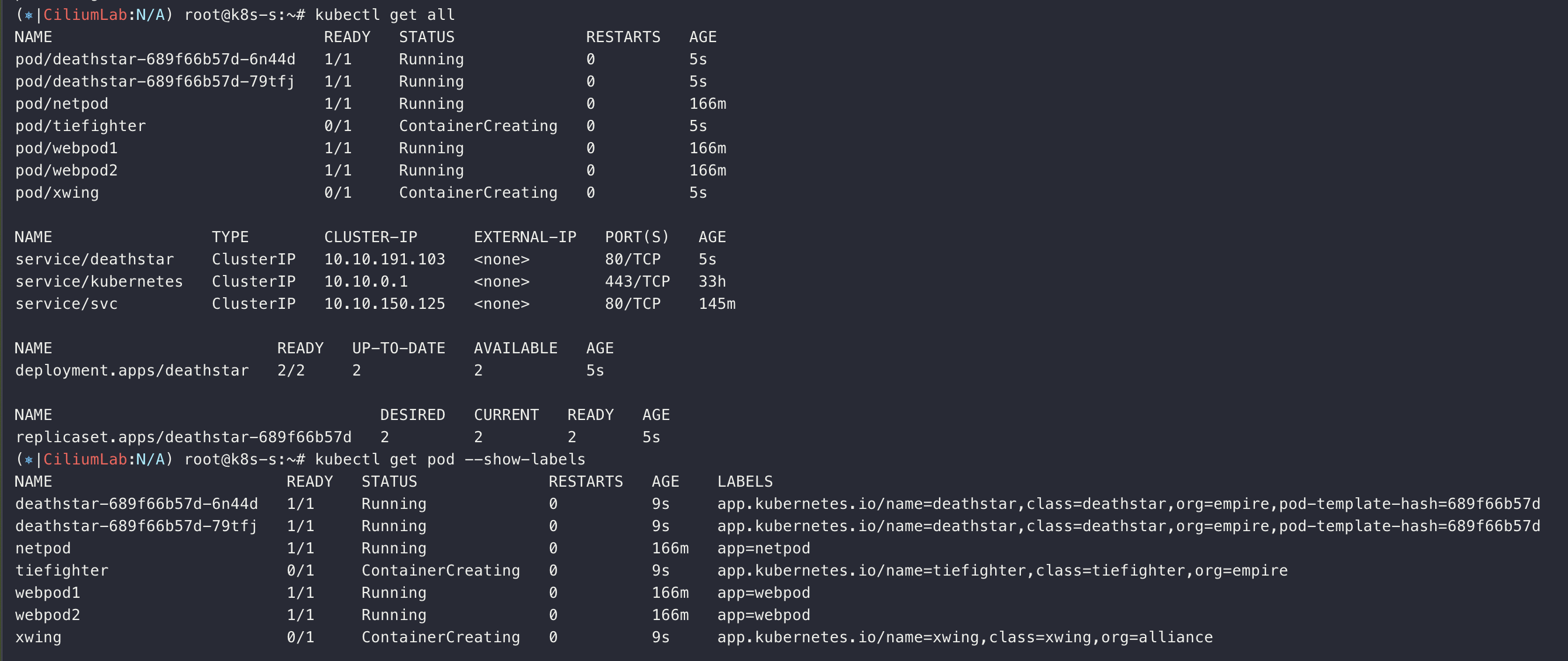

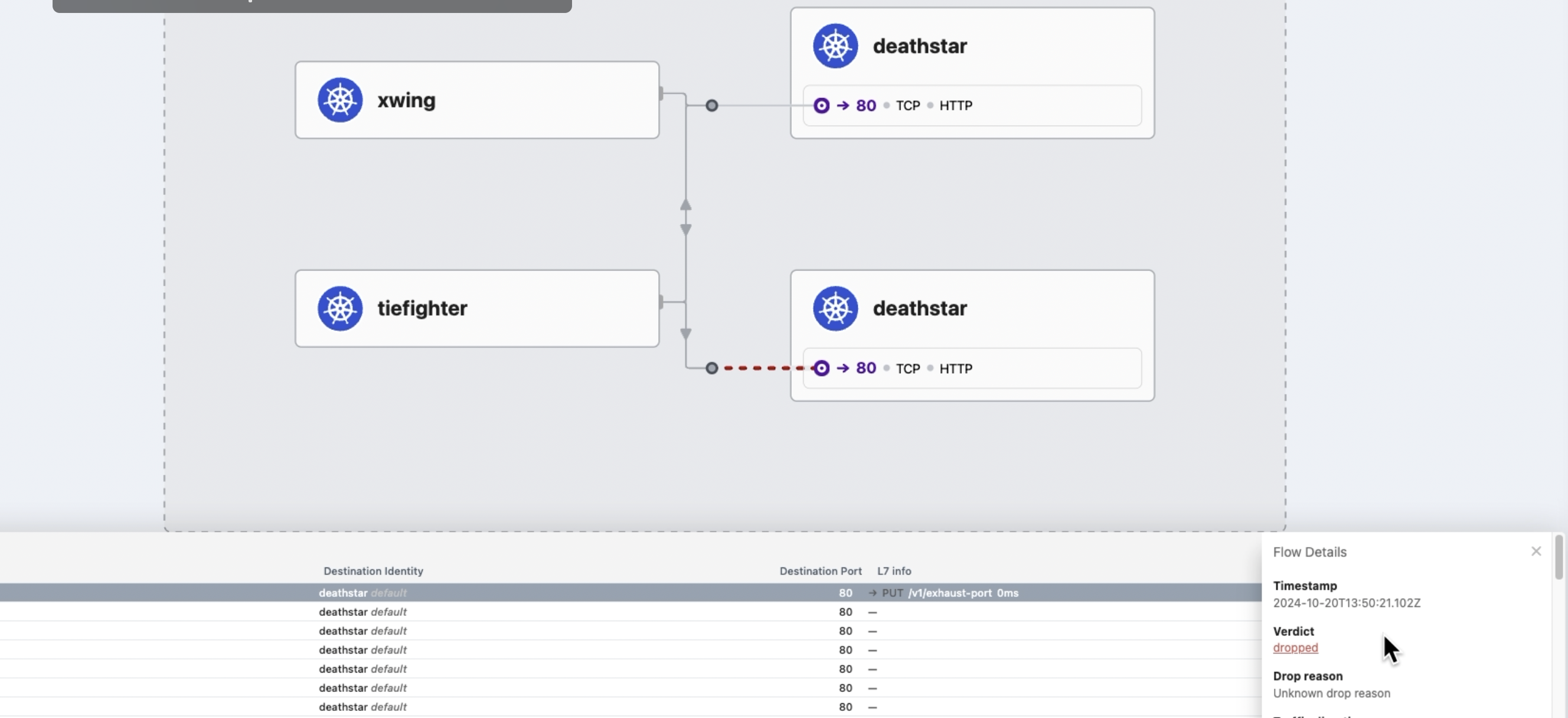

<스타워즈 실습>

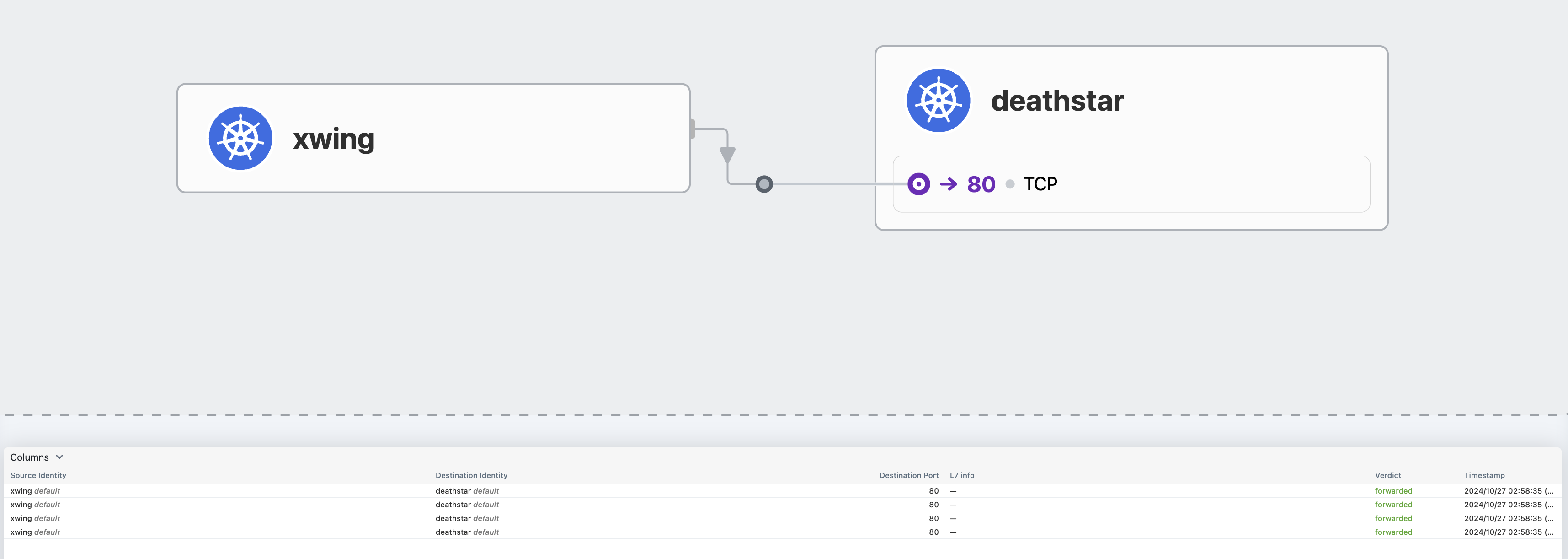

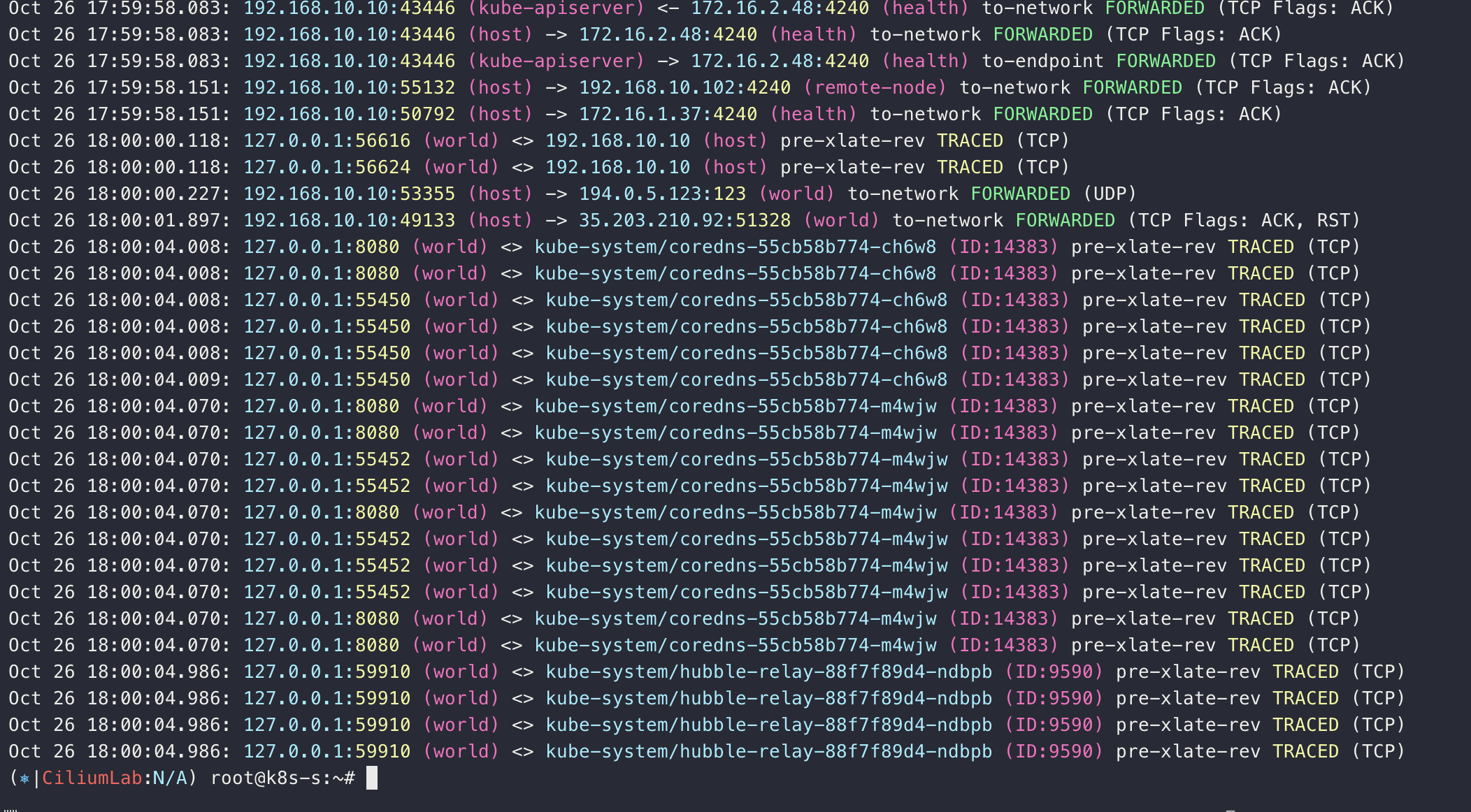

ship landed

hubble observe

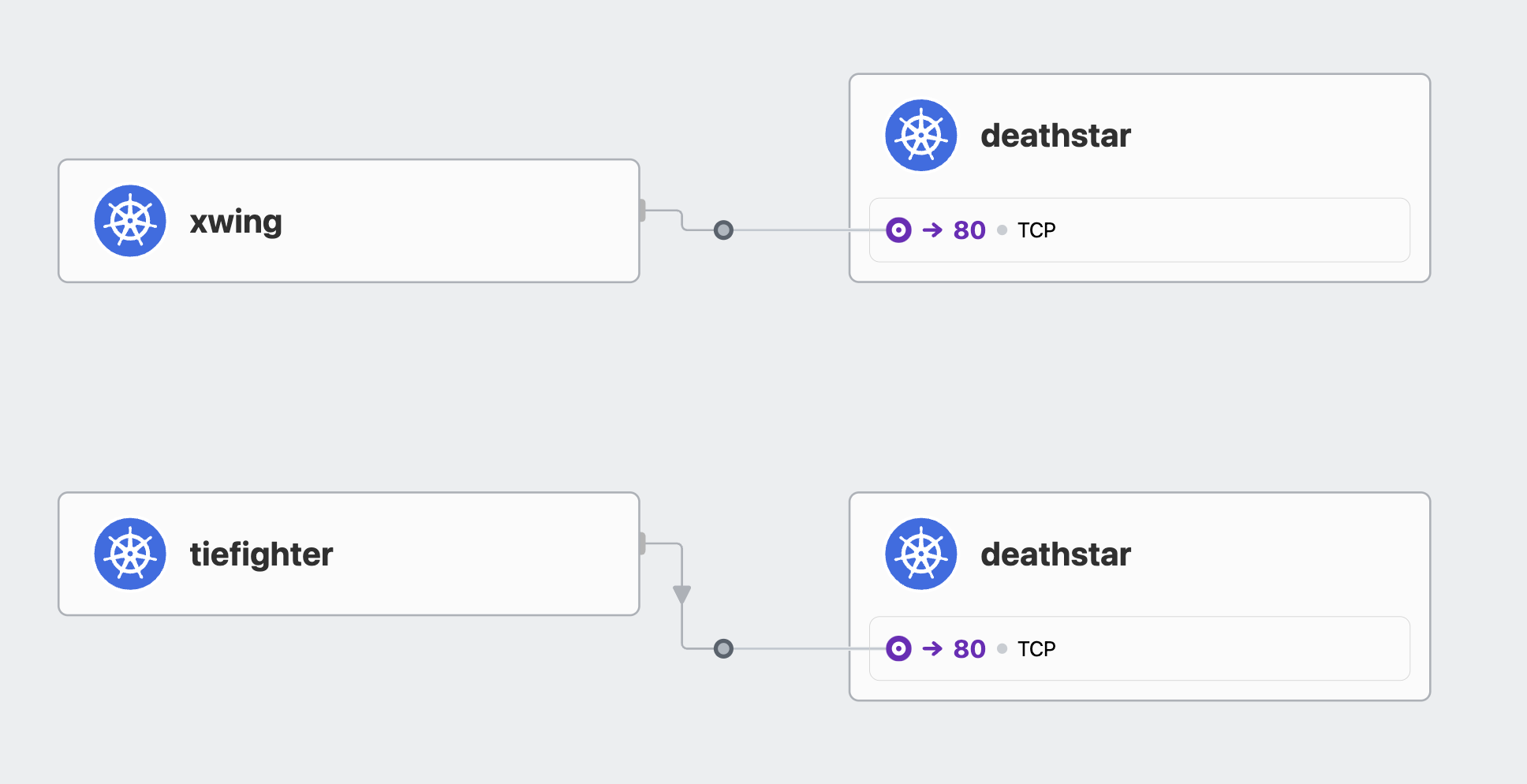

L3/L4 policy 적용

ip는 변경되니까 라벨로

# L3/L4 정책 생성

cat <<EOF | kubectl apply -f -

apiVersion: "cilium.io/v2"

kind: CiliumNetworkPolicy

metadata:

name: "rule1"

spec:

description: "L3-L4 policy to restrict deathstar access to empire ships only"

endpointSelector:

matchLabels:

org: empire

class: deathstar

ingress:

- fromEndpoints:

- matchLabels:

org: empire

toPorts:

- ports:

- port: "80"

protocol: TCP

EOF

# 정책 확인

kubectl get cnp

kc describe cnp rule1

c0 policy get

# 파드 curl 접속 시도 시 파드 sh 접속 후 curl 시도하자!

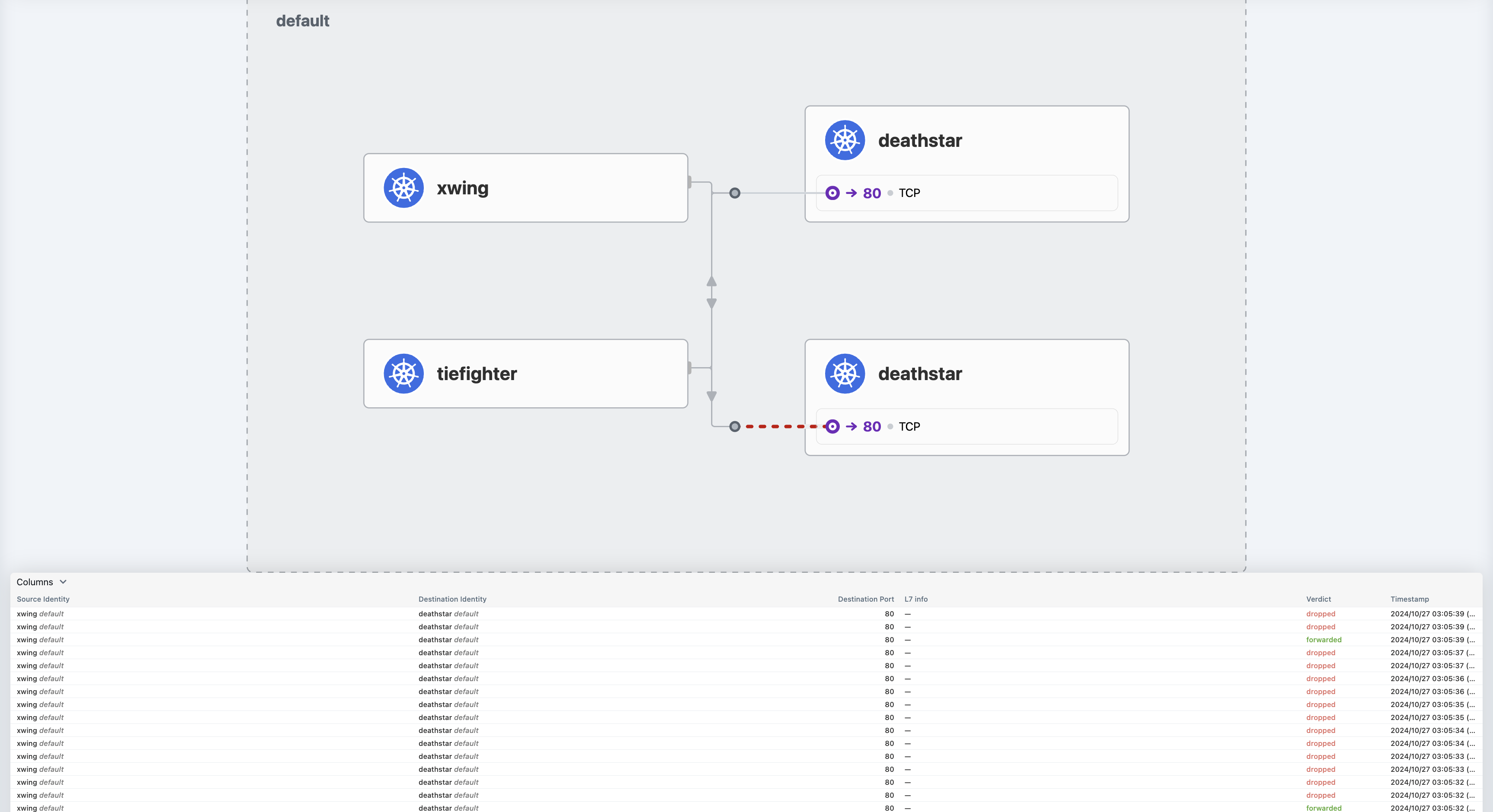

# 데스스타 SVC(ClusterIP) 접속하여 웹 파드 연결 확인 >> Hubble UI 에서 drop 확인!

kubectl exec tiefighter -- curl -s -XPOST deathstar.default.svc.cluster.local/v1/request-landing

Ship landed

kubectl exec xwing -- curl -s -XPOST deathstar.default.svc.cluster.local/v1/request-landing

drop

# hubble cli 모니터링

hubble observe --pod xwing

hubble observe --pod tiefighter

hubble observe --pod deathstar

Dec 2 05:36:24.490: default/xwing:55464 <> default/deathstar-c74d84667-t7msh:80 Policy denied DROPPED (TCP Flags: SYN)

Dec 2 05:36:24.490: default/xwing:55464 <> default/deathstar-c74d84667-t7msh:80 Policy denied DROPPED (TCP Flags: SYN)

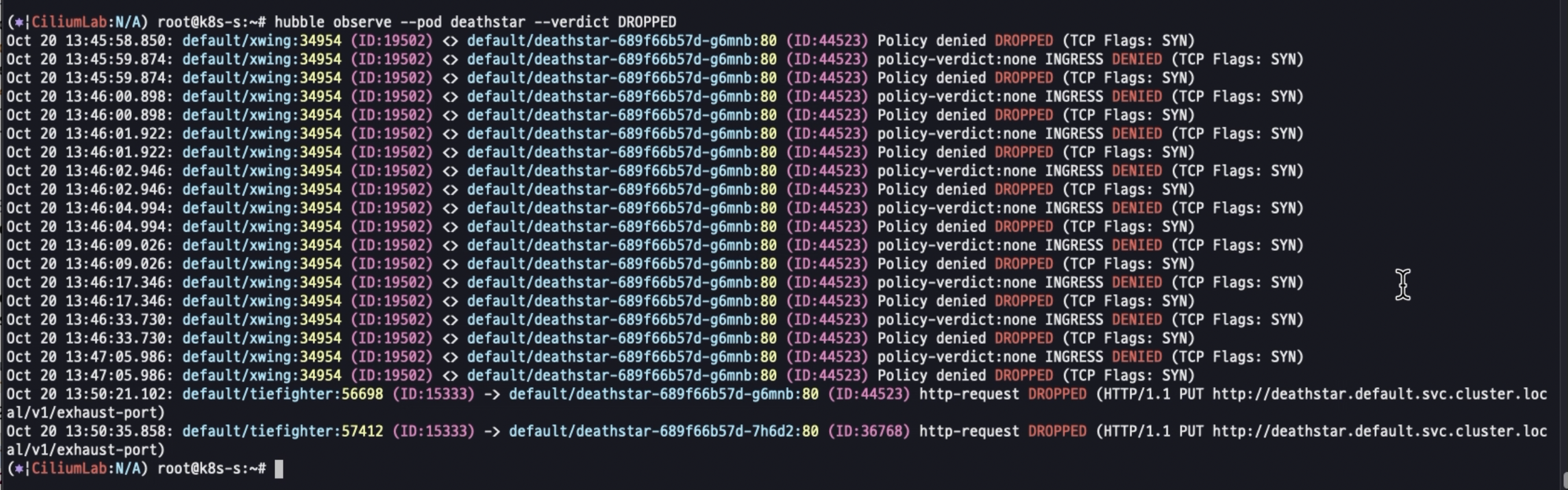

hubble observe --pod deathstar --verdict DROPPED

Nov 30 15:23:47.721: default/xwing:60086 <> default/deathstar-c74d84667-ksnbd:80 Policy denied DROPPED (TCP Flags: SYN)

Nov 30 15:23:47.721: default/xwing:60086 <> default/deathstar-c74d84667-ksnbd:80 Policy denied DROPPED (TCP Flags: SYN)

Nov 30 15:27:40.250: default/tiefighter:41656 -> default/deathstar-c74d84667-ksnbd:80 http-request DROPPED (HTTP/1.1 PUT http://deathstar.default.svc.cluster.local/v1/exhaust-port)

Nov 30 15:28:00.707: default/tiefighter:41666 -> default/deathstar-c74d84667-ksnbd:80 http-request DROPPED (HTTP/1.1 PUT http://deathstar.default.svc.cluster.local/v1/exhaust-port)

Inspecting the Policy

# If we run cilium endpoint list again we will see that the pods with the label org=empire and class=deathstar

# now have ingress policy enforcement enabled as per the policy above.

# endpoint list 에서 정책 적용 확인

c1 endpoint list | grep deathstar

c2 endpoint list

ENDPOINT POLICY (ingress) POLICY (egress) IDENTITY LABELS (source:key[=value]) IPv6 IPv4 STATUS

ENFORCEMENT ENFORCEMENT

312 Disabled Disabled 18300 k8s:class=xwing 172.16.2.161 ready

k8s:io.cilium.k8s.namespace.labels.kubernetes.io/metadata.name=default

k8s:io.cilium.k8s.policy.cluster=default

k8s:io.cilium.k8s.policy.serviceaccount=default

k8s:io.kubernetes.pod.namespace=default

k8s:org=alliance

1972 Enabled Disabled 21144 k8s:class=deathstar 172.16.2.66 ready

k8s:io.cilium.k8s.namespace.labels.kubernetes.io/metadata.name=default

k8s:io.cilium.k8s.policy.cluster=default

k8s:io.cilium.k8s.policy.serviceaccount=default

k8s:io.kubernetes.pod.namespace=default

k8s:org=empirec2 endpoint list

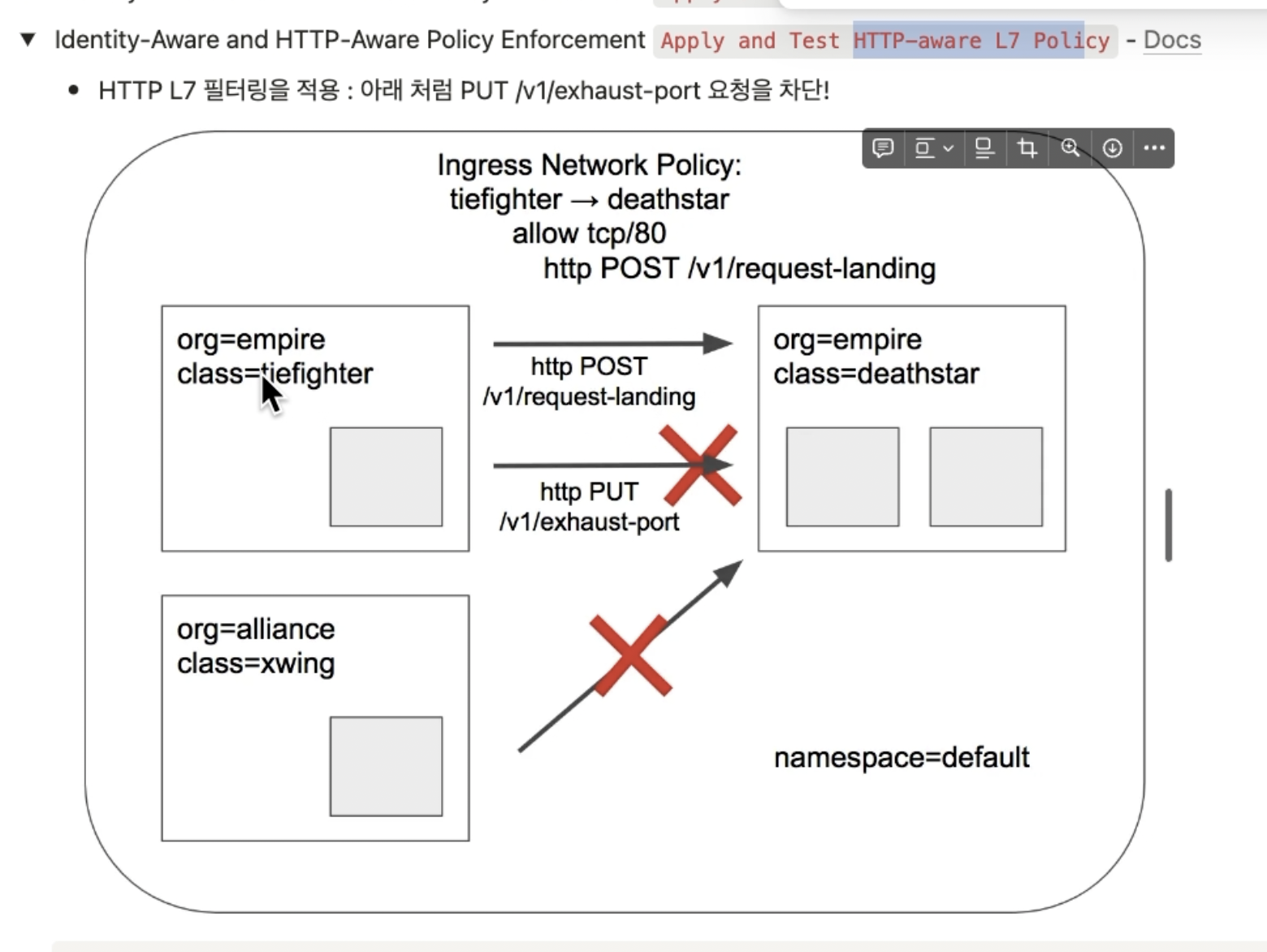

L7 네트워크 정책

# 데스스타 SVC(ClusterIP) 접속

kubectl exec tiefighter -- curl -s -XPUT deathstar.default.svc.cluster.local/v1/exhaust-port

Panic: deathstar exploded

...

# POST /v1/request-landing API 호출만 허용 정책으로 기존 정책 내용을 업데이트(configured)!

cat <<EOF | kubectl apply -f -

apiVersion: "cilium.io/v2"

kind: CiliumNetworkPolicy

metadata:

name: "rule1"

spec:

description: "L7 policy to restrict access to specific HTTP call"

endpointSelector:

matchLabels:

org: empire

class: deathstar

ingress:

- fromEndpoints:

- matchLabels:

org: empire

toPorts:

- ports:

- port: "80"

protocol: TCP

rules:

http:

- method: "POST"

path: "/v1/request-landing"

EOF

# 정책 확인

kc describe ciliumnetworkpolicies

c0 policy get

# 모니터링

c1 monitor -v --type l7

c2 monitor -v --type l7

<- Request http from 0 ([k8s:io.cilium.k8s.policy.cluster=default k8s:io.cilium.k8s.policy.serviceaccount=default k8s:io.kubernetes.pod.namespace=default k8s:org=empire k8s:class=tiefighter k8s:io.cilium.k8s.namespace.labels.kubernetes.io/metadata.name=default]) to 1972 ([k8s:class=deathstar k8s:org=empire k8s:io.cilium.k8s.namespace.labels.kubernetes.io/metadata.name=default k8s:io.kubernetes.pod.namespace=default k8s:io.cilium.k8s.policy.serviceaccount=default k8s:io.cilium.k8s.policy.cluster=default]), identity 42720->21144, verdict Denied PUT http://deathstar.default.svc.cluster.local/v1/exhaust-port => 403

=> 403

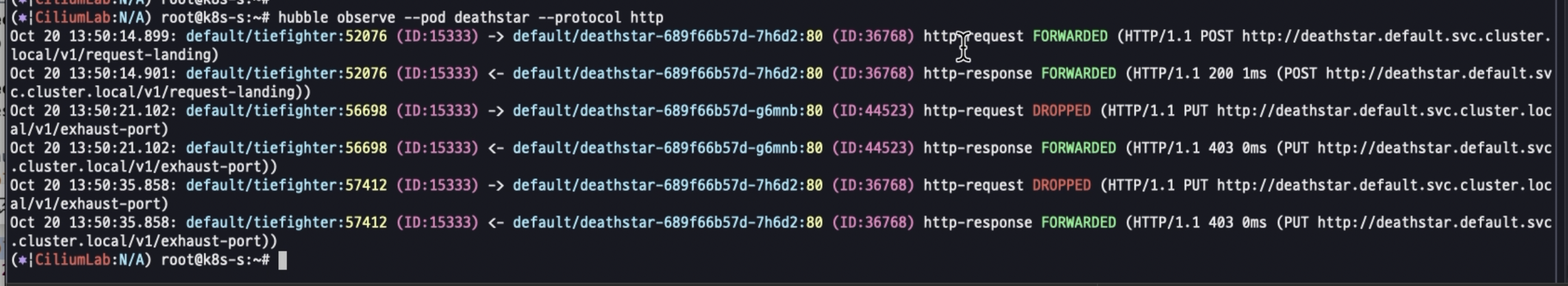

hubble observe --pod deathstar

hubble observe --pod deathstar --verdict DROPPED

# 접근 테스트

kubectl exec tiefighter -- curl -s -XPOST deathstar.default.svc.cluster.local/v1/request-landing

Ship landed

kubectl exec tiefighter -- curl -s -XPUT deathstar.default.svc.cluster.local/v1/exhaust-port

Access denied

## hubble cli 에 차단 로그 확인

hubble observe --pod deathstar --verdict DROPPED

Feb 28 11:39:59.078: default/tiefighter:33762 -> default/deathstar-c74d84667-lf2wl:80 http-request DROPPED (HTTP/1.1 PUT http://deathstar.default.svc.cluster.local/v1/exhaust-port)

hubble observe --pod deathstar --protocol http

Feb 28 12:05:22.095: default/tiefighter:40428 -> default/deathstar-6f87496b94-cvv9r:80 http-request DROPPED (HTTP/1.1 PUT http://deathstar.default.svc.cluster.local/v1/exhaust-port)

# 삭제

kubectl delete -f https://raw.githubusercontent.com/cilium/cilium/1.16.3/examples/minikube/http-sw-app.yaml

kubectl delete cnp rule1

=======================================================================================

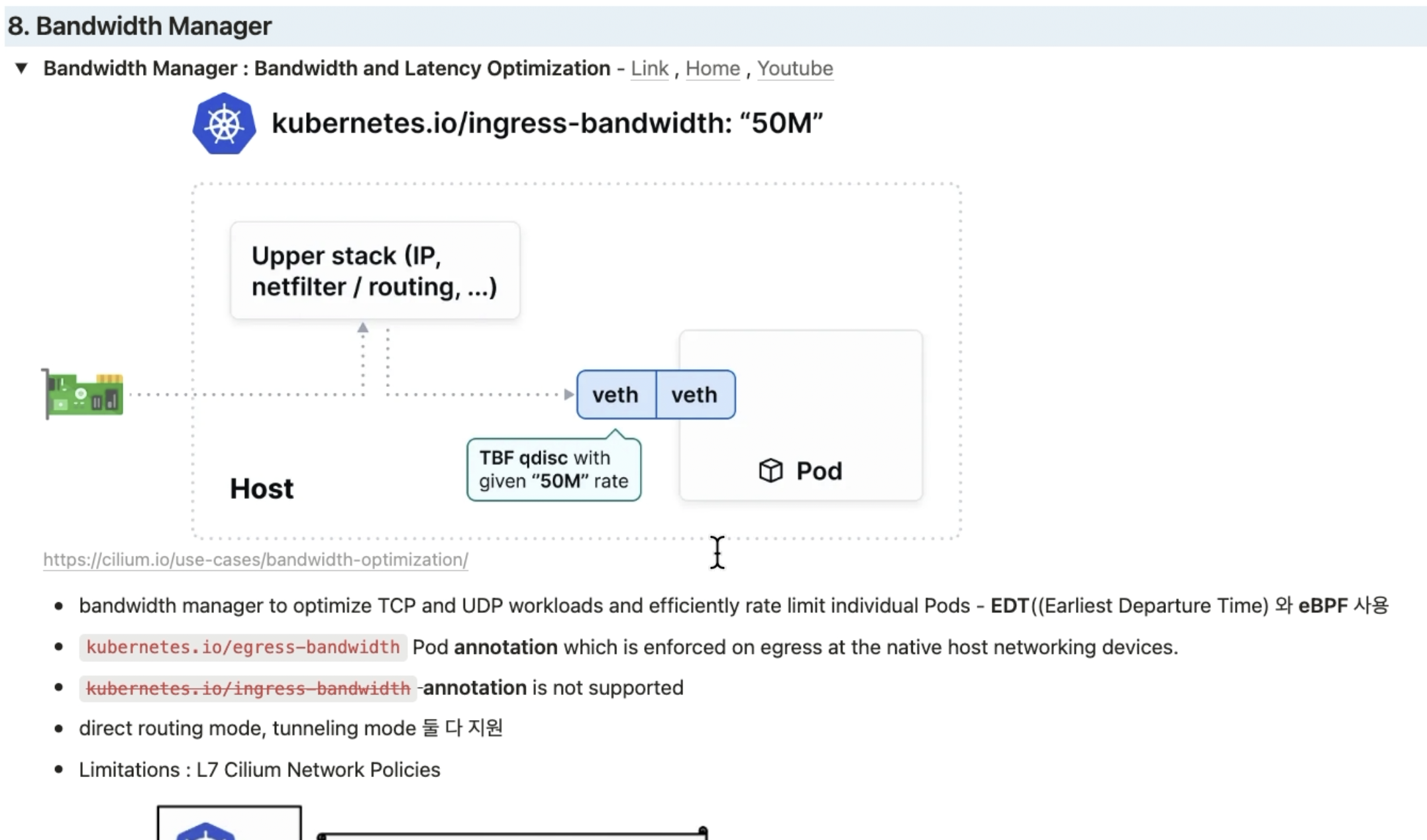

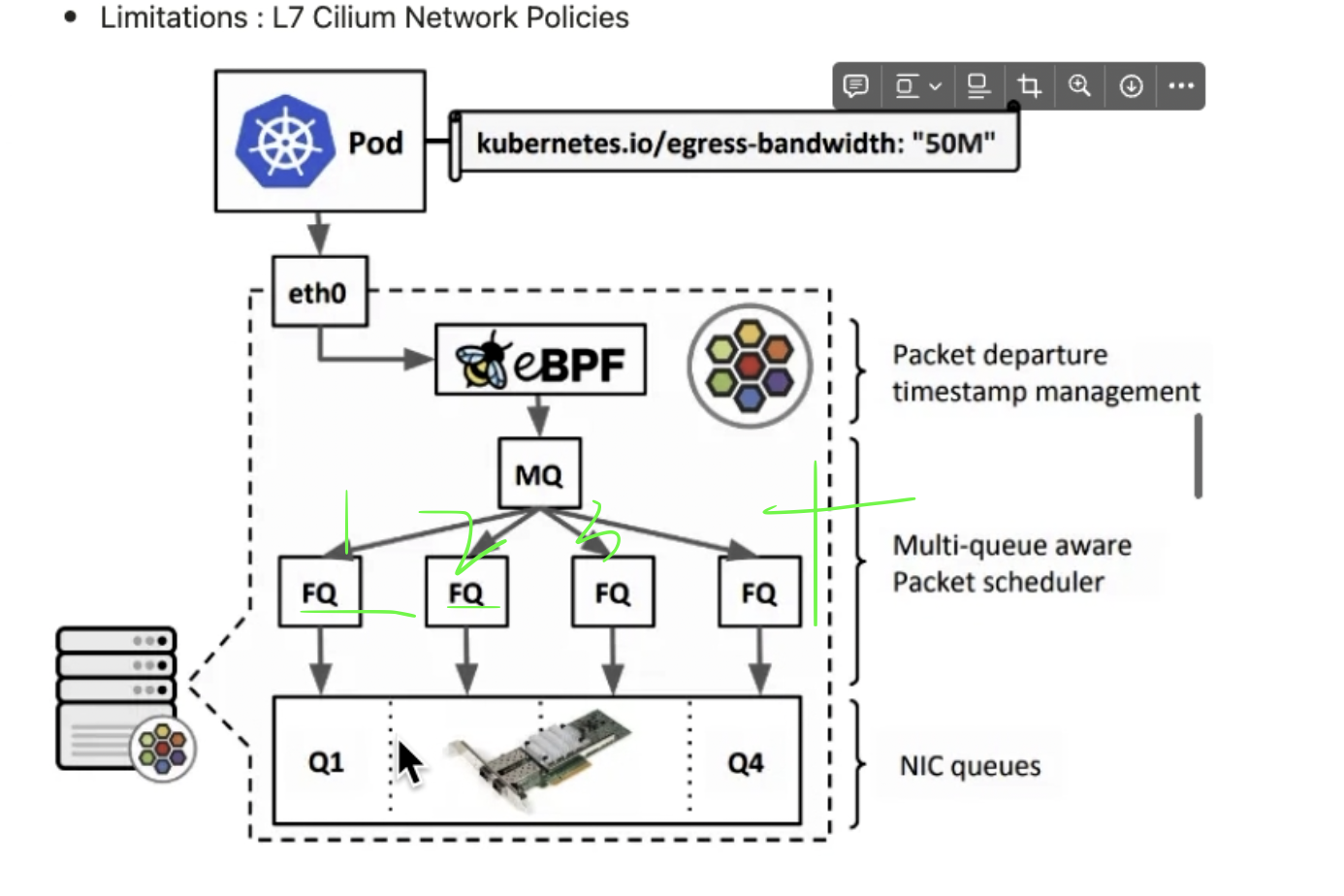

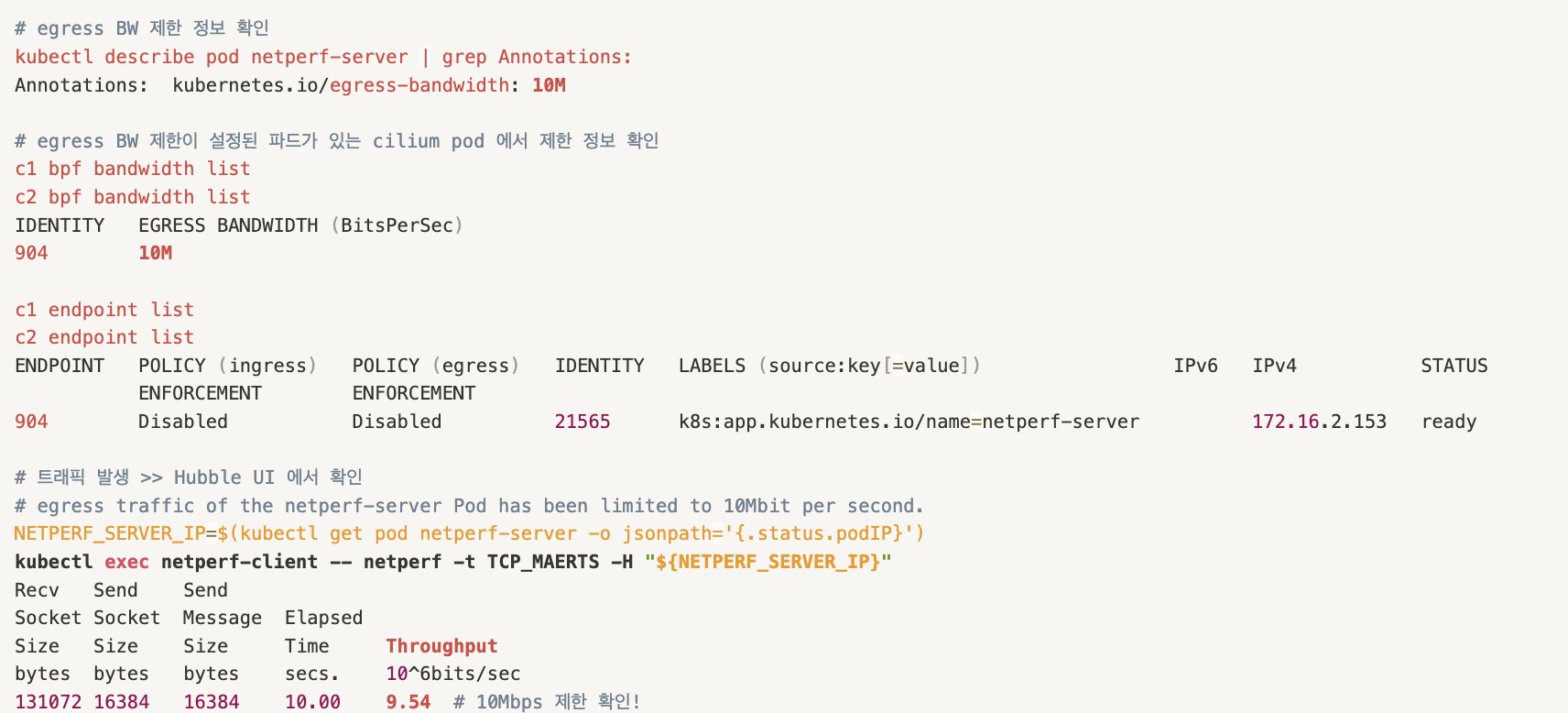

Bandwith Manager - 크게 보면 QOS 장비

egress만 지원

# 인터페이스 tc qdisc 확인

tc qdisc show dev ens5

qdisc mq 0: root

qdisc fq_codel 0: parent :4 limit 10240p flows 1024 quantum 1514 target 5ms interval 100ms memory_limit 32Mb ecn drop_batch 64

qdisc fq_codel 0: parent :3 limit 10240p flows 1024 quantum 1514 target 5ms interval 100ms memory_limit 32Mb ecn drop_batch 64

qdisc fq_codel 0: parent :2 limit 10240p flows 1024 quantum 1514 target 5ms interval 100ms memory_limit 32Mb ecn drop_batch 64

qdisc fq_codel 0: parent :1 limit 10240p flows 1024 quantum 1514 target 5ms interval 100ms memory_limit 32Mb ecn drop_batch 64

# 설정

helm upgrade cilium cilium/cilium --namespace kube-system --reuse-values --set bandwidthManager.enabled=true

# 적용 확인

cilium config view | grep bandwidth

enable-bandwidth-manager true

# egress bandwidth limitation 동작하는 인터페이스 확인

c0 status | grep BandwidthManager

BandwidthManager: EDT with BPF [CUBIC] [ens5]

# 인터페이스 tc qdisc 확인 : 설정 전후 옵션값들이 상당히 추가된다

tc qdisc

tc qdisc show dev ens5

qdisc mq 8002: root

qdisc fq 8005: parent 8002:2 limit 10000p flow_limit 100p buckets 32768 orphan_mask 1023 quantum 18030b initial_quantum 90150b low_rate_threshold 550Kbit refill_delay 40ms timer_slack 10us horizon 2s horizon_drop

qdisc fq 8003: parent 8002:4 limit 10000p flow_limit 100p buckets 32768 orphan_mask 1023 quantum 18030b initial_quantum 90150b low_rate_threshold 550Kbit refill_delay 40ms timer_slack 10us horizon 2s horizon_drop

qdisc fq 8004: parent 8002:3 limit 10000p flow_limit 100p buckets 32768 orphan_mask 1023 quantum 18030b initial_quantum 90150b low_rate_threshold 550Kbit refill_delay 40ms timer_slack 10us horizon 2s horizon_drop

qdisc fq 8006: parent 8002:1 limit 10000p flow_limit 100p buckets 32768 orphan_mask 1023 quantum 18030b initial_quantum 90150b low_rate_threshold 550Kbit refill_delay 40ms timer_slack 10us horizon 2s horizon_drop

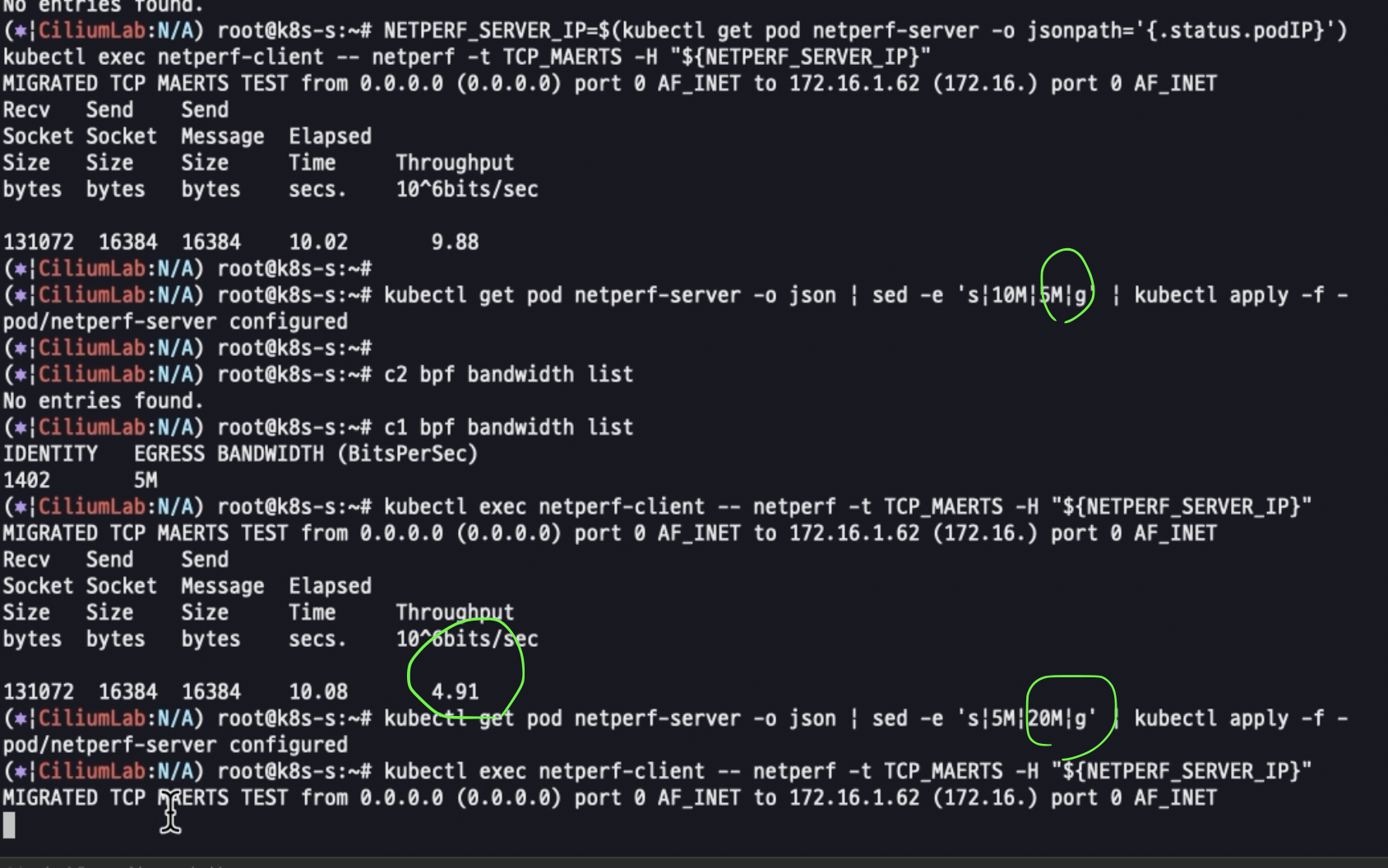

제한 확인함

설정바꿔가면서 제한 먹히는지 테스트

=======================================================================================

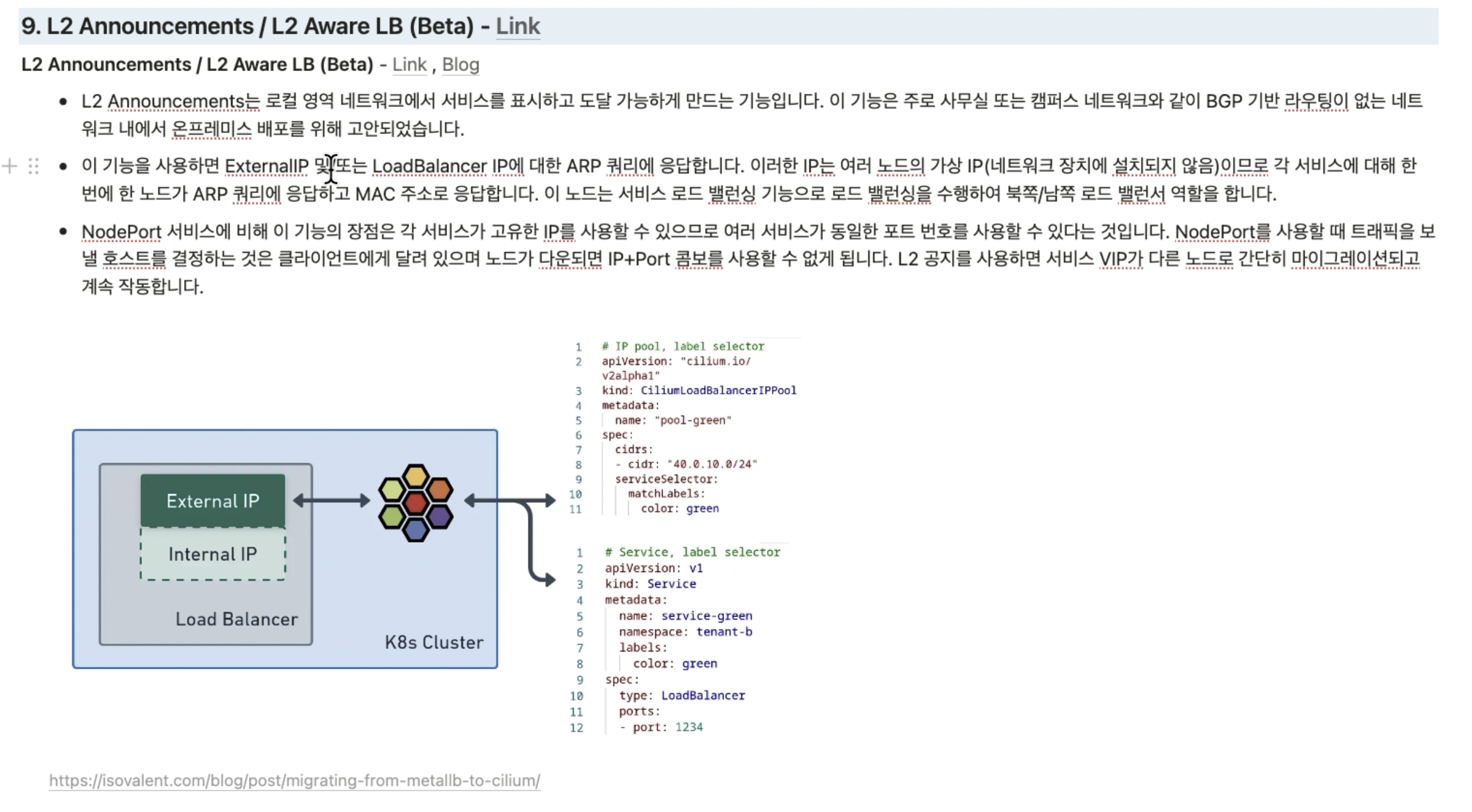

MetaLB 역할도 수행

#

helm upgrade cilium cilium/cilium --namespace kube-system --reuse-values \

--set l2announcements.enabled=true --set externalIPs.enabled=true \

--set l2announcements.leaseDuration=3s --set l2announcements.leaseRenewDeadline=1s --set l2announcements.leaseRetryPeriod=200ms

#

c0 config --all |grep L2

EnableL2Announcements : true

EnableL2NeighDiscovery : true

# CiliumL2AnnouncementPolicy 생성

cat <<EOF | kubectl apply -f -

apiVersion: "cilium.io/v2alpha1"

kind: CiliumL2AnnouncementPolicy

metadata:

name: policy1

spec:

serviceSelector:

matchLabels:

color: blue

nodeSelector:

matchExpressions:

- key: node-role.kubernetes.io/control-plane

operator: DoesNotExist

interfaces:

- ^ens[0-9]+

externalIPs: true

loadBalancerIPs: true

EOF

# 확인

kubectl get ciliuml2announcementpolicy

kc describe l2announcement

#

cat <<EOF | kubectl apply -f -

apiVersion: "cilium.io/v2alpha1"

kind: CiliumLoadBalancerIPPool

metadata:

name: "cilium-pool"

spec:

allowFirstLastIPs: "No"

blocks:

- cidr: "10.10.200.0/29"

EOF

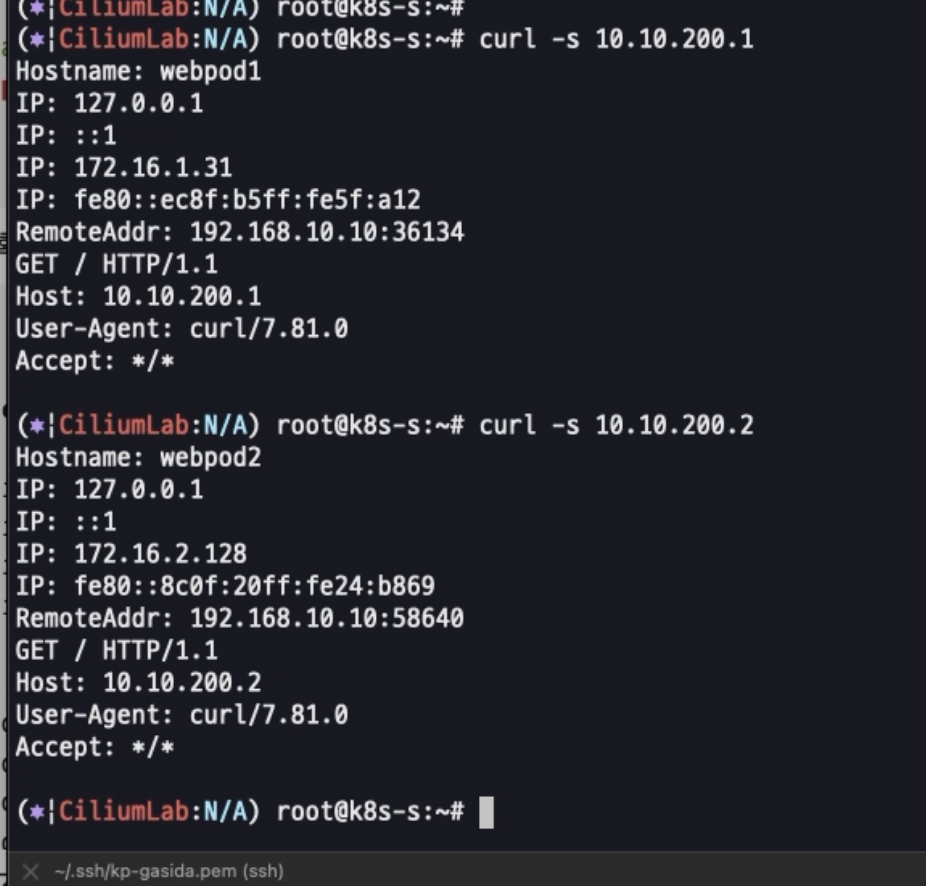

# cilium ip pool 조회

kubectl get CiliumLoadBalancerIPPool

NAME DISABLED CONFLICTING IPS AVAILABLE AGE

cilium-pool false False 3 3m5s

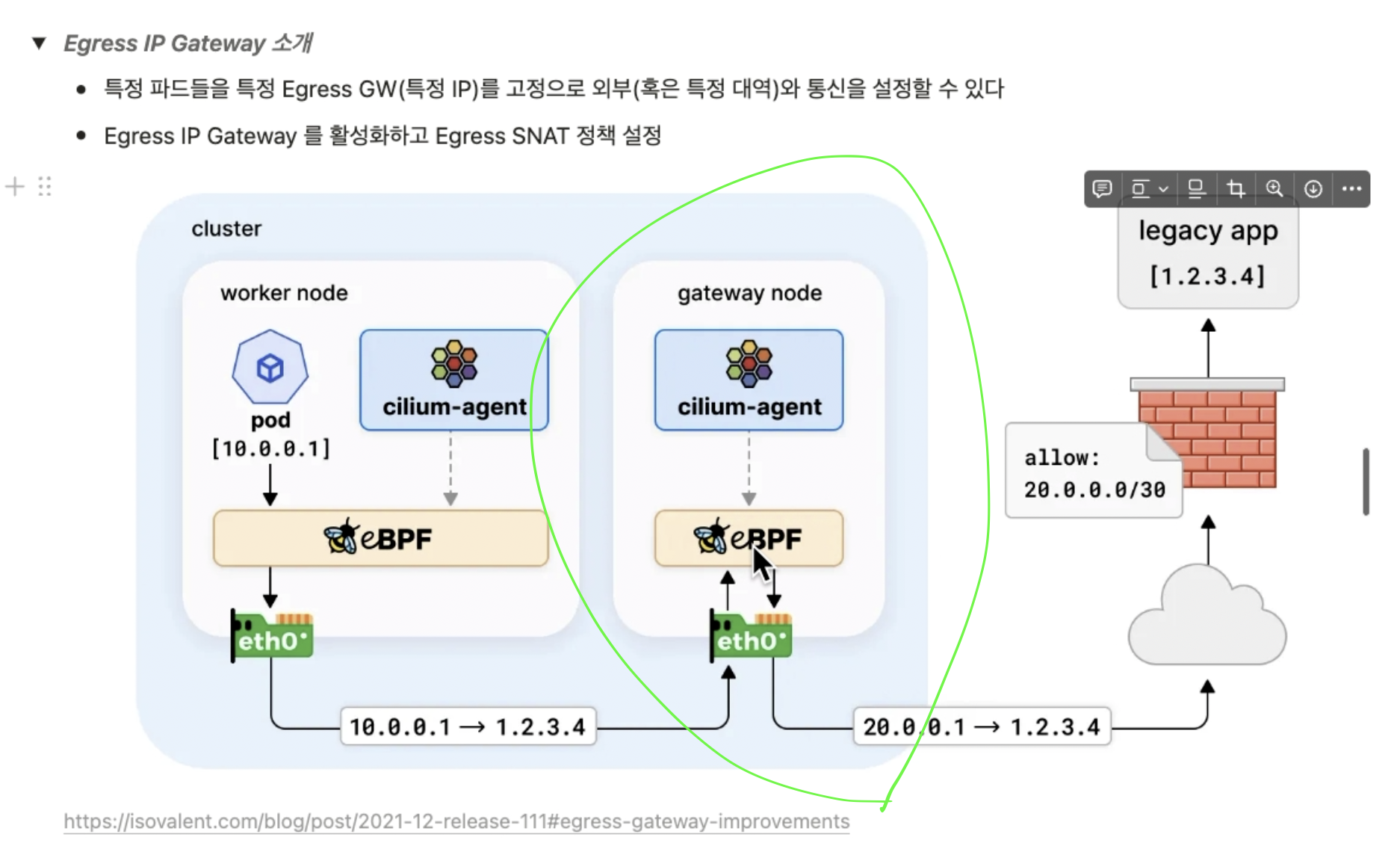

추가기능 Egress IP Gateway

외부 api를 사용할경우(b2b로)

서로 주고 받는 ip 고정시켜서 방화벽 열어주기 위해서 중간에 gateway node 사용

'Docker 및 k8s' 카테고리의 다른 글

| 네트워크 스터디 9주차 - 1 (0) | 2024.11.02 |

|---|---|

| 네트워크 스터디 7주차-1 (0) | 2024.10.18 |

| 네트워크 스터디 6주차 (0) | 2024.10.12 |

| 24년 10월 8일 AWS Operation Modernization Day(오프라인) - 역삼 센터필드 (0) | 2024.10.09 |

| 네트워크 스터디 5주차 (2) | 2024.10.06 |